Texto académico

Autores

Eduardo Ochoa Hernández

Nicolás Zamudio Hernández

Gladys Juárez Cisneros

Lizbeth Guadalupe Villalon Magallan

Pedro Gallegos Facio

Gerardo Sánchez Fernández

Rogelio Ochoa Barragán

_____________________________

1. Introducción a la cuántica

A cien años de una revolución científica de la física relativista y cuántica, presentamos este documento, como una iniciativa para comprender el desarrollo histórico desde Newton, Planck, Walther Nernst, Niels Bohr, Millikan, Max Jammer, Albert Einstein, Wien, en el estudio de la radiación de un cuerpo negro, el papel de la constante de Planck h, la contribución de Ernest Rutherford a la física atómica. Johann Balmer con la espectroscopia de líneas de hidrógeno fue un signo de cuantización. Todo ello para explicar la energía de salto de electrones, en una nube electrónica con incertidumbre y comportamiento azaroso. Desde el movimiento browniano, Rutherford encuentra un mecanismo matemático que especifica la muerte atómica, pero sería un recurso estadístico de tasa de probabilidad, instalando dentro del átomo la naturaleza de probabilidad en su estructura. Se hace referencia a la aleatoriedad cuántica y de probabilidad cuando el astrónomo británico Arthur Eddington, en texto “La naturaleza del mundo físico”. Cada una de las contribuciones de Einstein a la física cuántica muestran que era el maestro principal del siglo XX de termodinámica y mecánica estadística, campos newtonianos de probabilidad, aleatoriedad y la teoría de la norma estadística. Es lógico entonces pensar que fue él quien nos introdujo en el núcleo la teoría cuántica y escribe la base de la naturaleza cuántica, a pesar de sus protestas reflejadas en su frase “Dios no juega a los dados”.

Propósito. La cultura popular emplea avances de la física cuántica en la cotidianidad de las tecnologías de comunicaciones, computacionales y de la información, consume fármacos de la era de la biología cuántica molecular, pero desconoce el origen, los elementos fundamentales sobre los que descansan estas teorías, además, de las implicaciones de la termodinámica para asegurar que vivimos en un mundo de sistemas irreversibles y con un profundo efecto de incertidumbre en el corazón de la naturaleza.

1.1 El nacimiento de la mecánica cuántica

El físico austríaco Erwin Schrödinger propuso su famosa imagen del gato (1935), como un comentario sobre el fracaso de sus homólogos que se negaron a pensar a través de la mecánica cuántica. Para comprender la física de la luz en emisión y absorción, primero debemos entender el marco científico en que apareció el quantum, proporcionado por el trabajo de Isaac Newton hace más de tres siglos, conocimiento que vino a modificar la cultura en todas sus formas.

Newton cuando hizo la observación modesta: “que él estaba parado sobre los hombros de gigantes”. Estos hombros eran los aportes de otros hombres de ciencia y avances tecnológicos de la época, el creciente conocimiento mecánico y un aprecio social por las aplicaciones matemáticas para el mayor desarrollo social. Newton un producto social resultado de un contexto histórico y cultural concreto, fue un agente social burgués a favor de la industrialización y el control de la naturaleza. Sin embargo, el mundo lo conocería por su obra Mathematical Principles of Natural Philosophy (1787), el trabajo científico más influyente jamás escrito, detalla por primera vez las leyes de movimiento y de la atracción gravitacional universal. El mundo representado por Newton, es la segunda naturaleza para nosotros, desde la perspectiva de nuestra intuición, pero no lo fue para muchos de sus contemporáneos. Muchos encontraron difícil la idea que gobierna los cielos y la tierra, cuestionando ¿Cómo podría el sol mover planetas a millones de kilómetros de distancia? Newton dijo que no iba a inventar hipótesis sobre tales cosas, que buscaría en las matemáticas un poco de ciencia. Fue requerido un largo proceso de asimilación cultural para que la conversión newtoniana de la realidad fuera aceptada. Dio luz a un siglo de mitos y religiones castrantes en un momento histórico que exigía nuevas posibilidades para el futuro.

En resumen, Newton con elegancia e inteligencia unió los cielos con la tierra, ya no eran lugares separados cuyo espacio, tiempo y las leyes de movimiento simple y uniforme, eran lo mismo a diferentes escalas. Este nuevo paradigma hablaba de un universo homogéneo que no es gobernado por duendes, fantasmas o dioses impredecibles; todo tiene una identidad y está situada por el empuje de fuerzas que tiran en el espacio. El espacio es continuo en todo lugar y todos los eventos en este espacio son causados. Para entender cómo y por qué cambian las cosas en el universo, es modelado como partes de una cosa en movimiento, las personas de esa época atestiguaron que el universo tiene una lógica que lo gobierna.

La época newtoniana, representó un ideal intelectual de conocimiento autosuficiente frente a la autoridad moral, religiosa o política para entender este mundo. Los seres humanos con imaginación podrían hacer Imag1 de la mecánica de la realidad material, empleando matemáticas para cualquier escala del universo. Las fuerzas de atracción gravitacional entre cuerpos y leyes de movimiento permiten imaginar y calcular el viaje del hombre a la luna o naves de investigación a otros mundos del sistema solar. El movimiento para Newton puede ser explicado únicamente por los términos de fuerza y masa. Las mediciones newtonianas despreciaban la perturbación del instrumento sobre el sistema a medir. Es decir, los científicos imaginan que pueden observar desde afuera las medidas de un sistema sin alterarlo. Además, el tiempo de Newton fue una época en la que los científicos podían estudiar las leyes de la mecánica y hacer matemáticas sin referencia a propósitos militares o industriales. La propia luz es una corriente elástica de partículas diminutas, Newton ve al mundo en términos de partículas.

El trabajo de Newton implicó un nuevo papel para Dios, siendo creyente, asumió que su universo requiere de un arquitecto supremo, donde sus descripciones de la unidad del mundo, el diseño y la racionalidad fomentarían una mayor creencia en Dios. Sin embargo, la influencia de Newton fue fuerte en casi todos los aspectos de la cultura, la literatura, así como en la música, la política, filosofía y teología. Por otro lado, los humanos no se ven a sí mismos como autómatas de mecanismos y hay grietas sobre la reversibilidad del universo matemático de Newton.

La época newtoniana duró aproximadamente doscientos cincuenta años. Luego en 1900, fue emboscado este paradigma, su debilidad quedo al descubierto. Mientras los científicos estudiaban un aparentemente remoto rincón de la óptica, físicos encontraron que podían explicar lo que estaba sucediendo, solamente introduciendo una nueva idea extraña, completamente nueva, se trato del quantum. La idea era engañosamente simple, pero suficiente para romper los cimientos del mundo newtoniano. El ataque tiene dos momentos, el de 1900 y el de 1925. Pero dentro del periodo 1925 a 1927, es en el que intentaron domesticar a la cuántica, reduciéndola a relatividad; vieron frustrados sus intentos por esta nueva teoría con bases fundamentalmente diferentes de la física clásica, y cuya piedra angular fue el principio de incertidumbre. La mecánica cuántica, explica fenómenos que la mecánica newtoniana no lo hizo y responde a otros asuntos como la brillantes del sol y la dinámica de átomos, de esta forma la cuántica referida como una física de lo microscópico. Las diferencias no solo fueron en el manejo de escalas del micromundo y macromundo. Otra fue la homogeneidad, es decir, algunas de las cosas tienen otro tipo de presencia en el mundo respecto a otras, la discontinuidad, es decir, los valores de la propiedad como espacio y tiempo no fluyen una a la otra suavemente como lo pensó Newton. Un cuarto aspecto es la incertidumbre; algunas propiedades del universo de Newton como la posición y el momento, no pueden simultáneamente ser inmovilizados para su determinación.

Con el descubrimiento del principio de incertidumbre en 1927, surgieron persistentes esperanzas de regresar a un mundo explicado por ecuaciones deterministas, es decir, un mundo newtoniano. Este principio de incertidumbre es una pieza fundamental de la mecánica cuántica, el principio implicaba que es imposible saber simultáneamente la posición y el momento de una partícula dentro de una nube electrónica. El principio de incertidumbre reedificó conceptos como causa, azar, aleatoriedad y probabilidad. Por más que se esforzó Einstein por restaurar el mundo determinista newtoniano, todo fue inútil, la cuántica fue aceptada por la cultura como una nueva vía para evolucionar en un paso más en la conquista de la realidad.

¿Qué quiere decir el mundo cuántico?, ¿es sobre una nueva religión o es un nuevo inexplorado?, es como hacer contacto con un nuevo mundo. Después de más de un siglo todavía en general la gente no es nativa del quantum, somos inmigrantes culturales intentando hacer de sus implicaciones un proyecto de vida. La mecánica cuántica resulta extraña para la mayoría, porque pone en jaque a la intuición del sujeto. Es comprensible, pues la evolución ha adaptado nuestro cerebro para pensar y actuar en un mundo cuyas dimensiones y escalas de tiempo son newtonianos y los efectos cuánticos no son directamente sensibles para nosotros. Se han adaptado los sentidos sensoriales a este mundo, como una especie biológica madurada en él, como individuos y expresiones amarradas en el cómo nuestra mente procesa la experiencia de la gravedad, el movimiento y las causas-efectos. En este punto de vista nuevo, es un abismo insalvable, separa los mundos clásico y cuántico, por lo que encontramos a este último exótico e incomprensible. Esto para el aprendizaje es una zona de desajuste entre lo que esperamos y lo que sucede en la realidad cuántica. Pero hay una alternativa, esforzarse por ver que la rareza se deriva no del mundo cuántico, sino de nosotros. Las cosas son raras solo en contraste con lo familiar. Si lo que pensábamos como familiar, resultara ser una fantasía y contenido falso, el mundo cuántico más objetivo en contraste, no parece tan monstruoso, sino un paso en la evolución del conocimiento humano.

Newton es nuestro Colón, porque él nos llevó a un nuevo mundo, solo que fue una versión esquelética del propio ya vivido. Las únicas cosas son masas en movimiento, fuerzas de inicio y final. Sin embargo, Newton demostró que estos supuestos más elementales producen una visión del universo que es tan simple, elegante y completa que se le llamó el gran diseño. Newton nos mostró el gran diseño en su Principia 1687. Sus conceptos básicos son fuerza, masa y velocidad. Cada masa tiene una posición específica en un momento específico. Si se mueve, su tasa de cambio de posición con respecto al tiempo se llama velocidad. Si cambia su velocidad, la tasa de cambio respecto al tiempo es la aceleración. Cuando las masas se aceleran debido a las influencias de fuerzas, estas fuerzas surgen de la interacción entre cuerpos, ya sea por contacto o atracción/repulsión a distancia. Principia establece para el gran diseño tiene tres leyes del movimiento.

Primera Ley: Una masa que no es actuada por una fuerza permanece en reposo o continua moviéndose en modo rectilíneo uniforme. Si una masa empieza a moverse, o cambia su movimiento uniforme y rectilíneo, es que está siendo actuada por una fuerza.

Segunda Ley: La aceleración de una masa es proporcional a la fuerza que actúa sobre ella y en la misma dirección de esta fuerza. En la forma de ecuación F=ma.

Tercera Ley: La interacción entre cuerpos, dice que cada fuerza tiene un contrapeso. Como dijo Newton “a cada acción hay siempre una reacción opuesta e igual: o las acciones mutuas de dos cuerpos cada uno con el otro son siempre iguales y dirigidas a partes contrarias”.

Para predecir el futuro movimiento de una masa, o deducir su posición pasada, implica la elaboración de la regla de cálculo en cualquier momento para la velocidad de la masa, la velocidad a la que está cambiando su posición, aplicando estas tres leyes. Dada esa velocidad, se puede calcular hasta qué punto el objeto se mueve en cualquier intervalo de tiempo. La distancia es simplemente la magnitud de intervalo de tiempo multiplicado por la velocidad media bajo acción de una fuerza. La fuerza promedio sobre un intervalo de tiempo, multiplicado por la duración del periodo de tiempo, da el cambio del momento durante el intervalo. Por lo tanto, para producir todos los movimientos, uno solo necesita saber las posiciones y velocidades de todos los objetos en un momento dado y saber las fuerzas que actúan entre los objetos (como función solamente de posiciones y velocidades) en todo momento.

Cuarta ley del movimiento de Newton, es la ley gravitacional que rige la física de fuerza atractiva de objetos. Esta fuerza está dada por una sola expresión que incluye una constante multiplicada por el producto de las masas de los dos cuerpos divididos por el cuadrado de la distancia entre ellos:

![]()

Esta expresión es independiente de dónde y hasta qué punto están separados los cuerpos. En lo que se conoce como mecánica newtoniana o clásica, estos supuestos se elaboran en diferentes formas para aplicar a muchas situaciones diferentes, a las masas, sólidos, líquidos y gases; a cuerpos circulares, rotatorios y vibratorios; al movimiento de proyectiles, péndulos y ondas; para sistemas complejos de muchas masas. Se han aplicado a los átomos y galaxias. La mecánica newtoniana proporciona una manera de capturar matemáticamente los movimientos implicados, no importa lo simple o complejo del sistema. En su momento Newton hizo hincapié en la continuidad de la naturaleza, aunque ahora y después de unos pocos científicos renegados que propusieron la discontinuidad y el desorden, como algo que está en el corazón de la naturaleza. Además, Newton y su archirrival Leibniz crearon el cálculo, la principal herramienta matemática del mundo newtoniano, esa que compartió la noción de cantidades infinitesimales.

Así el mundo newtoniano es un mundo abstracto, austero, carente de intereses de idiosincrasias. Es un mundo donde todos los columpios, trapecios y candelabros son péndulos; los deportes y la danza son F=ma; todas bolas elásticas y aviones se mueven no importa donde Usted este en el mundo; sean grandes o pequeños, las leyes siguen siendo las mismas para todos ellos. Si Usted quiere saber lo que tiene o va suceder en este mundo, mide las posiciones, velocidades, masas y fuerzas aplicando las leyes correspondientes.

Por ejemplo, la manivela se basa en un tipo especial de herramienta que se llama ecuación diferencial, que es una forma sencilla para indicar las relaciones entre propiedades de variables continuas, tales como en el mundo de Newton son velocidad y posición, o fuerza y momento. De este modo, un pequeño cambio en la posición x, es simbolizado por el diferencial dx, y un pequeño cambio en tiempo t por el diferencial dt acercándose a cambios que tienden a cero. La afirmación de que la velocidad es la tasa de cambio de posición respecto al tiempo es dada por ![]() . Del mismo modo la fuerza es

. Del mismo modo la fuerza es ![]() donde

donde ![]() es el momento. Permite calcular sobre resortes, poleas, ondas y más aplicaciones empleando ecuaciones diferenciales y funciones trigonométricas.

es el momento. Permite calcular sobre resortes, poleas, ondas y más aplicaciones empleando ecuaciones diferenciales y funciones trigonométricas.

En los siglos que han transcurrido desde el Principio, los científicos descubrieron muchos fenómenos que tenían que caber en el gran diseño. La electricidad era uno. El científico francés Charles Coulomb y otros estudiaron las fuerzas eléctricas de repulsión y atracción imitando la ley universal de la gravitación de Newton. Encontraron que la fuerza entre dos cargas eléctricas, es proporcional al producto de las cargas, y otra vez es inversamente al cuadrado de la distancia. Allí nace el concepto de campo, una cantidad que tiene el valor específico para cada localización en el espacio y tiempo, ampliando enormemente el poder newtoniano de su mecánica. Otros científicos fueron capaces de demostrar que la corriente de carga eléctrica la producen campos magnéticos cambiantes estableciendo un vínculo con los campos eléctricos, siendo Clerk Maxwell quien redondea la teoría de la electricidad y el magnetismo.

Sin embargo, conforme los avances teóricos y de aplicaciones se dieron, les fue pareciendo que el universo no era una relojería newtoniana. Los científicos se dan cuenta de que el mundo contenía conductas que advertían el azar en su naturaleza. Los científicos de la geología, con la termodinámica y el comportamiento de gases desarrollaron métodos para manejar acciones irreversibles y herramientas estadísticas para el cálculo de la incertidumbre. Fue lo que los filósofos llaman incertidumbre epistemológica, es decir, incertidumbre sobre lo que sabemos de las cosas en estudio, en lugar de incertidumbre ontológica o incertidumbre sobre la misma naturaleza. Cuando la cuántica apareció por primera vez en 1900, lo hizo en territorio newtoniano; solo se descubrió porque representó una desviación de las expectativas newtonianas en cuanto a cómo la luz se comportaba en circunstancias especiales. El mundo cuántico se encontró solo frente al newtoniano. Por un tiempo, los científicos esperaron completamente que estos hechos pudieran encajar en el gran diseño, tal como todos los fenómenos anteriores habían encajado hasta entonces.

Cuando los científicos miran el mundo subatómico fotograma a fotograma, por así decirlo, lo encuentran en discontinuidad extraño, y sus acontecimientos al azar. También sabían que la vida humana tenia este comportamiento azaroso. Nuestro mundo no siempre se siente suave y continuo y gobernado por leyes deterministas. El mundo de hoy no tiene la geometría del universo newtoniano, es más como la superficie del agua hirviendo, es así que el mundo newtoniano estable y convincente durante más de dos siglos, se perforó por sus lagunas, inconsistencias y por no explicar las burbujas de agua hirviente.

Para responder como fue esto, requerimos un breve paso a la vida de Max Planck (1858-1947), quien introduce el concepto de cuántica en la ciencia. Temperamentalmente el más conservador de los científicos de su tiempo. Planck no tenía intención de ser un revolucionario. Aprendió a mantener un perfil bajo para sobrevivir tiempos tumultuosos de la guerra. Cuando tenía sesenta años de edad, observaba como conquistar a las tropas extranjeras, en contraste cuando tenía cincuenta años, viviendo en Berlín, Alemania perdió la primera guerra mundial y a los sesenta y cuatro estaba en Berlín cuando los nazis tomaron el poder. Sobrevivió a numerosas tragedias personales. Su hijo fue asesinado por los nazis en la segunda guerra y su casa fue destruida por el bombardeo aliado. El no era judío, pero el terror nazi lo trato como tal. Pero Planck logró sobrevivir en Alemania a través de la guerra por permanecer en perfil bajo, frente al conflicto[1].

Científicamente, Planck también era conservador. En su juventud estaba fuertemente atraído a la ciencia porque le permitió estudiar un mundo que era absoluto e independiente de las acciones humanas. La ciencia ofrece un maravilloso refugio ante las matanzas de las guerras en el mundo. Cuando él era un estudiante en Múnich, uno de sus profesores le desanima a esta sublime búsqueda, diciéndole, en física, “casi todo está ya descubierto y todo lo que queda es rellenar unos agujeros”. Él pensó que podría llenar esos agujeros y barrer esos rincones polvorientos de la física[2].

Cuan irónico es que este hombre, que pretende poner en orden los extremos sueltos de la física, sería al introducir una idea nueva, quien pone a temblar hasta sus cimientos más profundos el conocimiento newtoniano. Lo hizo mientras trabajaba en el primer laboratorio de pesas y medidas en el mundo. El gobierno alemán le encomendó calificar la bombilla de luz, ante la necesidad de analizar lo que sucede cuando materiales absorben toda la luz que reside en ellos y luego la vuelven a emitir en una distribución uniforme de colores. Materiales en esa condición, se perciben como los mejores amortiguadores de luz y que fueron bautizados como “cuerpos negros” por el maestro de Planck, Gustav Kirchhoff. Le fue encomendada la tarea de investigación de la radiación de un cuerpo negro para producir una fórmula que describa su espectro normal, en cuanto a su perfil, intensidades y frecuencias de variación por temperatura[3].

Planck, que en 1892 relevo a Kirchhoff como profesor en Berlín, le gustaba este problema. Por un lado, él quería responder al interés nacional de esta investigación. Por otra parte, él fue preparado, para el problema en sus estudios anteriores. Por último, el hecho de que el resplandor dependía solamente de la temperatura del material y no de su composición química, sugirió que la solución sería fundamental –similar a la forma en que la naturaleza fundamental de la fuerza gravitatoria depende exclusivamente de lo masivo del objeto-. Ya que siempre Planck consideró la meta de lo absoluto, como la meta más alta de la actividad científica.

Planck descubrió que podía producir una fórmula para los datos de Reichanstalt, el supone que los materiales absorben y emiten luz selectivamente, solo en números enteros múltiplos de una determinada cantidad de energía que llamo ![]() , donde

, donde ![]() es la constante que lleva el nombre de Planck , y v es la frecuencia de la radiación. Si E es la energía, y n un número entero, la fórmula de radiación de Planck es

es la constante que lleva el nombre de Planck , y v es la frecuencia de la radiación. Si E es la energía, y n un número entero, la fórmula de radiación de Planck es ![]() . Planck dijo que hizo esta asunción por pura desesperación. No fue una explicación sino un truco matemático, se dio cuenta, y pensó que finalmente se podría desechar la idea. Pocos prestaron atención a la idea de Planck. Una excepción, tan solo cincuenta años más tarde, fue hecha por un empleado de oficina de patentes de 20 años de edad, conocido como Albert Einstein, al que le valió el premio Nobel por explicar el efecto fotoeléctrico. Einstein explica la fórmula de Planck por una sugerencia radical que considera a la energía de la luz en sí misma, que viene dada en múltiplos de h. Es decir, en quantums de energía de luz, se reconocería más tarde como fotón. En definitiva, el quantum era un truco matemático, como Planck lo hizo, pero con Einstein fue una realidad física. Esto era muy revolucionario. Pocos tomaron en serio la idea de Einstein. Pero para 1910, en el interés de los físicos en la cuántica se hacia una fisura. La razón fue que todos los intentos por eliminar la necesidad de hacerlo así y reconciliar todo con la física clásica, habían fallado. La cuántica fue surgiendo dentro de la teoría molecular de la conducción de calor en sólidos. Los científicos miran en el mundo subatómico, encontrando este invitado incomodo[4]:

. Planck dijo que hizo esta asunción por pura desesperación. No fue una explicación sino un truco matemático, se dio cuenta, y pensó que finalmente se podría desechar la idea. Pocos prestaron atención a la idea de Planck. Una excepción, tan solo cincuenta años más tarde, fue hecha por un empleado de oficina de patentes de 20 años de edad, conocido como Albert Einstein, al que le valió el premio Nobel por explicar el efecto fotoeléctrico. Einstein explica la fórmula de Planck por una sugerencia radical que considera a la energía de la luz en sí misma, que viene dada en múltiplos de h. Es decir, en quantums de energía de luz, se reconocería más tarde como fotón. En definitiva, el quantum era un truco matemático, como Planck lo hizo, pero con Einstein fue una realidad física. Esto era muy revolucionario. Pocos tomaron en serio la idea de Einstein. Pero para 1910, en el interés de los físicos en la cuántica se hacia una fisura. La razón fue que todos los intentos por eliminar la necesidad de hacerlo así y reconciliar todo con la física clásica, habían fallado. La cuántica fue surgiendo dentro de la teoría molecular de la conducción de calor en sólidos. Los científicos miran en el mundo subatómico, encontrando este invitado incomodo[4]: ![]() .

.

En 1911, un grupo de veintiún líderes científicos de Europa, se reunieron en Bruselas para una cumbre sobre la cuántica. Organizada por el químico y físico Walther Nernst. El propio Nernst había rechazado la idea cuántica y luego admitió que era indispensable como hombre serio de ciencia sujetarse a la investigación cuidadosa. Esta conferencia de Solvay Brúcelas de 1911 fue un punto de inflexión en la respetabilidad de la cuántica, se hace noticia en todo el mundo, Rutherford la llevo a Inglaterra, a Dinamarca lo hizo Niels Bohr, a Francia Henri Poincaré.

Robert A. Millikan (1868-1953), de la universidad de Chicago, estaba decidido a ayudar a sus colegas estadounidenses a conciliar el sueño, intentaría matar la idea cuántica al modo de hacer experimentos de vanguardia y poner a prueba las predicciones que en papel en 1904 Einstein realizó. Millikan fue sorprendido por sus experimentos, confirmándole cada una de las predicciones de Einstein. Su asombro y consternación quedo exhibido en su artículo que anunció los resultados. Se vio obligado a admitir que la teoría cuántica de Einstein realmente representa muy exactamente el efecto fotoeléctrico[5].

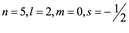

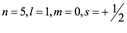

Mientras tanto la cuántica surge con nuevas explicaciones de fenómenos subatómicos. En 1913-14, el joven físico Niels Bohr estaba interesado en esto, porque su doctorado demostró que la física clásica no podía explicar las propiedades electromagnéticas de los metales, aplicando a átomos de una gran variedad haciendo surgir con fuerza la física atómica. La teoría clásica predice que al moverse los electrones en órbita alrededor del núcleo irradian energía y colapsan en el núcleo. Bohr demostró que si se asume el momento angular para las órbitas de los electrones en múltiplos de una nueva unidad natural ![]() , entonces los electrones no tienen un número infinito de posibles órbitas alrededor del núcleo como planetas alrededor del sol, es decir, solamente una sección pequeña encaja, fue un resultado dramáticamente coherente con la evidencia experimental[6].

, entonces los electrones no tienen un número infinito de posibles órbitas alrededor del núcleo como planetas alrededor del sol, es decir, solamente una sección pequeña encaja, fue un resultado dramáticamente coherente con la evidencia experimental[6].

Otro fenómeno descubierto aproximadamente al mismo tiempo era el efecto Stark, o el hecho de que las líneas espectrales están divididas por un campo eléctrico. El efecto fue descubierto en 1913 y explicado por la teoría cuántica en un artículo de 1916. Si bien el experimento de Millikan sirvió como punto de inflexión en la recepción de la teoría cuántica, Max Jammer, historiador de ciencia escribió: la cuántica se convirtió en física real accesible directamente al experimentador y la conjetura de Einstein sobre el quantum, fue dotada de significado físico y un fundamento experimental a partir del efecto Stark[7].

Todas estas discusiones se llevaron a cabo dentro de la comunidad de la física, con poca participación de la opinión pública. El leguaje ordinario continuó utilizando el quantum en su significado de “cantidad”, que podría ser grande o pequeña y hasta insignificante. No en el sentido de Planck como una cantidad finita, de alguna magnitud suficiente para marcar una diferencia estructural importante. Las noticias fueron que Planck fue galardonado con el Premio Nobel en 1918 en reconocimiento por los servicios prestados al avance de la física por su descubrimiento de la energía cuántica. En 1919 Einstein se convirtió en renombrado científico al confirmarse las predicciones de su teoría de la relatividad general, y fue más aún a pesar de que recibió el Premio Nobel en 1912 por su descubrimiento de la ley del efecto fotoeléctrico, es decir, por su contribución a la teoría cuántica. Y en 1923 Millikan recibió el Nobel por su trabajo sobre la carga eléctrica elemental y sobre la experimentación del efecto fotoeléctrico. Ya para entonces, la prensa para las audiencias educadas mencionaría con más insistencia la idea de Planck: se ha descubierto un mundo que no era continuo en el sentido de lo expresado por el pensamiento de Newton.

La ecuación de Planck, para 1930 se vuelve famosa por los libros de divulgación científica y artículos que inundan los medios, transformando la historia de la ciencia. La comunidad reconoce en Planck, un nuevo Colón que nos abrió un nuevo mundo científico y una nueva cultura en sí. Planck, por supuesto, nada de esto tenía en mente; reflexiones sobre las implicaciones de su concepción científica en el arte, cine y literatura se multiplicaron. En 1947, el último año de su vida, Planck fue invitado por la Royal Society de Londres a una celebración con motivo de Newton. El evento se llevó a cabo en una gran sala, y distinguidos invitados fueron honrados uno por uno, en una página se dio lectura a sus nombres y países de una lista en voz alta. Planck fue especialmente invitado y no estaba en la lista. El lector de la página, confundido, de repente tuvo que improvisar y tropezó: “profesor Max Planck, de ningún país”, los asistentes rieron y dieron a Planck una ovación de pie, Planck con sus noventa años de edad, con dificultad se levantó para aceptar el aplauso cálido. Avergonzada, la Royal Society ha añadido a Planck a la lista de citación para el segundo día, pero Planck insistió en que fuera nombrado “desde el mundo de la ciencia[8]”.

Con la electrificación del siglo XIX y en particular con la aparición de la bombilla eléctrica, se comenzó a preguntar sobre el principio detrás de estos cuerpos que emiten calor y luz en rangos visibles y más allá. Estas gamas de luz tiene un perfil particular. Cada material irradia el mismo espectro de colores a la misma temperatura; registros con madera y piezas de cerámica todos brillan al mismo color que una barra de hierro por ejemplo. Con lámparas eléctricas fabricadas a principios de siglo XX se intentó para su diseño, que optimizaran la producción de luz blanca y redujeran las otras frecuencias. Se demostró que la intensidad de la luz emitida aumenta con la temperatura, pero el aumento no se distribuye igual a través de todas las frecuencias y cambia o es desplazado hacia longitudes de ondas más cortas, esto se le conoce como la ley de desplazamiento Wien.

Planck observó un modelo de la manera en que los materiales absorben y emiten radiación en la forma tradicional de representar a los materiales, como un conjunto de osciladores, como resortes de Hooke de flexibilidad variable. Sus índices de oscilación dependían por así decirlo, de la rigidez de los muelles. Cuando el material absorbe energía, los resortes osciladores captan más energía; cuando ellos emiten energía sus oscilaciones son menores. Un material puede tratarse como un conjunto de tales resortes de diferente rigidez para absorber y emitir energía en distintas frecuencias. En 1899 Planck estaba encantado cuando encontró que podía usar este modelo para derivar la ley de desplazamiento Wien. Pero solo un año después Reichanstalt, experimentando con hornos mide longitudes de onda más largas (infrarrojo), estos resultados están en desacuerdo con la fórmula de Wien, con una función espectral más proporcional a la temperatura, más en consonancia con la fórmula clásica, conocida más tarde como fórmula de Rayleigh-Jeans. Sobre la propia fórmula de Planck a principios de 1900 existía una suposición empírica pero sin verdadero significado físico. Fue en noviembre de 1900 que empleando termodinámica para calcular la energía distribuida entre los modelos de los resonadores, con la esperanza de obtener alguna pista fundamental, esa luz llego, levantando de la oscuridad una mirada inesperada, apareció en sus actos de desesperación. Se encontró que tenía que asumir que la energía total E es distribuida entre los N resonadores consistentes con un conjunto de ![]() elementos de energía, cuyo valor estaba relacionado con una nueva constante fundamental de la naturaleza que llamo simplemente

elementos de energía, cuyo valor estaba relacionado con una nueva constante fundamental de la naturaleza que llamo simplemente ![]() . Fue esta constante invocada para aplicar solamente el mecanismo de la interacción entre materia y la luz que irradia.

. Fue esta constante invocada para aplicar solamente el mecanismo de la interacción entre materia y la luz que irradia.

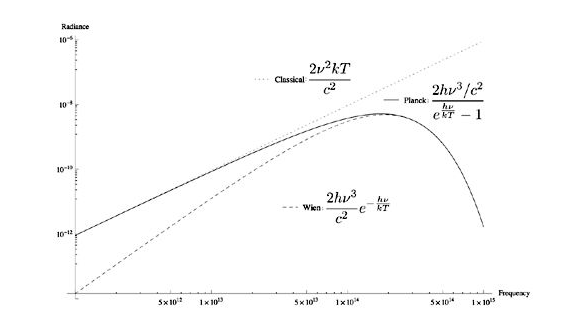

Las tres leyes propuestas para la radiación de un cuerpo negro radiante, radiación versus frecuencia como lo explica el siguiente gráfico. La ley Wien, que sigue la línea punteada debajo del ajuste a los datos experimentales de la radiación emitida a altas frecuencias, describiendo, a la derecha del gráfico, como picos en una frecuencia específica, que es mayor cuanto más caliente es la temperatura. La fórmula clásica, que sigue la línea punteada en la parte superior, no cupieron los datos, pero fue asumida para describir datos de frecuencia inferiores a la izquierda del gráfico. La fórmula de Planck, la línea de conexión, por lo tanto como ideal, ni demasiado grande o muy pequeña, fue justa con los datos experimentales.

Para frecuencias suficientemente altas, el termino 1 en el denominador es insignificante comparado con el enorme término exponencial. Dejando de lado el 1, el exponencial en el denominador se convierte en una exponencial con exponente negativo en el numerador, reproduciendo exactamente la fórmula de Wien. Para frecuencias pequeñas la exponencial en el denominador aproxima a 1 y solo la diferencia de dos términos es importante y la diferencia se puede aproximar como ![]() , por lo que

, por lo que ![]() es reducida a 1 y un factor

es reducida a 1 y un factor ![]() en el numerador. Esto es precisamente lo que la teoría clásica no observo de los efectos cuánticos. Por lo menos en retrospectiva la fórmula de Planck interpola suavemente entre la física clásica en frecuencias bajas y la fórmula de Wien a altas frecuencias. Aunque es un truco matemático, resultó en uno de los más importantes logros históricos de la física.

en el numerador. Esto es precisamente lo que la teoría clásica no observo de los efectos cuánticos. Por lo menos en retrospectiva la fórmula de Planck interpola suavemente entre la física clásica en frecuencias bajas y la fórmula de Wien a altas frecuencias. Aunque es un truco matemático, resultó en uno de los más importantes logros históricos de la física.

Considerando este punto esencial de todo cálculo de E, que se compone de un número bien definido de partes iguales y al utilizar la contante natural ![]() ergio x segundo. Esta constante multiplicada por la común frecuencia de los resonadores nos da la energía de los elementos

ergio x segundo. Esta constante multiplicada por la común frecuencia de los resonadores nos da la energía de los elementos ![]() en ergios, y divide a

en ergios, y divide a![]() obteniendo el número P de elementos de energía que deben ser divididos sobre los N resonadores.

obteniendo el número P de elementos de energía que deben ser divididos sobre los N resonadores.

Esta última frase dice en palabras lo que se conoce ahora como fórmula de energía de Planck ![]() o

o ![]() , donde n es algún número entero múltiplo de esta cantidad básica, una de las ecuaciones fundamentales que estructuran el mundo. Aunque Planck no se refiera a esta idea como un quantum. Él utiliza la palabra, sin embargo, la dice cuando explícitamente asume que los resonadores no pueden tener cualquier energía, como lo pensó la física clásica, las energías permitidas se separarían por múltiplos enteros, Planck consiguió algo fundamental, pero no lo que él esperaba, intentar salvar la teoría clásica, terminando por derribarla ante la contundencia de la evidencia experimental hasta 1900. Cinco años más tarde Albert Einstein volvió el truco matemático en un concepto físico. En 1905 publicó cuatro extraordinarios textos que rompieron con la física clásica. Uno fue el efecto fotoeléctrico, el hecho de que la luz se incide a un metal hace saltar electrones de su superficie. La teoría clásica predice que la energía de los electrones debería depender de la intensidad de la luz. No lo hizo así; en su lugar solo depende de la frecuencia de la luz, si brilla una luz más intensamente sobre una superficie, más electrones saltan pero con la misma energía. Aunque Planck había hecho con cautela la predicción de introducir

, donde n es algún número entero múltiplo de esta cantidad básica, una de las ecuaciones fundamentales que estructuran el mundo. Aunque Planck no se refiera a esta idea como un quantum. Él utiliza la palabra, sin embargo, la dice cuando explícitamente asume que los resonadores no pueden tener cualquier energía, como lo pensó la física clásica, las energías permitidas se separarían por múltiplos enteros, Planck consiguió algo fundamental, pero no lo que él esperaba, intentar salvar la teoría clásica, terminando por derribarla ante la contundencia de la evidencia experimental hasta 1900. Cinco años más tarde Albert Einstein volvió el truco matemático en un concepto físico. En 1905 publicó cuatro extraordinarios textos que rompieron con la física clásica. Uno fue el efecto fotoeléctrico, el hecho de que la luz se incide a un metal hace saltar electrones de su superficie. La teoría clásica predice que la energía de los electrones debería depender de la intensidad de la luz. No lo hizo así; en su lugar solo depende de la frecuencia de la luz, si brilla una luz más intensamente sobre una superficie, más electrones saltan pero con la misma energía. Aunque Planck había hecho con cautela la predicción de introducir ![]() , advirtió que los resonadores solo podrían absorber y emitir luz con energías en múltiplos de

, advirtió que los resonadores solo podrían absorber y emitir luz con energías en múltiplos de ![]() . Einstein dice que

. Einstein dice que ![]() es una característica de la luz en sí misma. La luz es granulada, localizada en el espacio y con energías en múltiplos de

es una característica de la luz en sí misma. La luz es granulada, localizada en el espacio y con energías en múltiplos de ![]() , o quantums (cuantos) de luz, más tarde llamados fotones. Además, la energía durante la propagación de un rayo de luz, la describió, como algo no distribuido continuamente sobre el espacio, en constante aumento, pero consta de un número finito de cuantos de energía localizados en los puntos en el espacio, sin dividir y capaces de ser absorbidos o generados solo como cantidades discretas. Por lo tanto, la energía de los fotones que brilla en la superficie de un metal tiene que ser al menos tan grande como la suma de la energía final del electrón que salta de la superficie, además la energía necesaria para que un electrón deje el metal está en función del trabajo:

, o quantums (cuantos) de luz, más tarde llamados fotones. Además, la energía durante la propagación de un rayo de luz, la describió, como algo no distribuido continuamente sobre el espacio, en constante aumento, pero consta de un número finito de cuantos de energía localizados en los puntos en el espacio, sin dividir y capaces de ser absorbidos o generados solo como cantidades discretas. Por lo tanto, la energía de los fotones que brilla en la superficie de un metal tiene que ser al menos tan grande como la suma de la energía final del electrón que salta de la superficie, además la energía necesaria para que un electrón deje el metal está en función del trabajo: ![]() . Es como la forma de la energía de una bala en el cañón de un rifle, es menos de lo que era cuando inicialmente exploto debido a la energía perdida viajando por el cañón.

. Es como la forma de la energía de una bala en el cañón de un rifle, es menos de lo que era cuando inicialmente exploto debido a la energía perdida viajando por el cañón.

Por un tiempo Planck luchó con sus colegas para adaptar la idea de ![]() en el marco de la física convencional. Todo fue en vano, la evidencia experimental hace que no se puede ignorar a

en el marco de la física convencional. Todo fue en vano, la evidencia experimental hace que no se puede ignorar a ![]() , cada vez que las frecuencias altas o bajas estaban implícitas, exigían la entrada de esta constante en el cálculo. Es durante la conferencia de 1911 en Bruselas que Planck señala otra implicación bizarra. Su constante no es una cantidad específica de energía, pero establece una proporcionalidad entre dos cantidades. La ecuación

, cada vez que las frecuencias altas o bajas estaban implícitas, exigían la entrada de esta constante en el cálculo. Es durante la conferencia de 1911 en Bruselas que Planck señala otra implicación bizarra. Su constante no es una cantidad específica de energía, pero establece una proporcionalidad entre dos cantidades. La ecuación ![]() , por ejemplo relaciona energía con frecuencia; si una sube, la otra también lo hace. Los físicos llaman constantes de proporcionalidad entre energía y frecuencia o constantes de acción. Es sorprendente que

, por ejemplo relaciona energía con frecuencia; si una sube, la otra también lo hace. Los físicos llaman constantes de proporcionalidad entre energía y frecuencia o constantes de acción. Es sorprendente que ![]() es una cantidad de acción a través de la noción del espacio de fase, o la representación abstracta de todos los valores claves posibles que un sistema puede tener. En la física clásica, cada punto de la tabla es una posición posible para un objeto. Cuando un objeto cambia de posición y su impulso, se mueve de un punto a otro, traza una línea, y las leyes de Newton pueden utilizarse para predecir su trayectoria. Planck observó que en el mundo cuántico, tal objeto no tiene un número infinito de posiciones. La tabla está formada por pixeles, cada uno en la zona de

es una cantidad de acción a través de la noción del espacio de fase, o la representación abstracta de todos los valores claves posibles que un sistema puede tener. En la física clásica, cada punto de la tabla es una posición posible para un objeto. Cuando un objeto cambia de posición y su impulso, se mueve de un punto a otro, traza una línea, y las leyes de Newton pueden utilizarse para predecir su trayectoria. Planck observó que en el mundo cuántico, tal objeto no tiene un número infinito de posiciones. La tabla está formada por pixeles, cada uno en la zona de ![]() , que representa un estado posible como una gama de valores de posición y momentos para el objeto. Sus posibilidades son ahora enormemente restringidas. No se puede mover continuamente de un punto a otro, pero se ha quedado atascado en una región por lo menos tan grande como un quantum. Cada pixel es un espacio de acción y movimiento del objeto, son discontinuos entre ellos. Con el beneficio de la retrospectiva, muchos de los principios de la teoría cuántica están incluidos en este comportamiento, tal como el de incertidumbre que predice este pixelado o cuantizado. La cuántica se definía entonces por poner entrelazamientos y burbujas en lugares del universo, abriendo una nueva era en la ciencia.

, que representa un estado posible como una gama de valores de posición y momentos para el objeto. Sus posibilidades son ahora enormemente restringidas. No se puede mover continuamente de un punto a otro, pero se ha quedado atascado en una región por lo menos tan grande como un quantum. Cada pixel es un espacio de acción y movimiento del objeto, son discontinuos entre ellos. Con el beneficio de la retrospectiva, muchos de los principios de la teoría cuántica están incluidos en este comportamiento, tal como el de incertidumbre que predice este pixelado o cuantizado. La cuántica se definía entonces por poner entrelazamientos y burbujas en lugares del universo, abriendo una nueva era en la ciencia.

La notación de salto cuántico se introduce en la física atómica desde la cuántica de Niels Bohr. Gracias a una beca de la cervecera Carlsberg, Bohr viajó al laboratorio Cavendish en Cambridge Inglaterra, cuyo jefe era Thomson, quien había ayudado a descubrir el electrón. Pero Thomson no encontró interés en la investigación Bohr. A finales de 1911, en visita a Manchester, Bohr conoció a Ernest Rutherford experimentador del mundo de la radiactividad. Esto hace que Bohr deje Cavendish y se una al laboratorio de Rutherford en marzo de 1912. Allí Bohr sentó las bases para una de las mayores revoluciones en la física mediante la incorporación de la cuántica a la estructura atómica. El trabajo de Thomson demostró que partículas de átomos llamadas electrones, están cargadas negativamente. La existencia de la partícula protón con carga positiva fue propuesta pero no aceptada inmediatamente. Rutherford adujo que toda carga positiva estaba alojada en el núcleo atómico central y propuso que los electrones giran como si fueran planetas alrededor del sol. Pero la idea trajo poca atención y no fue promovida porque los científicos tenían buenas razones para ser escépticos.

Cargas eléctricas, no son planetas. Cuando estas cargas se arremolinan bajo la influencia de otra carga, irradian energía. Los electrones en los átomos de Rutherford rápidamente disminuyen sus órbitas y en espiral caen al núcleo. Según las leyes tradicionales del movimiento y la atracción, la idea de Rutherford no funcionaría. Bohr, sin embargo, presintió que el quantum jugaba un rol extraño en la fabricación de átomos estables. Desde luego que no fue el primero en pensar esto, Planck lo hizo primero. Pero Bohr estaba en una posición especial para encontrar el camino correcto para resolver el problema. Conocía el modelo de Rutherford a profundidad, y estaba armado con la información más reciente sobre el quantum. La solución vino a Bohr en varios pasos audaces en 1912.

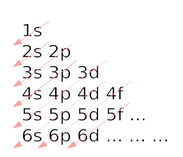

¿Por qué no podían los electrones orbitar el núcleo similar a los planetas?, por qué no irradian energía los planetas cuando orbitan. La respuesta la da Bohr, tiene que ver con la acción cuántica, con el hecho de que el espacio de fase se da en trozos. Esta acción se relaciona con energía multiplicada por tiempo. En el mundo newtoniano, acción es una variable continua, pero para la implicación atómica esto resultó bizarro. La intuición de Bohr, por contrario, se inclinó por ver a la acción de cuantización, para explicar la estabilidad del átomo. Para probarlo, él tendría que encontrar una conexión entre energía cinética de los electrones girando en el núcleo y su frecuencia. Estaba emocionado y perplejo ante un rayo pulsado con líneas espectrales. Esta luz que se desprende del movimiento de los electrones, que saltan entre orbitales hacia delante o hacia tras entre ellos, absorbiendo y emitiendo energía en forma de luz en frecuencias especificas en el proceso. Tales líneas se habían estudiado durante medio siglo, los científicos llamados espectroscopistas conocían estas líneas. En 1885 un maestro de escuela Johann Balmer hizo un hallazgo sorprendente: matemáticamente logro ajustar las frecuencias de la líneas espectrales de hidrógeno a una fórmula que predice otras líneas que él desconocía. En notación moderna, la fórmula de producción de series ![]() , donde R es una constante, llamada constante Rydberg, n1 es un entero mayor que cero, n2 es un entero mayor que n1.

, donde R es una constante, llamada constante Rydberg, n1 es un entero mayor que cero, n2 es un entero mayor que n1.

Tan pronto como Bohr advirtió la fórmula de Balmer dijo que todo fue claro para él. La fórmula demostró una cantidad clásica continua, la longitud de onda, tomando valores enteros múltiplos de una unidad básica. Pero eso fue un signo de cuantización. Bohr se dio cuenta, y la fórmula le dio una señal para la observación de la naturaleza cuántica de la estructura atómica. Cuando los electrones absorben energía de los fotones, almacenan energía moviéndose a una órbita más alta y la liberan en forma de fotones de una frecuencia específica al regresar a un nivel más bajo. Las matemáticas demuestran que la energía de enlace en la segunda órbita es un cuarto de la primera, la tercera una novena y luego un dieciseisavo y así sucesivamente. El salto de transición de una más alta a una órbita más baja de la energía se emite en forma de luz una frecuencia especifica: una línea espectral. La acción cuántica significó que hay solo determinadas órbitas atómicas permisibles. Era como si hubiera solo ciertas órbitas permitidas alrededor del sol y un planeta no pudiera hacer una transición de una a otra, pero en su lugar se materializaría en el lugar permitido. Bohr se dio cuenta de que la serie de Balmer le permitía conectar un conocimiento entre la acción cuántica y las líneas espectrales. Era una huella de la estructura cuántica del átomo.

Después de intenso trabajo en marzo de 1913 Bohr escribió un artículo llamado “La constitución de átomos y moléculas, parte I”. Si bien demostró que los electrones no tienen un infinito de posibilidad alrededor del núcleo, sino que están confinados en una pequeña sección de órbitas, se enfrentó con no poder explicar por qué los electrones no caen al núcleo, él simplemente declaró que el estado es estable, así para no contravenir todos los conocimientos sobre radiación ya revelados hasta ese momento.

La explicación de Bohr funciona muy bien con el hidrogeno, pero no ocurrió así para otros elementos. Cuando un átomo tiene más de un electrón, la interacción entre los electrones sirve para detectar la carga positiva del núcleo que afecta firmemente el enlazado externo de los electrones, claro está que esto presenta complejidades que no se manejan fácilmente por el tratamiento de Bohr.

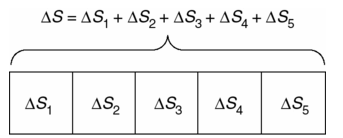

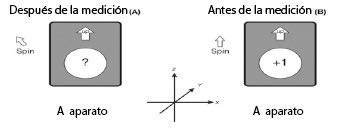

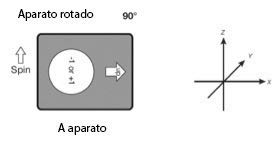

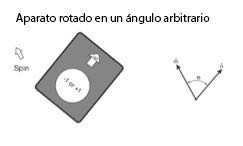

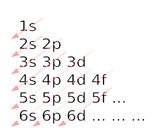

Si bien Bohr no bautizó las palabras “salto” y ”saltar” en sus primeros trabajos, pero sí habló de simples órbitas del electrón o estados estacionarios. Sin embargo, su modelo dijo que los electrones podrían tener solo valores de energía específicos, lo que significaba en el lenguaje de las órbitas y trayectorias entre órbitas, era algo insatisfactorio. Los electrones no podrían pasar de transición sin problemas entre una ubicación atómica y otra – como un satélite cambia de órbita - pero hizo la transición instantánea de alguna manera. Dentro de unos años, los textos científicos popularizarían en un lenguaje más preciso este hecho como saltos o tirones entre estados. Por tanto la energía es discontinua y atómica, se da en tirones, como Imag1 en movimiento, pero los tirones suceden tan rápido que vemos una continuidad. Esta comparación, con secuencias de Imag1 de cine, es justo una buena idea para extender el concepto de saltos cuánticos como una función de nuestro mundo.

La palabra cuántica, rápidamente se convirtió en una metáfora de la discontinuidad. Discontinuidades no son necesariamente azar o sin causa; los tirones aún estaban incluidos en las fuerzas continuas newtonianas. El quantum era ahora una idea de encendido y apagado, en lugar de grados de libertad. Así nació el término salto cuántico, referido como un aumento repentino, significativo o muy evidente o avance. Si consideramos un salto grande o pequeño depende de su escala. Un salto cuántico es un pequeño paso para un hombre pero un paso grande para conocer el átomo, como lo es para un universo discontinuo para un electrón.

Es decir, las palabras simples o compuestas son metamorfosis, no tienen un significado fijo. Pueden explotar creativamente como nuevos conceptos. El cambio en el significado de “salto cuántico” no es el único caso. Varias palabras del lenguaje ordinario tales como momento, fuerza, gravedad…, han terminado como términos científicos, pero otras en sentido inverso su fluidez hacia la sociedad es limitada, por ejemplo, principio de incertidumbre, complementariedad, entropía y catalizador entre muchos otros términos que vienen a enriquecer la vida ordinaria del lenguaje. La ciencia es una forma de laboratorio en el que se intenta que las palabras sean utilizadas con un significado en correlación objetiva con la realidad ontológica. Solo un pequeño grupo de palabras tienden a pasar de conceptos científicos a una revolución social del imaginario ordinario, este es el caso de la relatividad y la cuántica. En la física, por ejemplo, una “onda”, significaba originalmente en lenguaje ordinario algo que tuvo lugar en un medio. Sin embargo, su extensión metafórica respecto de la luz, dice, que no requiere de un medio para propagarse, y luego en la cuántica implica a la probabilidad como cambio de significado. Una “onda” ahora es una nueva metáfora donde no hay medio de propagación, de este modo a nuestro lenguaje se le exige adecuar los términos que emplea para intervenir en la realidad científica, así salto cuántico representa parte de una nueva imagen mental de la realidad.

Cuando Bohr introduce el quantum a la estructura atómica, su idea era simple. Dentro de sus supuestos consideró que el electrón viajaba muy por debajo de la velocidad de la luz para no entrar en juego contra la relatividad. Él asumió que las órbitas eran circulares y que el electrón no irradiaba energía como sugerían las leyes clásicas de Maxwell. La descripción mecánica de las órbitas, en términos clásicos, era la fuerza centrípeta necesaria para mantener al electrón en su órbita circular ![]() , igualada a la fuerza eléctrica de atracción entre electrones y su núcleo

, igualada a la fuerza eléctrica de atracción entre electrones y su núcleo ![]() . Es decir

. Es decir ![]()

Esto da lugar a algo similar a las leyes de Kepler de los movimientos planetarios. En esta imagen atómica, la metáfora es, el núcleo, el sol y el electrón es un planeta. Si esto fuera totalmente cierto, el electrón podría orbitar el núcleo en un número finito de maneras posibles, pero al seguir perdiendo energía, se hundirá eventualmente en el núcleo atómico. Bohr entonces hizo otra hipótesis, solo algunas de estas órbitas son posibles, y usó la idea cuántica para escoger estas órbitas seleccionadas. Permite en su modelo órbitas, las cuales el momento angular del electrón, son enteros múltiplos de una constante formada por la constante de Planck:![]() , llamada “hbar” y representada por h.

, llamada “hbar” y representada por h. ![]() veces el momento angular igual a nh, con n como número entero. El radio de las órbitas permitidas ahora es

veces el momento angular igual a nh, con n como número entero. El radio de las órbitas permitidas ahora es

![]()

Cuando los electrones saltaban o saltan desde una de estas órbitas a otra, la diferencia de sus energías es:

![]()

Esto condujo directamente a través de la relación de Planck ![]() , a la siguiente fórmula de longitud de onda:

, a la siguiente fórmula de longitud de onda:

![]()

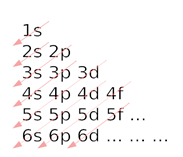

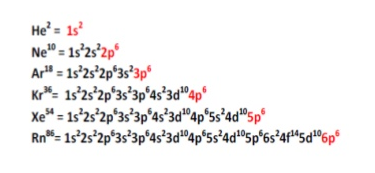

Para ![]() , esto corresponde a la serie original de Balmer para el hidrogeno, con líneas en el espectro visible. Así el átomo de Bohr era un hibrido; tomó el modelo clásico e impuso una restricción cuántica. Se rompió casi inmediatamente esta idea, porque solo aplica al hidrogeno. Tuvo que esperar más conocimiento para dar un paso trascendental, sin embargo, demostró que la cuántica estaba inscrita en la estructura de la materia. La materia se mantiene unida debido a h. Sí, h es pequeña, si fuera cero los átomos colapsarían en fracciones de segundo. En los saltos cuánticos, h fuerza a los electrones a dar estabilidad al átomo dentro de la mecánica en este micromundo. ¿Por qué esto para todos los átomos de hidrogeno y cualquier otro átomo? La cuantización es la respuesta, porque todos tienen la misma estructura. Hay esencialmente una manera en la que podemos mantener juntos electrones y protones para hacer estable un átomo de hidrogeno. Y la misma vale para otros átomos.

, esto corresponde a la serie original de Balmer para el hidrogeno, con líneas en el espectro visible. Así el átomo de Bohr era un hibrido; tomó el modelo clásico e impuso una restricción cuántica. Se rompió casi inmediatamente esta idea, porque solo aplica al hidrogeno. Tuvo que esperar más conocimiento para dar un paso trascendental, sin embargo, demostró que la cuántica estaba inscrita en la estructura de la materia. La materia se mantiene unida debido a h. Sí, h es pequeña, si fuera cero los átomos colapsarían en fracciones de segundo. En los saltos cuánticos, h fuerza a los electrones a dar estabilidad al átomo dentro de la mecánica en este micromundo. ¿Por qué esto para todos los átomos de hidrogeno y cualquier otro átomo? La cuantización es la respuesta, porque todos tienen la misma estructura. Hay esencialmente una manera en la que podemos mantener juntos electrones y protones para hacer estable un átomo de hidrogeno. Y la misma vale para otros átomos.

Un salto cuántico, dijimos, es un pequeño paso para un hombre, pero un gran paso para un electrón. ¿Qué tan grande es? Para darnos una idea, consideramos la energía y las distancias involucradas. ¿Sí pudiéramos saltar 10 metros en el aire, sería enorme la energía involucrada? Ahora vamos a ver si comparamos a este salto con la energía de un electrón que va desde el primer estado a un segundo dentro de un átomo de hidrogeno. ¿Cuánto es para nosotros este salto quivalente?, sería hacer saltar un electrón fuera del campo gravitacional de la tierra, tendría que ser lanzado con la misma energía necesaria para romper la fuerza de gravedad. La respuesta es alrededor de 100 millones de kilómetros, lo que significa una distancia comparable a la distancia de la tierra al sol. La comparación muestra que el electrón hace un salto verdaderamente enorme.

La energía de salto de los electrones es muy pequeña en comparación, esencialmente con cualquier energía requerida para un objeto macroscópico del tamaño humano. La masa de un electrón es tan pequeña que esta energía tiene un efecto mayúsculo sobre la velocidad del electrón, que implica aceleraciones que aplastarían a un ser humano. La perspectiva de grandes o pequeños para el cambio de energía del electrón depende sobre lo que comparemos.

La nube cuántica de electrones puede parecer un comportamiento azaroso. La aleatoriedad y la incertidumbre están en el centro del universo colocadas juntas para darnos una visión de la aleatoriedad cuántica, como un orden difuso del cosmos. En el mundo newtoniano clásico la respuesta a estas preguntas es ¡No!, la materia no baila en desorden; el comportamiento causal a gran escala debe seguir también el orden más pequeño de la materia según Newton. Laplace pensó que para cada estructura se puede predecir todos los eventos con la suma total de ellos en esa realidad.

Pero los seres humanos no estamos en esa feliz situación. Simplemente no sabemos cómo funciona la mayoría del universo. Para hacer frente a estas situaciones, los científicos crean teorías de probabilidad y error de medición. Algunas distinciones claves son que los eventos aleatorios carecen de fines, razones o causales específicas. Así la estadística es el análisis de la frecuencia de eventos que ya han sucedido y los patrones en ellos. Mientras la probabilidad es el uso de estadísticas para predecir los acontecimientos futuros. La incertidumbre es la cantidad de posibles desviaciones de un resultado presente en el mundo newtoniano, como formas de describir y abordar las situaciones de conocimiento incompleto. Estas herramientas eran necesarias en circunstancias cuando se deseara saber el modelo pero no la forma y el color de cada ladrillo de la realidad.

Hoy azar, incertidumbre y la posibilidad de predecir (probabilidad) a menudo son asociados con el comportamiento cuántico y vistos como características permanentes de nuestro mundo. La transición de la física clásica a la cuántica fue gradual, al ritmo en que la estadística y la probabilidad fueron hechas suyas por la comunidad científica. Esto comenzó en el siglo XIX, cuando aparecieron varios fenómenos en el mundo newtoniano que parecían inofensivos, pero acabaron por ser subversivos y generaron una revolución.

El primero llegó a través de la termodinámica. La palabra fue acuñada a mediados del siglo XIX para referirse a la ciencia del calor, concebida no como una sola sustancia, como lo había sido, sino como un fenómeno derivado de movimientos de numerosas partículas. De una disciplina a otra, la ciencia física tuvo que pedir herramientas de las ciencias sociales para explicar estos movimientos. Gracias al trabajo de Quetelet, la estadística se había convertido en un recurso bien desarrollado para analizar el nacimiento y las tasas de mortalidad, enfermedad, crimen y así sucesivamente donde cada elemento individual de seguimiento del comportamiento era posible. Los científicos que estudian la termodinámica y otras situaciones que implican muchos movimientos de partículas se dieron cuenta que la estadística podría ayudarles al estudio de nubes de partículas. Esta estadística, fue la herramienta para estudiar sistemas complejos como la sociedad humana. Así, los sociólogos investigan el comportamiento de la sociedad y los científicos naturales gases y otras nubes de partículas. La estadística revela el comportamiento global del sistema y no el de cada partícula en lo individual.

El segundo fenómeno subversivo fue el movimiento browniano, referido al hecho misterioso presente bajo observaciones al microscopio, que hace que los granos de polen parezcan revolotear al azar. Este movimiento impredecible de los objetos inanimados no se podía explicar en el momento histórico en que fue identificado. Todavía un tercer fenómeno subversivo apareció, fue la radiación. El fenómeno de ciertas clases de átomos que los llevan a convertirse en otra clase de elemento, y cuyo proceso emite energía. En 1896 fue identificado este fenómeno en el uranio, como radiación en apariencia espontánea, sin causa particular. En 1900, estudiando la radiación de óxido de torio, Ernest Rutherford salió con una ley cuantitativa. La intensidad de la radicación, dijo, cayó con el tiempo (lo que ahora llamamos vida media) de una manera consistente con cada átomo en términos una probabilidad fija de transformación por unidad de tiempo. Este tipo de ley probó en todos los elementos radiactivos su consistencia. Esta ley de Rutherford se parece a la de tasas de mortalidad, fue una tabla de tasas de mortalidad para los átomos. Más información proporciono esta técnica y ayudó a los científicos a encontrar un mecanismo que especifique una explicación causal para cada muerte atómica.

Esta acumulación de evidencia les dió a los científicos una sensación incómoda sobre algo misterioso que se escondía en una escala de distancias muy pequeñas. A finales del siglo XIX el estadounidense Charles S. Pierce propuso que la aleatoriedad residía en el corazón de la naturaleza, esto se sentía, los científicos no llegaran a un final de leyes válidas para todas las escalas y disciplinas necesarias para explicar el universo. Los elementos subversivos parecerían obligar a los científicos a utilizar probabilidad y estadística como la mejor herramienta disponible para elementos de comprensión fuera de alcance, desde luego por su elevada complejidad. El personaje que transformó la estadística y la probabilidad en una herramienta conveniente, aunque cada vez más indispensable y en un elemento estructural del mundo fue Albert Einstein, en una serie de tres artículos sobre la teoría cuántica escritos entre 1916-17.

Estas ideas relacionaron las propiedades ondulatorias de la luz, problemas de termodinámica, y la ley de la radiación cuantitativa de Rutherford, para instalar la probabilidad en el corazón del comportamiento atómico. A pesar que lamentó que esto fuera así. La concepción original de Planck sobre el quantum no implicó a la probabilidad. Ni Einstein lo explicó en 1905 al modelar el efecto fotoeléctrico, aunque estaba preocupado por otros asuntos, especialmente en el desarrollo de la relatividad general. Es hasta que Einstein queda impresionado por el trabajo de Bohr de 1913-1914, que describe los átomos como almacenamiento de energía absorbida de la radiación por electrones en movimiento, de estados inferiores a estados superiores, y luego soltando esa radiación moviendo a los electrones nuevamente hasta un estado más bajo; en el proceso se emite luz en frecuencias específicas correspondientes a la diferencia de energía de los dos estados. Esto es lo que crea el espectro de un elemento, la huella de su estructura cuántica. Pero Bohr aún no usó las distribuciones de probabilidad en la discusión sobre los saltos de los electrones entre estados. Solo a finales de 1915, cuando Einstein completó su teoría de la relatividad general, es que vuelve a examinar cómo los cuántos son emitidos y absorbidos por la materia.

Inmediatamente en agosto de 1916, Einstein escribió a su amigo Michele Besso una idea brillante, una derivación de la fórmula de Planck, asombrosa y simple. Recuerde que Planck había estipulado que estos osciladores trabajan de esa manera particular, no proporcionando la correlación entre h y . Entonces Einstein adoptó la estrategia desarrollada para su física relativista especial y general, omitiendo la cuestión de qué tipo de materia emite y absorbe la luz para centrarse en una derivación general. Pero para ello requirió introducir un factor de probabilidad como una parte fundamental, así entre 1916-17 describió la naturaleza en términos de fundamentos de probabilidad como técnica. Todo esto cambiaría en 1925-27 con la revolución de la mecánica cuántica, con la función de onda de Schrödinger y el principio de incertidumbre. Se hace referencia a la aleatoriedad cuántica y de probabilidad cuando el astrónomo británico Arthur Eddington, en un texto titulado “La naturaleza del mundo físico”, dibujo para la atención pública, que función aleatoria en general y en lo particular al principio de incertidumbre dentro de la teoría cuántica: “la mecánica cuántica es un determinismo de probabilidades, una fórmula de hierro, para un determinismo posible limitado”. El desfile de átomos, Eddington lo presentó como una filosofía aleatoria del universo.

Cada una de las contribuciones de Einstein a la física cuántica muestra que era el maestro principal del siglo XX de termodinámica y mecánica estadística, campos newtonianos de probabilidad, aleatoriedad y la teoría de la norma estadística. Es lógico entonces pensar que fue el quien introduce en el núcleo atómico la teoría cuántica y escribe las bases de la naturaleza cuántica, a pesar de sus protestas reflejadas en su frase “Dios no juega a los dados”.

En sus documentos de 1916-17 Einstein trata a la luz como partícula –idea introducida en su artículo del efecto fotoeléctrico en 1905- y procedió preguntando: ¿Cuáles son las condiciones en la distribución de partículas de la luz para un sistema de moléculas y fotones para estar en equilibrio térmico a una determinada temperatura? Había ya principios bien aceptados para determinar la distribución de probabilidad de diversas excitaciones de energía de cada molécula. De esta y otras informaciones generales sobre cómo debe comportarse la luz, Einstein dedujo precisamente la distribución de energía de la luz, que obtuvo Planck en 1900 por medios cuestionables.

Einstein imaginó un trozo de materia, lo llamó una molécula, aunque también podría haber sido un oscilador o átomo, bañado en radiación de luz. Se preguntó ¿Cómo debe absorber y emitir radicación? Supongamos que está en equilibrio, lo que significa que absorbe y libera energía al mismo ritmo. Su tasa de emisión en presencia de este baño de radiación es mayor en comparación con lo que sería sino hay otros fotones a su alrededor. Einstein utiliza las ideas de equilibrio termodinámico en la conclusión de que la tasa a la que un átomo sería capaz de emitir un fotón en presencia de un campo externo, es mayor que en el átomo en el espacio vacío. Calculó cómo esto funcionaría, como proceso de emisión y absorción, y predijo que están relacionados entre sí. Hay una parte espontánea relacionada solo entre átomo y electrón, y otra relacionada con los fotones. ¿Pero cuándo va emitir la luz el átomo y de qué manera va a suceder, cuando ambas cosas son impredecibles?, propuso que las probabilidades se tendrían que considerar fundamentales, básicas, físicas de sistemas atómicos. Esto permitió una derivación de la ley de Planck de una manera asombrosamente simple y general.

Pero es en este momento histórico, que Einstein tuvo su primer arrepentimiento. Pensó que estos resultados eran una debilidad de la teoría, que deja tiempo y dirección de los procesos elementales al azar. No había manera de saber cuándo y en qué dirección el fotón saldría, sin embargo, concluyó, “tengo plena confianza en la ruta que se ha tomado”.

Einstein escribió a Max Born que no podía creer que Dios juega a los dados. Pero el propio Einstein fue el primero en dar a entender que esto era de hecho cómo funciona la Deidad, en su simple derivación de la fórmula de Planck. Hacia el final de su vida, cuando hablando con un grupo de cirujanos de Cleveland en 1950, Einstein expuso uno de sus ejemplos más simples de aleatoriedad en la física cuántica. "Suponga que tiene una ola llegando a un límite entre dos medios refractivos. La teoría de Maxwell garantiza que habrá una onda transmitida y una onda reflejada. Haciendo esta onda tan débil que solo una vez al mes llega un fotón: qué pasara ¿se reflejara o se transmitirá?. No hay manera de saber, puede darse la probabilidad de ambas, pero no sabremos qué pasará".

1.2 Entropía

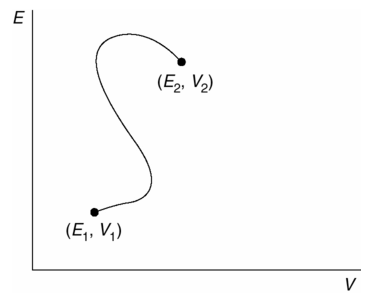

Entropía es un término importante por muchas razones, su función principal en la termodinámica es cuantificar la irreversibilidad de un proceso termodinámico, sobre objetos microscópicos compuestos de muchas partes del mismo tamaño que forman un sistema complejo que tiende al equilibrio de sus variables termodinámicas como presión, volumen, temperatura, número de masa molar o mol, energía interna y por supuesto, entropía. Algunas de estas variables están relacionadas a través de ecuaciones de estado.

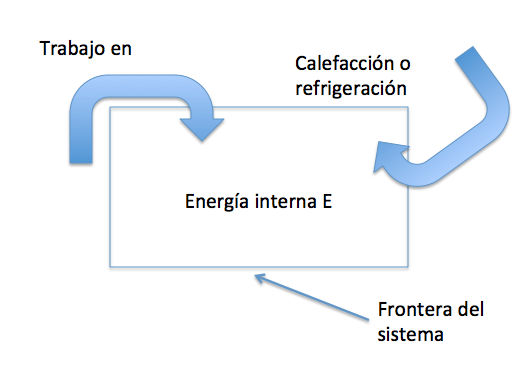

Un sistema termodinámico experimenta un proceso cuando las variables que lo describen cambian desde un conjunto de valores a otro distinto, es decir, cambian de estado termodinámico. Cuando se exhibe una energía igual o isoentrópico, es decir, constante, como ocurre en un sistema completamente aislado, se dice que es adibático porque no intercambia energía. Las leyes de la termodinámica limitan las maneras en que un sistema puede proceder de un estado a otro. La primera ley termodinámica es la ley de conservación de la energía aplicada a la energía interna de un sistema termodinámico. La energía interna no incluye la energía de la posición o movimiento del sistema como un todo. Según la primera ley hay solo dos maneras de cambiar la energía interna de un sistema dado. La primera por calefacción o sistema de enfriamiento, y dos, trabajando en el sistema o arreglo para que el sistema trabaje en su entorno. Matemáticamente esta primera manera le corresponde la ecuación:

![]() Ec. 1.1

Ec. 1.1

Donde ![]() es el incremento de energía interna E de un sistema termodinámico, dado por transiciones de un estado inicial

es el incremento de energía interna E de un sistema termodinámico, dado por transiciones de un estado inicial ![]() a otro final

a otro final ![]() . La cantidad Q es al energía absorbida por el sistema cuando se calienta, y W es el trabajo realizado en el sistema durante la transición. Estas son cantidades asignadas así que cuando Q < 0, el sistema se enfría en vez de calentar y cuando W > 0, se trabaja sobre el sistema. Cuando estos cambios son infinitesimales la expresión se hace:

. La cantidad Q es al energía absorbida por el sistema cuando se calienta, y W es el trabajo realizado en el sistema durante la transición. Estas son cantidades asignadas así que cuando Q < 0, el sistema se enfría en vez de calentar y cuando W > 0, se trabaja sobre el sistema. Cuando estos cambios son infinitesimales la expresión se hace:

![]() Ec. 1.2

Ec. 1.2

Aquí hay diferentes notaciones, ![]() versus

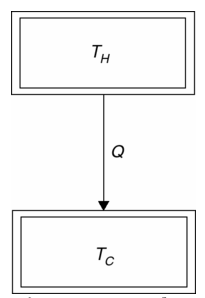

versus ![]() , para destacar que mientras que E es una variable que describe el estado de un sistema, Q y W no lo son, dado que indican la cantidad de energía infinitesimal transferida hacia o desde un sistema. Así, ¿un sistema termodinámico contiene energía?, de hecho no, contiene calor o trabajo, como sugiere la Figura 1.1.

, para destacar que mientras que E es una variable que describe el estado de un sistema, Q y W no lo son, dado que indican la cantidad de energía infinitesimal transferida hacia o desde un sistema. Así, ¿un sistema termodinámico contiene energía?, de hecho no, contiene calor o trabajo, como sugiere la Figura 1.1.

Fig. 1.1 La energía interna E de un sistema termodinámico puede cambiarse de dos maneras: 1) por calefacción y refrigeración, y 2) por trabajo.

Todas las interacciones entre partículas fundamentales son reversibles. La interacción más simple es una colisión entre dos partículas fundamentales. Una partícula se aproxima a otra; interactúan mediante fuerzas gravitacionales, electromagnéticas o nucleares; entonces ellas se alejan unas de otras. Podríamos pensar la colisión como dos canicas dentro de un frasco de canicas de igual característica, donde una está inicialmente en reposo, decimos que las interacciones entre partículas fundamentales son en el tiempo reversibles.

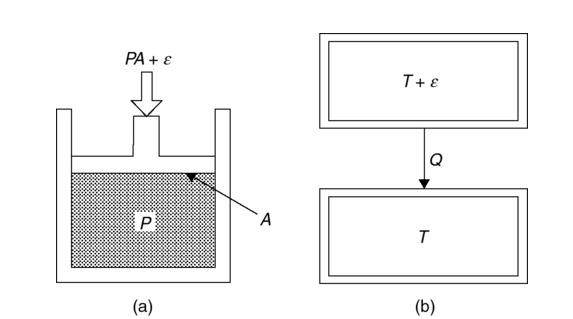

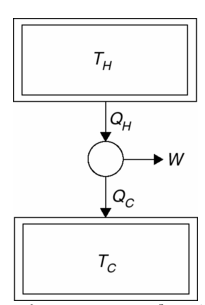

No puede decirse lo mismo de los procesos de un sistema termodinámico compuesto, como es de muchas partes diferentes, son normalmente irreversibles. Sin embargo, hay un sentido especial en el que un proceso termodinámico significativo se puede invertir. Si se hace un pequeño cambio infinitesimal en el sistema o en su ambiente y luego se invierte la dirección del cambio del proceso, uno pensaría que el proceso es termodinámicamente reversible. Sadi Carnot (1796-1832) creó el concepto de reversibilidad termodinámico para expresar y demostrar lo que ahora se llama Teorema de Carnot: el motor térmico más eficiente es aquel que opera reversiblemente[9].

Un proceso termodinámico reversible debe ser cuasiestático, es decir, infinitesimal lento y sin fricción o disipación (fricción interna). Consideremos, por ejemplo, el pistón comprime el fluido que ilustra Figura 1.2a. El pistón cuasiestático y fricción casi despreciable, se comprime el fluido cuando fuerza del pistón se ejerce sobre el fluido, ![]() , es una cantidad indefinidamente pequeña más grande que la fuerza PA a la que el fluido de presión P que se ejerce sobre la cabeza del pistón de área A. Cuando en cambio, la fuerza ejercida por el émbolo sobre el líquido es infinitamente menos que PA, es decir,

, es una cantidad indefinidamente pequeña más grande que la fuerza PA a la que el fluido de presión P que se ejerce sobre la cabeza del pistón de área A. Cuando en cambio, la fuerza ejercida por el émbolo sobre el líquido es infinitamente menos que PA, es decir, ![]() , el fluido se expande cuasiestático. Así, estos son cambios termodinámicamente reversibles porque su dirección puede invertirse para un cambio infinitesimal en el sistema o en su ambiente. De manera similar, el calentamiento o enfriamiento de un sistema por parte de otro sistema, es reversible cuando se mantiene una diferencia de temperatura infinitesimal entre los dos como se muestra en la Figura 1.2b. Claramente, la reversibilidad termodinámica es un ideal que puede ser abordado, pero nunca en la realidad plenamente. Todos los procesos termodinámicos reales son irreversibles.

, el fluido se expande cuasiestático. Así, estos son cambios termodinámicamente reversibles porque su dirección puede invertirse para un cambio infinitesimal en el sistema o en su ambiente. De manera similar, el calentamiento o enfriamiento de un sistema por parte de otro sistema, es reversible cuando se mantiene una diferencia de temperatura infinitesimal entre los dos como se muestra en la Figura 1.2b. Claramente, la reversibilidad termodinámica es un ideal que puede ser abordado, pero nunca en la realidad plenamente. Todos los procesos termodinámicos reales son irreversibles.

Fig. 1.2 (a) Un pistón sin fricción reversible comprime un fluido. (b) Dos sistemas con una temperatura infinitesimal de diferencia de calor al enfriarse en contacto mutuo entre sí se vuelven reversibles.

En síntesis, todos los procesos fundamentales o idealizados son reversibles porque uno no puede imaginar invertir su dirección del cambio sin violar las leyes de la física. Por otro lado, todos los procesos termodinámicos no idealizados son irreversibles. Los procesos termodinámicos, en la práctica, proceden siempre en una dirección.

¿Por qué no todos los procesos son reversibles? Se sugiere que las leyes que gobiernan las interacciones de partículas fundamentales no forman una imagen completa de la naturaleza y necesitan ser complementadas con la física adicional equivalente a la segunda ley de la termodinámica.

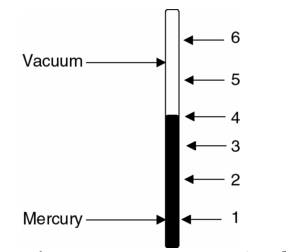

Hay un número de versiones lógicamente equivalentes de la segunda ley. Rudolph Clausius (1822-1888) fue el primero en 1850, identificó una versión de la segunda ley de la termodinámica. Para este propósito Clausius elevó las observaciones sobre calefacción y refrigeración para el estado de una ley general: un objeto frío nunca calienta un objeto más caliente. Por ahora basta con entender por temperatura como un valor pico promedio en alguna escala de medición y una fuente de energía será un reservorio de calor.

Un reservorio de calor mantiene la misma temperatura independientemente de cómo interactúan refrigerante o calefacción. Así un reservorio de calor tiene la capacidad infinita de calor como si estuviera indefinidamente creándolo. En el lenguaje, reservorio de calor, Clausius enuncio la segunda ley.

En 1851, William Thomson, más tarde conocido como Lord Kelvin formuló una versión distinta de la segunda ley, se refiere a la operación de un motor térmico, es decir, un dispositivo que utiliza una diferencia de temperatura para producir trabajo. Según la segunda ley de Kelvin: un motor de calor cuyo único resultado es causar un reservorio de calor, solo pierde energía Q a través de refrigeración y es imposible que realice la misa cantidad de trabajo![]() .

.

Teniendo en cuenta la primera ley, la versión de Kelvin de la segunda ley es lógicamente equivalente a la Clausius. Pero la de Kelvin parece la más indicada desde el punto de vista del lenguaje tecnológico.

La segunda ley de la termodinámica puede ser también expresada en términos del lenguaje de procesos irreversibles. Hay que recordar que establecimos que un proceso real es irreversible, es decir, no se puede revertir completamente. Por lo tanto, otra forma de decir esto es que un determinado proceso es prohibido, es decir que el proceso es el resultado de la inversión de un proceso termodinámico irreversible.