Texto académico

Autores

Eduardo Ochoa Hernández

Nicolás Zamudio Hernández

Gladys Juárez Cisneros

Lizbeth Guadalupe Villalon Magallan

Pedro Gallegos Facio

Gerardo Sánchez Fernández

Rogelio Ochoa Barragán

_____________________________

2. El orden depende de muchas variables

Aquellos que se saben exploradores de lo profundo se esfuerzan por la claridad. Aquellos que quisieran parecer profundos se esfuerzan por la oscuridad.

Nietzsche. The Gay Science.

A menudo se encuentran los estudiantes con la necesidad de realizar experimentos mentales, estos se encuentran en la raíz de los avances realmente importantes de la física moderna, en sus revoluciones matemáticas. Tales experimentos de pensamiento generalmente sondean alguna suposición funcional, con respecto al espacio, el tiempo, la luz, la fuerza, la causalidad, el determinismo, la materia, la gravedad…, este tipo de enfoque al pensamiento en el sentido del análisis de redes de conceptos y objetos matemáticos, es una parte fundamental del entrenamiento del estilo científico del pensar. Uno no puede hacer física sin hacer ciertas suposiciones, por mínimas que sean, sobre cómo las teorías que uno está usando como mapa sobre la realidad observable abordan las justificaciones y los hechos.

Uno necesita formarse una postura sobre lo que los componentes de las teorías refieren, la distinción de un pensamiento sofisticado de lo que objetivamente existe en la realidad. Casi nunca es un asunto trivial; especialmente porque las teorías físicas a menudo hacen uso de todo tipo de idealizaciones, aproximaciones y métodos indirectos para representar un sistema objetivo. El trabajo de la física, es decir algo sobre la estructura de la realidad, sobre lo que es el universo, qué objetos existen, qué propiedades tienen, cómo se comportan, cómo se relacionan unos con otros, y así sucesivamente.

La interpretación de la realidad está estrechamente vinculada a la ontología: interpretación que proporciona una justificación para lo que existe y sus propiedades dentro de la función de criterios de lo verdadero. El intérprete responderá en el sentido de satisfacción de los postulados teóricos básicos (leyes o axiomas). Lo que interpretamos, es entonces un conjunto de mundos posibles que hacen que la teoría sea verdadera; o, un conjunto de mundos posibles que guardan coherencia con los datos y predicciones.

Hay, entonces, dos partes de una interpretación: una parte sintáctica en la que se disponen las estructuras formales de la información y los axiomas centrales (lógica epistemológica) y, una parte semántica, que proporciona las estructuras formales del significado (lógica doxástica), es decir, los mundos posibles a partir de un modelo sintáctico. La multiplicidad de interpretaciones es una bendición en el contexto de la poesía. Pero en el caso de una información matemática para una teoría que admite múltiples interpretaciones (diferentes formas de llenar su semántica), nos enfrentamos a un problema, si vemos nuestras teorías como algo que nos dice cómo es el mundo, esto sería algo incompatible. Una interpretación podría ser local, de modo que no haya acción a distancia, mientras que otra interpretación (de la misma teoría) podría ser no local, dirigida al universo entero. Una podría ser determinista y otra indeterminada, y así sucesivamente. No todas las teorías pueden ser vistas como conectadas a tierra en nuestro mundo, ya que hay contradicciones involucradas dentro de las capas subyacentes de la realidad. Así que, aquí tenemos una sorprendente desanalogía con el caso poético, el contacto con lo real es el deseo más profundo. Podríamos preferir una teoría sobre otra, pero nos vemos obligados a creer en una única verdad; como vemos, una teoría tiene como objetivo proporcionar una imagen de la realidad dentro de un espacio de significado.

Hay un nivel adicional al juego de interpretación que aún no hemos mencionado. Esto es que el formalismo interpretado también puede ser objeto de una interpretación adicional (y una mayor multiplicidad de sentidos). El formalismo es una creencia bajo una base axiomática que resulta sin contradicción lógica, pero que es independiente de lo que existe en la realidad. En otras palabras, consideremos que nuestro objeto de estudio debe interpretarse no en un formalismo desnudo, sino como una estructura ya interpretada que debe estar probada con lo observable en el universo. Por ejemplo, podríamos estar estudiando la interpretación de muchos mundos de la mecánica cuántica, cada uno con un juego de ecuaciones fundamentales coherentes y sin compatibilidad con otro mundo. Podemos decir, que este formalismo interpretado es contestar cómo puede ser el mundo para que esto sea verdad. Una vez más, podría haber una multiplicidad en este nivel superior de mundos posibles, donde proporcionar una semántica al formalismo básico, no es suficiente para fijar una imagen del mundo en todos sus detalles.

Los muchos mundos posibles son vistos como universos separados que literalmente se ramifican unos con otros, como algo cuántico que nos sobrepasa, que implica otro juego de leyes subyacentes al mundo. Del mismo modo, la relatividad general (la teoría de la gravitación de Einstein) donde entendemos es una teoría de la geometría espacio-tiempo, en esta surge de nuevo la pregunta, dado este formalismo interpretado en términos de curvaturas espacio-tiempo, ¿Cómo es el mundo? ¿Hay una geometría literal espacio-tiempo en el mundo, tan sustancial como gatos y libros? ¿O de alguna manera se construye a partir de gatos y libros, y otras cosas de masa-energía? ¿Cuánto de la imagen de la geometría espacio-tiempo, suponemos que se asigna al mundo o, solo la geometría o los puntos sin extensión subyacente a esta estructura?

A veces simplemente la juventud en nuestra universidad se instala en la teoría del formalismo interpretado, en lugar de una interpretación dentro de estructuras matemáticas generadoras de espacios de significado subyacente; es decir, se aprenden conceptos y no sus procesos de justificación, explicación y demostración. Para la mayoría de las personas (incluidos los físicos), la relatividad general es solo una teoría sobre la curvatura, dada por la geometría espacio-tiempo y la forma en que la curvatura depende de los pesos de la materia-energía en el espacio-tiempo. Pero este es solo un enfoque posible. Una imagen plana de espacio-tiempo con gravedad mediada por una partícula de intercambio (el gravitón), también puede llamarse con razón, relatividad general. Aquí, el tensor métrico dinámico variable (que representa la geometría del espacio-tiempo en la imagen ortodoxa) se trata de solo otro campo en el espacio-tiempo plano, hay detalles técnicos involucrados en la recuperación de las mismas predicciones y propiedades de simetría, pero no tenemos por qué preocuparnos por esto. El punto es que, podemos tratar la teoría como un espacio curvo o un espacio plano; que tendemos a trabajar con un enfoque que no hace nada para restar al hecho de que la imagen del espacio curvo es también una interpretación tipo.

Entonces, ¿Por qué funciona la física? Uno de los hechos más desconcertantes sobre la física es que funciona muy bien. ¿Cómo las teorías realizan esta increíble hazaña? Tranquilos, se podría decir, que funciona porque son verdaderas. Pero dado el tema de la multiplicidad en las interpretaciones de una teoría ¿Qué imagen es verdadera? A menudo se tienen ontologías muy diferentes, una con campos y otra con partículas en su lugar. Lo que nos preocupa aquí es por qué las matemáticas son capaces de predecir y describir eventos físicos. ¿Por qué no funcionan las bolas de cristal? Al menos en un universo de entidades que no necesitan un observador para existir.

Este problema fue planteado por Eugene Wigner en 1960, en su artículo “The unreasonable effectiveness of mathematics in the natural sciences”. La enorme utilidad de las matemáticas en la ciencia es algo que bordea lo misterioso, eso que no explica la razón para ello. Hay ramas de las matemáticas que nos permiten predecir el comportamiento de cometas, misiles, drones, tráfico de internet y la economía. ¿Por qué las estructuras matemáticas encuentran una aplicación tan fructífera en la física?

Hay dos tipos de explicación que podemos pensar aquí, una más irrazonable que otra: 1) un tipo dependiente de la física, y 2) otra independiente de la física. Por ejemplo, hay casos en los que las matemáticas se han desarrollado de la mano con algunas piezas de física, el cálculo fue construido con un problema físico en mente, a saber, fue construido para resolver ecuaciones de movimiento en la evolución de un sistema. La creación de John von Neumann del espacio Hilbert (en el que están representados los estados cuánticos) también fue de este tipo: otro caso para encontrar herramientas matemáticas apropiadas para el trabajo. La eficiencia de las matemáticas claramente no es tan irrazonable en estos casos: es un criterio de búsqueda exitosa de herramientas eficaces. A lo largo de la historia muchas herramientas matemáticas que no eran para el propósito, fueron descartadas.

El tipo irrazonable es que las aplicaciones de las matemáticas en la ciencia fueron creadas independientemente de la física y sin embargo, más tarde se encontró su aplicación en la física. Por lo tanto, los matemáticos se ocuparon con algún problema puramente matemático, no se preocuparon una pizca por el mundo de la física, y sin embargo, lo que aquí se encuentra, es que el ajuste perfecto de piezas matemáticas al mundo físico es asombroso. Por ejemplo, los números complejos encuentran un hogar perfecto en la mecánica cuántica. Se encontraron geometrías no euclidianas para proporcionar el marco perfecto para la relatividad general. Los llamados “spinors” de Henri Cartan, en 1913, se encuentran encajados perfectamente en el espín intrínseco de los electrones descubiertos en 1926, y que fueron fundamentales para las predicciones teóricas de antimateria de Paul Dirac, quien combinó los “spinors” con la matemática de la mecánica cuántica. ¿Cómo puede ser esto?

Hay varias respuestas que uno podría dar. Una posible es que incluso las matemáticas más puras provienen de investigaciones del mundo en algún nivel. Es decir, incluso el punto de vista más idealista de las matemáticas como una creación pura de la mente humana, debe conciliarse con el hecho de que la elección de definiciones y axiomas de la geometría es el resultado de impresiones, obtenidas a través de nuestros sentidos por estímulos externos e inherentemente en estas observaciones experimentamos el “mundo exterior en la mente”.

Esto no explica realmente cómo las matemáticas pueden extender la física para ir más allá de lo que podemos obtener a través de los sentidos: nuestros sentidos a menudo están equivocados, y ciertamente no podemos ponernos directamente en contacto con átomos y quarks.

Mejor, uno podría desinflar el rompecabezas mostrando cómo no es más milagroso que encontrar, por ejemplo, un mueble que encaja en algún espacio en una habitación, a pesar de que el fabricante no tenía idea de nuestra habitación. No queremos sugerir que la física matemática está a la par con el diseño de interiores, por supuesto, pero en términos del principio básico detrás del despliegue de las matemáticas en la física, creemos que hay paralelismo aquí. Pero hay un aspecto crucial que no se trata: el mobiliario encaja porque el espacio tiene una estructura con las dimensiones adecuadas. Es una coincidencia que sus estructuras se basen en el ajuste.

Podríamos adoptar la opinión de que dado que la matemática es una ciencia de patrones y estructuras de información y el mundo está organizado en patrones y estructuras, no hay misterio sobre su relación, simplemente la realidad es producto del Big Bang matemático. Naturalmente, algunas estructuras coinciden y otras son sintéticas, entonces la eficacia razonable es encontrar solo las equivalentes a estructuras isomórficas o razonablemente que creen nuevos elementos a la realidad, estamos hablando de anticuerpos, música, pigmentos, fármacos, elementos químicos…, todos ellos sintéticos. ¿Por qué debería importar que encontremos primero las estructuras sintéticas justo antes que las físicas? Un problema en este punto de vista es que a veces las matemáticas son efectivas sin que nosotros queramos decir que hay cierto isomorfismo estructural entre matemática y mundo. También hay todo tipo de idealizaciones en la física, en las que el modelo matemático y el mundo no se pueden ver que correspondan en términos de estructuras reales.

La mejor idea a tener en cuenta, es que estamos tratando con representaciones científicas en forma de estructuras matemáticas. Es imitar o capturar lo que del sistema nos interesa. ¿Nosotros podemos visualizar lo que está pasando en este tipo de modelado? Primero despreciamos detalles, luego nos ocupamos del sistema modelando una estructura matemática para este, y después desarrollamos una teoría de su comportamiento. La pregunta es, qué representación teórica se describe emparejada al mundo. A menudo es asombroso que estos modelos predicen el sistema de interés.

Un estado del sistema clásico, cuántico, estadístico o relativista. Con los estados de un sistema nos referimos, a propiedades o valores completos que un sistema puede adoptar en un instante dado, por ejemplo, bajo acciones de fuerza. Estos estados están en la base misma de los observables. Un pilar de la física es el espacio-tiempo, como parte de la mayoría de las representaciones empleadas en la física. Si se suponen que modelan el mundo, entonces deben contener el espacio y el tiempo porque así es como el mundo parece estar configurado, al menos en algún nivel de aproximación en la física clásica, relativista, pero, no en la gravedad cuántica, que sugiere que el espacio-tiempo no es una característica fundamental de la realidad, por lo que el espacio-tiempo emerge de alguna teoría no espacio-temporal más profunda.

Las teorías de espacio-tiempo tienden a coincidir con respecto a su estructura básica (más profunda), un conjunto de puntos tomados para representar los eventos básicos de la realidad (o lugares donde los eventos, como partículas de puntos de colisión, pueden tener lugar). Sin embargo, algunos han argumentado que independientemente de la estructura adicional, tales puntos no pueden representar cosas físicas reales. Las teorías distintas entonces, divergen de acuerdo con qué estructura adicional se aplica a esta base, dependiendo de lo que deseen que la teoría represente. Sobre este conjunto de puntos podemos poner gráficos o coordenadas, etiquetándolos y permitiéndonos hablar de las relaciones de puntos entre sí, este conjunto de puntos tiene la estructura a saber, algo que se ve localmente (a distancias cortas), como en el espacio plano ordinario, pero puede variar de todas las maneras globalmente. Podemos mapear estos puntos y regiones a través de transformaciones para representar todo tipo de cambios posibles: movimientos espaciales, rotaciones, evaluaciones de sistemas estáticos del tiempo o el espacio recorrido…, que pueden ocurrir en el universo así modelados. Lo que es más importante, es que podemos ver, lo que permanece en el mismo estado invariable, como ciertos cambios constantes. Tales invariancias son el material de las leyes de la naturaleza.

Las estructuras matemáticas, capaces de habitar en variedad (o un espacio más complejamente estructurado, con una métrica que permite hablar de distancias) se eligen con cuidado para que coincidan con las características de las propiedades y comportamientos de los objetos que se describen. Necesitamos establecer una coincidencia (un isomorfismo) entre la forma en que los objetos matemáticos elegidos se transforman y la forma en que creemos que los sistemas representan la transformación. Por ejemplo, las cosas físicas (sistemas) de una teoría (partículas, campos, cuerdas) se definen en esta estructura multivariable y están representados por objetos geométricos (escalares, vectores, tensores, spiners). Estos corresponden a los objetos que considerarían espacio y tiempo “ocupado”. Los objetos se caracterizan por su comportamiento en las asignaciones de multivariedad, como los cambios de las coordenadas (correspondientes al movimiento o rotación), como se mencionó, tales objetos se definen en relación con un multivariante espacio-tiempo que trae consigo todo tipo de herramientas matemáticas y conceptos de cálculo, haciendo posible la empresa de la física moderna.

Una partícula puntual ocupará un único punto multivariante (espacio-tiempo), campos infinitos de puntos, con un valor de campo situado en cada punto multivariante. Un multivariante unidimensional de puntos espacio-tiempo nos da un conjunto de elementos para cada construcción del mundo: un conjunto de objetos localizados en el espacio y el tiempo que podrían ser relacionados de varias maneras y que podrían tener varias trayectorias posibles a través del espacio. Tenga en cuenta que, no tenemos que tener nuestros objetos básicos exactamente equivalentes a lo que deseamos modelar: siempre habrá aproximaciones dependiendo de la tarea. Por ejemplo, perfectamente es posible tratar la Tierra como un punto en algún modelo, si todo lo que tenemos que pensar es en su posición, masa, desplazamiento.

Aún así, falta mucho en términos de representar un mundo como el nuestro: necesitamos saber más sobre qué propiedades tienen los objetos básicos, cómo se combinan e interactúan, y cómo cambian y se mueven. Estos requieren especificar los estados y observables (cinemática), y su evolución a lo largo del tiempo (dinámica). Esto nos proporcionará una representación formal de un sistema físico (su estructura lógica) o incluso un universo junto como tal.

Hay otras trampas a la espera del genio maligno de Descartes, generadas por la representación matemática, pero sin los elementos correspondientes en la realidad. La versión moderna del antiguo debate presocrático sobre la realidad del espacio y el tiempo (en su relación con la materia). Podemos preguntarnos cómo las simetrías del espacio y el tiempo actúan sobre situaciones físicas, y si los nuevos estados que generan son físicamente reales en este sentido. Podemos cuestionarnos también, si los puntos de espacio-tiempo son reales (a pesar de la apariencia, o que se consideran puntos de multivariedad en el modelo matemático). Es claro que los modelos matemáticos de la física no llevan sus interpretaciones consigo.

Considere K estados observables y la dinámica L. Este triplete agrupa esencialmente la cinemática (estados + observables: relacionados con el espacio, el tiempo y el movimiento) y la dinámica (las fuerzas físicas y las interacciones que limitan los movimientos cinemáticamente posibles), viendo una teoría como la combinación de estos, haciendo así la vida de un intérprete más fácil, al darnos los sistemas y sus propiedades junto con la regla (dinámica) de cómo cambian y varían con el tiempo y el espacio.

El espacio, el tiempo y el movimiento son los elementos centrales en la cinemática de una teoría física. Por lo general, este básico debe decidirse primero y luego se introducirán las leyes (dinámicas) para restringir qué movimientos son realmente posibles en relación con tal fondo. La división en cinemática y dinámica nos llega de Aristóteles, quien veía al kinesis como una especie de estado del ser potencial, mientras que la dinámica era el estado del ser real. Los historiadores han sufrido en sus cerebros durante esta distinción de Aristóteles durante muchos siglos, pero traducido en nuestros términos modernos, podemos ver que la cinemática se refiere a posibles movimientos cuando ignoramos la acción de cualquier fuerza y ley de la naturaleza en el espacio temporal antecedente; mientras que la dinámica se refiere a qué movimientos pueden ser reales una vez que se introducen las leyes del movimiento de Newton. Clásicamente se entiende que la mecánica es una combinación bastante sencilla de estos dos componentes: cinemática + dinámica. Todas las características de un mundo se entienden para fluir a partir de una especificación de ambos elementos.

Las trayectorias cinemáticas posibles incluirán, por supuesto, las trayectorias dinámicas posibles: el antiguo espacio de posibilidades es mucho mayor que el segundo. La distinción moderna se puede vincular estrechamente a la de Aristóteles centrándose en lo que es posible en los dos escenarios: la cinemática, es sobre qué movimientos son posibles dadas las limitaciones del espacio-tiempo, en sí, junto con los navegantes de los objetos básicos (un mundo en tres dimensiones espaciales, movimientos en más dimensiones estarán restringidos). Podemos pensar en ellos como mundos metafísicamente posibles, pero no necesariamente mundos físicamente posibles: mundos que son concebibles, pero tal vez, no son compatibles con nuestras leyes. Podemos pensar en la introducción de la dinámica como una demanda de explicación sobre por qué las cosas cambian sus movimientos o se detienen. Por lo tanto, tenemos la concepción estándar de la cinemática como el estudio de los movimientos de los cuerpos en ausencia de fuerzas, y la dinámica como el estudio de los efectos de las fuerzas en esos movimientos.

Aunque utilizamos matemáticas en esta representación de trayectoria (movimientos), especialmente utilizamos nociones de geometría, hay una desconexión radical con cómo los conceptos aplicados a la física que se relacionan con los conceptos puros matemáticos. Por ejemplo, un movimiento en el sentido geométrico, simplemente implica asociar un punto a otro punto sin trayectoria continua que los una (al menos, no es necesario: se podría imaginar al punto que se lleva a cabo su análisis, en un camino continuo, pero no es esencial). En el caso de los movimientos físicos, sin embargo, los caminos suaves entre los puntos iniciales y finales son cruciales (las funciones f(x,y,z) ) y forman parte de nuestra imagen de cómo funciona el mundo. Pero más profundo que esto (aunque no innegable) es la creencia de que para llegar de un punto A a un punto B, los puntos intermedios deben ser atravesados, durante los cuales, el objeto que se mueve conserva su identidad en cierto sentido, paso a paso por el espacio y el tiempo:

Como lo presentó Kurt Lewin, la genidentidad es una relación existencial que subyace en la génesis de un objeto de un momento a otro. Lo que generalmente consideramos un objeto en realidad consiste en múltiples entidades, que son las fases del objeto en varios momentos. Dos objetos no son idénticos porque tienen las mismas propiedades en común, sino porque uno se ha desarrollado a partir del otro durante el cambio de fase.

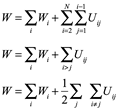

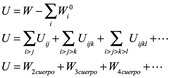

En los enfoques modernos de la física, de hecho, cambiamos a una representación más abstracta: hablamos de estados y observables en lugar de la cinemática (con su espacio, tiempo y movimiento asociado). Pero no prescindimos completamente del espacio y el movimiento; en forma de un espacio estado y trayectoria en ese espacio. Así como podríamos construir un espacio a partir de todas las combinaciones posibles de algunos parámetros, como las mediciones x,y,z para el espacio ordinario, también podemos ver las llamadas variables canónicas como coordenadas generalizadas para este tipo de espacio (conocido como espacio de fase: el espacio estado de la mecánica clásica). Cada punto representa una asignación diferente de posiciones e impulsos en un sistema. Esto nos permite hacer cosas que no podemos hacer en el espacio físico ordinario. Por ejemplo, cuando estamos tratando con un sistema complejo de muchas partículas (con un gran número de partículas N), sería una tarea complicada tratar individualmente con cada uno de los caminos a través del espacio tridimensional. Pero con los espacios de estado podemos agrupar toda la información de 6N dimensiones, en el que un solo punto representa las posiciones (una configuración) y momento de todas las partículas N (teniendo en cuenta las tres coordenadas espaciales de cada partícula en espacio ordinario y su momento en tres direcciones espaciales) tomadas en un instante de tiempo.

Vamos a completar algunos detalles que faltan del concepto anterior. El estado de un sistema, como su nombre indica, es una foto instantánea de un sistema, que contiene información completa sobre este en un instante de tiempo, el propio sistema se entiende que está bien representado por este estado, que se construye esencialmente a partir de sus propiedades. En la mecánica clásica, este estado es simplemente la posición q (en el espacio físico) de una partícula junto con un impulso p (las variables canónicas). La idea, es que a partir de tal especificación de un estado, podemos ejecutarlo a través de las leyes de la teoría para llegar al estado del sistema en cualquier otro momento (la dinámica en ese nuevo esquema). El estado es, en este sentido, la entrada (al programa computacional) para las leyes, y el procesador, un cierto conjunto de ecuaciones de movimiento conocidas como ecuaciones Hamilton (básicamente, las leyes de movimiento de Newton reescritas en matemáticas de tensores). En este punto se separan físicamente, posibles evoluciones marginando las imposibles.

La física en su punto más general se refiere a las cantidades físicas (en lenguaje ordinario las llamaríamos propiedades), las interacciones entre cantidades del mismo y diferente tipo, y la tasa de cambio de tales cantidades. Una vez que tengamos nuestro conjunto de cantidades, las etiquetamos, es decir, son los observables: las cosas que podemos medir, que definirán el estado instantáneo del objeto que nos interesa (y, en cierto sentido, es cómo se define un objeto en la física). Podemos pensarlo en cómo estas cantidades interactúan en simetrías, así el estado y el objeto podrían cambiar en el tiempo. Podemos configurar ecuaciones de movimiento de la forma general:

Rango de cambio A= función de A

Encontrar cómo evolucionará un sistema, entonces, equivale a encontrarle una función particular que nos indique cada fase de estado, que resulta de las investigaciones de los físicos y sus modelos matemáticos. Integrando o diferenciando ambos lados de la ecuación, podemos encontrar valores futuros y pasados de su valor actual.

La posición y el impulso son observables del sistema y específicos a cada fase, encontrar todos los valores de los observables de un sistema determinará de manera única su estado, de la misma manera, conocer el estado significa conocer los valores de los observables. Medimos observables para obtener conocimiento sobre el estado. Por lo tanto, tenemos una correlación perfecta entre los estados y el conjunto completo de observables en un instante L ( q(t), p(t) ), son completos en la mecánica clásica en el sentido de que todos los demás observables se pueden construir a partir de ellos, utilizando algunas operaciones matemáticas (donde q(t) posiciones en el tiempo, y p(t) es la cantidad de movimiento en el tiempo). Estos observables proporcionan el vínculo central entre la teoría y el mundo en el contexto de la física: son cosas que medimos y cuyos valores predecimos. Como tal, ponen el carácter cualitativo de un mundo. Los observables en la mecánica clásica tienen un doble papel: por un lado, son cantidades medibles, lo que nos permite aferrar la teoría al mundo, proporcionando información específica del estado de un sistema en referencia al otro: la energía observable (función hamiltoniana), cuando se ve el término de espacio de fase, genera traducciones de tiempo.

Los observables en el sistema clásico son funciones desde el espacio de fase a números (reales): este es el vínculo entre la representación abstracta, dada por el espacio de estado y la realidad, como se da en las mediciones que se pueden asociar con el valor del número real. Un ejemplo clásico es una moneda. Este sistema de dos estados: Cara=1 y sol=0). Un observable tendría que ser una función en este espacio, de modo que arroje algún valor numérico dependiendo del estado en el que se alimenta. Ahora hemos hecho esta asociación, si queremos ser formales podemos escribir el espacio de estado como S=1,0. En la física se producen muchos más complicados ejemplos, como los observables de energía que arrojan un número que representa la energía total de un sistema (que puede ofrecer un continuo de valores posibles en lugar de 0,1). Pero aún así, esta sencilla configuración obtiene el punto básico: los observables clásicos son funciones desde el espacio de estado hasta los números reales.

Naturalmente, el espacio estado del sistema dependerá del tipo de sistema que sea. Los sistemas mecánicos cuánticos son tan radicalmente diferentes, porque los estados tienen probabilidades asignadas a ellos. Los observables de posición e impulso tienen valores numéricos reales en el contexto clásico, se les llama operadores (matrices hermitianas). Sin embargo, los valores propios del operador clásico (que representan los resultados de medición), tienen valores numéricos reales y estos son los que medimos en los experimentos. Estos operadores, al igual que con los observables clásicos, también sirven para crear nuevos estados a partir de los antiguos para su acción.

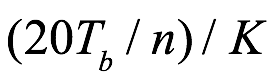

Gran parte de esta diferencia clásica cuántica, tiene que ver con el hecho de que las partículas cuánticas tienen aspectos de onda y partícula. Por esta razón, el estado de un sistema cuántico, está representado por una función de onda ![]() . Que representa la amplitud del aspecto de onda del sistema en la ubicación x (dada por tres coordenadas espaciales) en el tiempo t. Esta función de onda, debe ser un número complejo para representar los efectos de interferencia, generalmente asociados con los fenómenos de onda, y por lo tanto, no es en sí misma una cantidad observable. Pero se puede construir una cantidad de valor real que es observable tomando su módulo cuadrado (la densidad de onda):

. Que representa la amplitud del aspecto de onda del sistema en la ubicación x (dada por tres coordenadas espaciales) en el tiempo t. Esta función de onda, debe ser un número complejo para representar los efectos de interferencia, generalmente asociados con los fenómenos de onda, y por lo tanto, no es en sí misma una cantidad observable. Pero se puede construir una cantidad de valor real que es observable tomando su módulo cuadrado (la densidad de onda):

![]()

Este es el cuadrado complejo que implica la multiplicación del número complejo por su complejo conjugado:

![]()

Si desea estimar la probabilidad de encontrar una partícula en alguna ubicación particular x en el momento t:

![]()

es este, el módulo cuadrado que necesita invocar. Si hacemos la identificación:

![]()

Entonces, si todos los resultados posibles para la ubicación se integran juntos, ya que las probabilidades siempre deben sumar 1, tenemos:

![]()

Para la mecánica cuántica, necesitamos una ecuación para el comportamiento de esta función de onda que se escribe con la ecuación de Schrödinger. El espacio de estado en en el que se presentan las distintas ![]() se conoce como espacio Hilbert, una especie de espacio vectorial en el que los estados están representados por “rayos” (básicamente, vectores sin cierta redundancia). Esto tiene las propiedades apropiadas para representar las características de ondas observadas en los sistemas cuánticos.

se conoce como espacio Hilbert, una especie de espacio vectorial en el que los estados están representados por “rayos” (básicamente, vectores sin cierta redundancia). Esto tiene las propiedades apropiadas para representar las características de ondas observadas en los sistemas cuánticos.

2.1 El poder predictivo

¿Cuál es el núcleo de lo que hacemos en las ciencias naturales? Argumentamos que estamos buscando la naturaleza de la realidad. Pero ¿qué significa eso? ¡No podremos encontrar una repuesta lista por parte de los científicos! Prefieren problemas que surgen en la investigación, asumen que hay algo objetivo llamado realidad; independientemente de nuestros intentos de investigar cuál podría ser esta realidad.

Mirando al océano a través de un cuadro de vidrio, por dentro se encuentra el corazón de agua dulce. Allí sobre las profundas realidades se espera que la curiosidad racional haga su arte lógico…

¿Qué es el significado de la realidad? Es fácil decir que es lo que experimentamos cuando despertamos. Pero, tal vez todavía estamos soñando, o tal vez, como dijo el filósofo Gilbert Harman, “un cirujano cerebral juguetón podría estar dándonos estas experiencias estimulando nuestra corteza de una manera especial[1]”. El pensamiento es juguetón, pero la lección es seria: los científicos naturales no pueden probar que están descubriendo la naturaleza de la realidad objetiva. El argumento que presentamos, es que los científicos están en condiciones de hacer un caso persuasivo sobre lo que sienten que han aprendido sobre un postulado: la realidad. No es común escuchar que la realidad es hecha por los científicos; prefieren continuar con la investigación fundamentada por preceptos que aprendieron de otros y por lo que encuentran que funciona para ellos. Esta falta de atención ha ayudado a los malentendidos. Los científicos señalan el poder demostrativo de las teorías que ponen en orden grandes rasgos de fenómenos, y predicen con éxito muchos más, hasta los electrones dentro de un teléfono inteligente. Pero los filósofos y sociólogos pueden señalar que la mejor de nuestras teorías es incompleta y se basa en evidencia que está limitada por inevitables incertidumbres de medición. Entonces, ¿cómo pueden los científicos afirmar que están descubriendo verdades absolutas? Cuando los científicos hacen tales afirmaciones, no deberían, no pueden, realmente decirlo en serio. El argumento, en cambio, es que el poder predictivo de la ciencia, demostrado por la tecnología que nos rodea, es lo que uno esperaría si la realidad física objetiva operara por reglas, y si estuviéramos descubriendo aproximaciones útiles a estas reglas (ecuaciones estructurales).

Deberíamos hacer una pausa para una consideración un poco más cercana del pensamiento sobre el poder predictivo de las teorías. Supongamos que una teoría está diseñada para adaptarse a un conjunto dado de observaciones. Si la teoría es buena aproximación a lo que asumimos es la realidad subyacente a las observaciones, entonces esperamos diferentes predicciones con éxito de los resultados de las observaciones de las nuevas situaciones. Cuanto mayor se la variedad de predicciones exitosas, es decir, cuanto mayor sea el poder predictivo, mejor será el caso de que la teoría sea una buena aproximación a la realidad. No puede ser sin embargo una prueba de que son simétricas a lo real; los científicos nunca podrán afirmar que el poder predictivo de sus teorías demuestra que son representantes exactas de la realidad. Solo podemos afirmar que el impresionante éxito de la ciencia física, el amplio poder predictivo de sus teorías, hace en este caso, que nuestra ciencia sea una buena aproximación a la realidad, esto es difícil de negar.

2.1.2 Teorías

Se puede desde luego decir, que estas predicciones exitosas son fáciles de ignorar; solo lo haces y ya. Pero si lo hacemos, los instó a que hagamos una pausa para considerar la tecnología que ves operar a tu alrededor. Los científicos e ingenieros pueden hacer que los electrones cumplan sus órdenes en su teléfono celular, mediante la operación de campos eléctricos y magnéticos que manipulan electrones y cristales sólidos. ¿Parece esto la aplicación de un mito peculiar de nuestra cultura? Digamos que los vastos ejemplos de tecnología de este tipo que se ven en funcionamiento a su alrededor, defienden la física libre de prejuicios, resultan muy difíciles de ignorar.

Si se acepta que los resultados de las ciencias naturales son aproximaciones útiles a hechos objetivos, entonces, ¿son nuestras teorías físicas simplemente formas de recordar estos hechos? La posición adoptada en las ciencias naturales es que el poder predictivo de las teorías bien establecidas demuestra que son más que eso; son aproximaciones útiles a la forma en que opera la realidad.

Pensar los límites en el poder y las limitaciones de las ciencias naturales; en los hechos empíricos, en su unificación y predicciones teóricas, no es nuevo. Hace un siglo Charles Sanders Peirce enfatizó el impresionante poder predictivo de las teorías físicas de la época, lo que hora llamamos las teorías clásicas del electromagnetismo, la mecánicas y la gravedad. Pero hubo expresión de duda. Ernst Mach prefería llamar a la teoría como un medio para recordar los hechos. Pero el filosofo Schiller fue más allá, preguntándose si estos hechos son solo construcciones de lo que existe o si son en realidad parte del conjunto de todo lo posible que permiten las leyes de la naturaleza. Gracias a ello el poder predictivo de las teorías modernas es aún mayor ahora, pero algunas cosas no han cambiado; todavía escuchamos el desprecio por pensar la teoría. Esto se debe en parte, a que los científicos no suelen reconocer que trabajan con piezas de teoría, que le deben más que a la evidencia empírica. ¿Cómo se hace teoría y qué significan sus resultados? Hace un siglo, Albert Einstein estaba pensando en la naturaleza de una teoría satisfactoria de la gravedad, y eso lo llevó a preguntarse cómo se podría organizar un universo filosóficamente sensible.

Los seguidores de la ciencia están plenamente convencidos de que los procesos de investigación, si se llevan lo suficientemente lejos, darán una solución a cada pregunta a la que la aplican. Alguien puede investigar la velocidad de la luz desde los tránsitos de Venus y la aberración de estrellas; otros desde los movimientos de las curvas de Lissajoux…, pueden seguir diferentes métodos de comparación de medidas eléctricas, gravitacionales, ópticas. Tener resultados diferentes. Así diferentes mentes pueden partir con puntos de vista distintos, pero el progreso de la investigación los lleva por una fuerza a valorar el conocimiento, por prometer un destino en la búsqueda de la realidad.

Ninguna modificación del punto de vista tomado como hipótesis de lo real, ninguna selección de otros hechos para el estudio, ni siquiera la inclinación natural de la mente, puede permitir a un hombre escapar de la creencia predestinada. Esta gran ley está encarnada en la concepción de la verdad y la realidad. La opinión que está destinada a ser finamente aceptada por todos los que investigan, es lo que queremos decir con la verdad, y el objeto representado en esta verdad es lo real. Esa es la forma en que explicaría la realidad, una suerte de independencia lingüística. Peirce lo manifestó así, como “destino”, simplemente se hará realidad por investigación sucesiva y de ninguna manera se puede evitar. Así como: todos estamos destinados a morir.

Vemos el respaldo pragmático de Peirce a la idea de hechos objetivos. Está en línea con la experiencia común, por ejemplo: golpea una copa de vidrio y se romperá. La idea de los hechos se toma en serio, aunque generalmente en la práctica normal de las ciencias naturales también suele estar implícita, aunque Peirce lo hace explícito, es la afirmación o, mejor, el postulado de que hay “verdad y realidad” que sería finalmente acordada por todos los que investigan con un modo de esperanza. La única suposición sobre la que puede actuar racionalmente es la esperanza del éxito (Eureka)… siempre una hipótesis no contradicha por los hechos y sus justificaciones, por su indispensable coherencia racional sobre cualquier acción. Esta es una buena manera de caracterizar el estudio pragmático de las ciencias físicas: la búsqueda de la realidad. Asumimos que la realidad opera por reglas (ecuaciones fundamentales de leyes) para que podamos esperar descubrirlas. Ha funcionado bien hasta ahora. Peirce señala que los valores de la velocidad de la luz derivados de métodos de observación diferentes, y utilizando diferentes teorías para la reducción de los datos de las observaciones, concuerdan dentro de una tolerancia razonable para las incertidumbres de medición. Es decir, dado el resultado de un método, podría predecir con éxito cuáles serían los resultados de los otros métodos. Esta demostración de predicciones exitosas está en el centro del significado de los resultados de la investigación en las ciencias físicas, tan importante que deberíamos tomarnos el tiempo para revisar los experimentos y observaciones que Peirce tenía en mente.

Cálculos de la velocidad de la luz

En el tránsito de Venus se observa como un pequeño punto negro que se mueve a través del Sol a lo largo de un acorde de la cara del Sol. Los observadores en diferentes latitudes de la Tierra ven el tránsito en acordes de diferentes longitudes, lo que significa que encuentran diferentes momentos de tránsito cuando Venus entre y luego sale de la cara del Sol. Los topógrafos tenían mediciones del radio de la Tierra, por lo que se conocían las distancias entre los observadores en diferentes latitudes. La teoría de Newton de los movimientos de los planetas dio la relación de distancias a Venus y el sol. Con estos datos, la trigonometría da la distancia Tierra-Sol y la velocidad de la tierra alrededor del Sol. El primero se conoce en la jerga como el paralaje solar: el tamaño angular de la tierra al sol. Este último se comprueba por el tiempo que tarda la Tierra en completar una órbita alrededor del Sol, un año, dado el paralaje solar. Finalmente, el tiempo de paso de Venus a través de la cara del Sol da la velocidad de la Tierra en relación con el Sol. La velocidad de la Tierra en relación con la velocidad de la luz da el ángulo, o aberración, por la cual los posiciones aparentes de las estrellas se mueven a medida que la Tierra oscila alrededor del Sol. El movimiento a velocidad “v” perpendicular a la dirección de la estrella hace que su posición angular cambie en la dirección del movimiento por radianes v/c, donde c es la velocidad de la luz. Dado que se midió nuestra velocidad alrededor del Sol, esta relación dio una medida de la velocidad de la luz.

Peirce mencionó una segunda medida del paralaje solar, derivada de observaciones cuando Marte, la Tierra y el Sol están casi en una línea y Marte está en el lado opuesto de la Tierra del Sol. Se dice que Marte está en oposición al Sol. Dado que Marte está más cerca de nosotros entonces, este es un buen momento para medir la distancia a Marte midiendo las posiciones angulares de Marte en relación con estrellas distantes de diferentes lugares de la Tierra, o desde un lugar por la mañana y por la noche cuando Marte y las estrellas cercanas a él en el cielo son solo visibles. Por otra parte, la trigonometría con el radio de la Tierra traduce esos ángulos a la distancia Marte-Tierra. La física newtoniana da proporciones de distancias en el sistema solar, por lo que la distancia Marte-Tierra da otra medida del paralaje solar, y a partir de esa aberración da la velocidad de la luz. La consistencia de las mediciones de la velocidad de la luz a partir de observaciones de tránsito de Venus y oposiciones de Marte comprueban que la física de la gravedad newtoniana tiene las proporciones de distancias de los planetas aproximadamente correctas, y comprueba la posibilidad siempre presente de errores sistemáticos en estas mediciones sutiles.

Peirce también mencionó observaciones de los eclipses de los satélites de Júpiter a medida que pasan detrás de Júpiter. El momento de los eclipses observado de las lunas depende de la distancia Júpiter-Tierra, debido al tiempo de viaje de la luz. Dado el paralaje solar y la física newtoniana para obtener la distancia Júpiter-Tierra, la diferencia de tiempo de los pasajes lunares a medida que Júpiter se acerca y se aleja de la Tierra produce la velocidad de la luz.

Las mediciones de laboratorio de Fizeau, Foucault y Lissajoux también encontraron el tiempo que tarda la luz en viajar una distancia conocida, pero en experimentos en la Tierra. La idea es la misma que para el tiempo de las órbitas de los satélites de Júpiter, pero las distancias son tan diferentes que referimos esto como un enfoque independiente.

Peirce mencionó “electricidad estática y dinámica”. Las teorías del campo eléctrico de una distribución estática de cargas eléctricas, y el campo magnético de una corriente constante de carga eléctrica, son similares aparte de un factor multiplicativo. Se sabía que ese factor era consistente con la velocidad de la luz. James Maxwell descubrió que su teoría predice que las ondas electromagnéticas se propagan a esta velocidad de la luz. Mientras Peirce escribía sobre las ondas electromagnéticas, los experimentos del Físico Heinrich Hertz confirmaban la existencia de estas ondas. Peirce se refería a algo o a todo esto. Peirce agregó más tarde que: todos los astrónomos, por ejemplo, estarán de acuerdo en que la Tierra está a noventa y dos o noventa y tres millones de millas del Sol. Y, sin embargo, uno basaría su conclusión en observaciones del paso de Venus a través del disco del Sol; otro sobre observaciones del planeta Marte; otro sobre experimentos sobre la luz combinados con observaciones de los satélites de Júpiter.

Vemos aquí y en las citas anteriores de Peirce dos puntos que son de suma importancia para comprender la naturaleza de la investigación en ciencias físicas.

En primer lugar, Peirce afirmó que las mediciones repetidas realizadas en condiciones repetibles, aunque puedan ser realizadas por diferentes personas, producen el mismo resultado. Esto parece obvio, es nuestra experiencia común, pero no se nos ha emitido una garantía, por lo que la evidencia de repetibilidad de la experiencia es esencial. Existe la complicación para los científicos experimentales y observacionales con sus resultados, están condicionados a preocuparse por errores sistemáticos en mediciones sutiles. Prestamos mucha atención a lo que sucede, en términos de Peirce, “a medida que cada uno perfecciona su método y sus procesos”. Peirce confío en que “se encuentra que los resultados se mueven constantemente justos”. Tal vez tenia en mente la reducción de la contaminación de datos mediante la supresión de errores sistemáticos que siempre están presentes pero que en algunos casos se pueden hacer realmente pequeños. Quizás también tenía en mente que el resultado es independiente de quién hizo la medición, dentro de la incertidumbre. Ambos son lo que se esperaría bajo el supuesto de que la realidad opera de manera legal (bajo leyes) y regular (coherencia lógica).

El segundo punto que Peirce formulaba es que las mediciones obtenidas por diferentes tipos de observaciones, y reducidas por la aplicación de diferentes teorías, pueden producir resultados consistentes. Peirce mencionó cuatro formas de medir la velocidad de la luz: 1) Tránsito de Venus y oposiciones de Marte; 2) retrasos de tiempo en las órbitas de las lunas de Júpiter; 3) mediciones de laboratorio de los tiempos de viaje de la luz, el mismo efecto que para las lunas de Júpiter, pero en escalas de longitud tan diferentes que cuentan como situaciones independientes; y 4) experimentos de laboratorio con campos eléctricos y magnéticos. Si tuviéramos solo una de estas mediciones, entonces podríamos decir que la velocidad de la luz no necesita ser más que un artificio, diseñado para hacer una historia que se ajuste a la evidencia. Pero la velocidad de la luz determinada por uno de estos métodos predice con éxito los resultados de cada uno de los otros tres. Peirce también señaló que el paralaje solar derivado de uno de estos métodos predice con éxito el paralaje solar obtenido por un segundo. Esta es una impresionante variedad de predicciones exitosas, basadas en aplicaciones de diferentes teorías físicas a diferentes tipos de observaciones. La consistencia de los resultados, dentro de las incertidumbres de medición, apoya el caso de que la velocidad de la luz y el paralaje solar son conceptos físicos significativos. Esto es lo que se esperaría si nuestras teorías físicas fueran útiles trabajando aproximadamente al comportamiento de una realidad objetiva que opera por leyes que estamos descubriendo. Peirce lo expreso así:

Tal es el método de la ciencia. Su hipótesis fundamental, dada en un lenguaje más familiar, es la siguiente: hay cosas reales, cuyos personajes son totalmente independientes de nuestras opiniones sobre ellas. La experiencia del método no nos ha llevado a dudarlo, sino que, por el contrario, la investigación científica ha tenido los triunfos más maravillosos en la forma de asentar opiniones.

Nos otros sentimos lo mismo. Gerald Holton dio el mismo argumento un siglo después de Peirce, en “Orígenes temáticos del pensamiento científico[2]”:

El significado detrás de la afirmación de que “creemos en la realidad” de los electrones es que el concepto es actualmente necesario tan a menudo y de muchas maneras, no solo para explicar los rayos catódicos, el fenómeno que conduce a la formulación original del concepto, sino también para una comprensión de los fenómenos termoiónicos y fotoeléctricos, las corrientes en sólidos y líquidos, radiactividad, emisión de luz, enlace químico…

El Progreso de la ciencia permitió esta gama aún más amplia de predicciones exitosas, ¿podría haber otra teoría que encajara igualmente bien con estas observaciones, tal vez cuando se considera en el contexto de alguna otra cultura? No se puede refutar, dado que no es el lenguaje con lo que se está jugando, sino con lo real.

Herbert Dingle declaró que “la naturaleza parece ser inteligente[3]”.

La consistencia de diversas mediciones y observaciones en los ejemplos que dieron Peirce y Holton es lo que uno esperaría podemos descubrir si la realidad física objetiva operada por reglas, y si las teorías empleadas en la interpretación de estas mediciones fueran aproximadas lo suficientemente a estas reglas para predicciones exitosas de nuevos fenómenos.

Chauncey Wright[4]:

Para cualquiera que sea el origen de las teorías de la ciencia, ya sea de un examen sistemático de los sesgos empíricos por inducción consciente, o de los sesgos naturales de la mente, las llamadas intuiciones de la razón, lo que parece probable sin un estudio distinto de nuestras experiencias, cualquiera que sea el origen, real o ideal, el valor de estas teorías solo puede ser probado… por deducciones de las mismas consecuencias que podemos confirmar por el indudable testimonio de los sentidos.

Este comentario sobre la importancia de lo que Wright denominó “verificación” en las ciencias naturales concuerdan con el pensamiento reciente; basta con añadir que el “testimonio de los sentidos” se recibe ahora de detectores electrónicos bastante sofisticados. Pero no hemos encontrado evidencia de que Wright reconociera el punto más profundo de Peirce, la importancia del impresionante poder predictivo de las teorías físicas del electromagnetismo, la mecánica newtoniana y la gravitación.

William James, estrecho colaborador de Peirce durante años, ofreció una opinión diferente de la ciencia física. James escribió que:

A medida que las ciencias se han desarrollado más, la noción ha ganado terreno de que la mayoría, tal vez todas, nuestras leyes son solo aproximaciones. Las leyes mismas, además, han crecido tanto que no hay que contarlas; y se proponen tantas formulaciones rivales en todas las ramas de la ciencia que los investigadores se han acostumbrado a la noción de que ninguna teoría es absolutamente una transcripción de la realidad, sino que cualquiera de ellas puede ser útil desde algún punto de vista. Su gran uso es resumir viejos hechos y conducir a otros nuevos. Son solo un lenguaje hecho por el hombre, una taquigrafía conceptual, como alguien las llama, en la que escribimos nuestros informes de la naturaleza; y las lenguas, como es bien sabido, toleran muchas variedades de expresión y muchos dialectos. Tal es la gran forma suelta en que el pragmatismo interpreta la palabra acuerdo. Lo trata por completo de manera práctica. Permite que cubra cualquier proceso de conducción desde una idea presente hasta un término futuro, siempre que solo se ejecute prósperamente. Solo así se puede decir que las ideas “científicas”, que vuelan más allá del sentido común, están de acuerdo con sus realidades. Es, como ya se ha dicho, como si la realidad se hiciera de electrones, átomos, moléculas, pero no debemos pensarlo literalmente. El término “energía” ni siquiera pretende representar algo “objetivo”. Es solo una forma de medir la superficie de los fenómenos para encadenar sus cambios en una fórmula simple. Clerk Maxwell en algún lugar dice que sería “de mal gusto científico” elegir la más complicada de dos concepciones igualmente bien evidenciadas; y todos estarán de acuerdo con él. La verdad en la ciencia es lo que nos da la máxima suma de satisfacciones, el gusto incluido, pero la coherencia tanto con la verdad previa como con los hechos novedosos es siempre el reclamo más imperioso.

Tal vez la última frase en esta cita, y anteriormente en el comentario de James de que el “gran uso de las teorías es resumir hechos antiguos y conducir a otros nuevos”, es un reconocimiento del punto de Peirce de que las pruebas de predicción pueden hacer un caso persuasivo para una teoría física. El resto de este comentario no alienta la idea, sin embargo, y tampoco el comentario de James que:

Lo verdadero, para decirlo muy brevemente, es solo lo conveniente en el camino de nuestro pensamiento, así como lo correcto es solo lo conveniente en la forma de nuestro comportamiento.

La objeción de Peirce, del término “pragmatismo” para caracterizar esta lectura de “conveniente” de la ciencia física. El pragmatismo de Peirce significa la búsqueda de aproximaciones útiles a la forma en que son las cosas, como en el electromagnetismo y la física newtoniana. En su libro, The principles of psychology, James escribió que[5]:

Todo el sentimiento de la realidad, todo el aguijón y la excitación de nuestra vida voluntaria, depende de nuestra sensación de que ellas, la cosas realmente se están decidiendo de un momento a otro, y que no es el traqueteo aburrido de una cadena que se forjo hace innumerables años. Esta apariencia, que hace que la vida y la historia hormigueen con un entusiasmo tan trágico, puede no ser una ilusión. Así como concedemos al defensor de la teoría mecánica que puede ser uno, así también son dos concepciones de posibilidad cara a cara sin hechos lo suficientemente conocidos como para ser árbitros entre ellos.

La metáfora de una cadena de instrucciones es deliciosa, como lo es la forma de decirlo por Peirce:

La proposición en cuestión es que… dado el estado del universo en la nebulosa original, y dadas las leyes de la mecánica, una mente suficientemente poderosa podría deducir de estos datos la forma precisa de cada letra que estoy escribiendo ahora.

Parece típico que Peirce estuviera dispuesto a decidir entre las ideas del libre albedrío y la teoría mecánica:

Las conclusiones de la ciencia no pretenden ser más que probables, y consideran que una inferencia probable a lo sumo solo puede suponer que algo es más frecuente, o de otra manera aproximadamente, verdadero, pero nunca sea precisamente cierto sin excepción en todo el universo, vemos cuán lejos está otra proposición (la teoría mecánica) en verdad de ser tan postulada.

Debemos tener en cuenta que James estaba más interesado en las formas en que las personas se comportan que en la física básica. Peirce estaba más del lado de la realidad objetiva, para ser abordada en aproximaciones sucesivas, como vemos la comparación de su pensamiento sobre el libre albedrío. A pesar del peligro de sobreinterpretar lo que Peirce podría haber estado pensando, consideramos que el comentario de Peirce es un paso significativo al reconocimiento de que la física clásica en un sistema puede perder la memoria de las condiciones iniciales. Eso seguramente incluiría el recuerdo de cualquier instrucción programada sobre lo que se supone que debo hacer a continuación. El “entusiasmo trágico” de la vida de James sigue siendo un rompecabezas profundo, pero evitamos una mayor discusión al limitar la atención al tema mucho más simple de lo que aprendemos de las pruebas de física básica en situaciones controladas, en la línea de la discusión de Peirce sobre las mediciones de la velocidad de la luz.

El filósofo Ferdinand Canning Scott Schiller[6], estaba aún menos entusiasmado que James sobre la posición de Peirce. Schiller escribió que:

La “independencia” reclamada por la verdad pierde todo sentido cuando se analizan sus ambigüedades. Si “independiente” significa “totalmente no afectado por el lenguaje o la mente” es lógico pensar que la verdad no puede ser independiente de nosotros. Dos cosas estrictamente independientes no podrían coexistir en el mismo universo. Tampoco la verdad puede ser “independiente” en el sentido de “no relacionada con la base axiomática humana”; porque ¿cómo en ese caso podríamos saberlo? La verdad no tiene sentido si no implica una doble reacción, con una persona para quien es verdadera, y un objeto sobre el cual es verdadera. Cualquier “indepencia” que ignore cualquiera de las dos relaciones es imposible; cualquier que sea menor que esto, no es independiente en absoluto.

Esto es lógico, y tenemos un nuevo aspecto de la situación. Cuando observamos un sistema en un estado cuántico puro, podría cambiarlo a otro estado. ¿Cómo afecta eso al vector de estado del universo, si existe tal cosa? Colocamos la pregunta, con el significado del libre albedrío, fuera de los límites de este manuscrito.

La vida, un accidente estadístico cósmico, sentimiento general que estaba en línea con la ideología científica dominante de los siglos XIX y XX, conocida como reduccionismo, que proponía que la realidad podría entenderse mejor desglosando todos los fenómenos físicos en sus partes y procesos más simples, de modo que podamos observar el comportamiento básico de los constituyentes fundamentales de la naturaleza de forma asilada. De acuerdo con el evangelio del reduccionismo, siempre que sea posible, las ciencias sociales y la psicología deben reducirse a la biología, la biología a la química y la química debe reducirse a la física fundamental. Aunque el enfoque reduccionista ha sido tremendamente exitoso, dándonos la mayoría de nuestras mayores teorías físicas, creó la impresión de que todas las formas de vida, incluidos los humanos, no son más que colecciones de átomos que siguen obligadamente trayectorias mecánicas fijas y arbitrarias, determinadas únicamente por las matemáticas y no por la mente.

Como resultado, el enfoque reduccionista de la ciencia ayudó a popularizar la postura filosófica conocida como materialismo, que sostiene que la realidad solo consiste en lo físico. Si bien este punto de vista ayudó a librar aún más a la ciencia de conceptos sobrenaturales como almas y espíritus, el materialismo clásico negó la existencia de cosas aparentemente inmateriales , como la conciencia, la información biológica, e ignoró en gran medida los conceptos de energía e información. Al hacerlo, el materialismo nos redujo a máquinas de carne parecidas a zombis sin agencia, sentimiento, o experiencia interior. Para la mayoría de los materialistas, la vida y la mente se consideran “epifenómenos” si se reconocen en absolutos, lo que esencialmente significa que no importan; simplemente están ahí. Cualquier sentimiento de libre albedrío que podamos tener al tomar una decisión es simplemente una ilusión. No somos los autores de nuestras acciones, sino observadores pasivos que pueden ser engañados constantemente por el cerebro para que creamos que somos causalmente imponentes.

Colectivamente, estos avances intelectuales formaron lo que los filósofos llaman la cosmovisión reduccionista. Este paradigma no estaba satisfecho simplemente con la eliminación de Dios y el Alma de la imagen física, sino que también quería purgar la naturaleza de todo rastro de propósito o progreso.

Con respecto a preguntas existenciales tan importantes como “¿cómo llegamos aquí?” y ¿a dónde vamos?, la cosmovisión reduccionista responde “suerte y probablemente en ninguna parte”. Era supremamente racional adoptar esta cosmovisión, ya que así es como las cosas aparecen por primera vez a aquellos que han abandonado con razón las explicaciones de los fenómenos naturales que invocan lo sobrenatural. Pero el paradigma que está en el horizonte nos lleva a una conclusión muy diferente en que pensamos sobre el universo y nuestro lugar en él. En particular, se demostrará que los fenómenos que llamamos vida, ciencia e inteligencia tienen un profundo significado cósmico.

Estas ideas provienen de considerar los roles que la energía y la información juegan en el surgimiento y crecimiento de la complejidad. Tales consideraciones son el ámbito de una disciplina académica relativamente nueva conocida como ciencia de la complejidad, una unificación de las principales ciencias de nuestro tiempo que incluyen, entre otras, la física, la biología, la neurociencia, al informática, la teoría evolutiva y la estadística. Estas ciencias y sus métodos han sido combinados por investigadores con antecedentes interdisciplinarios para formar un enfoque integrado, igualmente teórico y experimental, destinado a comprender cómo los sistemas dinámicos de la naturaleza emergen y evolucionan con el tiempo. Un sistema dinámico es un término general para cualquier sistema hecho de un conjunto de componentes que interactúan que pueden explorar una variedad de estados estructurales o funcionales, y pueden ser físicos, químicos, biológicos, cognitivos, sociales o tecnológicos. La ciencia de la complejidad estudia los sistemas dinámicos en todas las escalas, desde lo imperceptiblemente pequeño, hasta lo imperceptiblemente grande, incluido el sistema dinámico más grande de todos, el universo mismo.

Los métodos empleados por los científicos de la complejidad, los hijastros de los cibernéticos y los teóricos del caos del siglo XX, logran algo de lo que el enfoque reduccionista es fundamentalmente incapaz: nos permiten comprender cómo los bloques de construcción de la naturaleza se autoensamblan espontáneamente a través de una danza sinérgica que crea fenómenos emergentes maravillosos (subyacentes), como la vida, la mente y la civilización. Resulta que el comportamiento colectivo de las partes que interactúan, no simplemente de cómo funcionan de forma aislada, es la clave para comprender el surgimiento y evolución de todos los fascinantes organismos y ecosistemas que componen la biosfera. Este tipo de sistemas dinámicos son especialmente eficaces en su capacidad de adaptarse a un entorno cambiante, y se han denominado adecuadamente sistemas adaptativos complejos. En general, podemos pensar en la vida como una forma de complejidad adaptativa, para distinguirla de las formas no adaptativas de complejidad, como el orden que vemos en estructuras como cristales y copos de nieve, que es fijo y no funcional. La complejidad adaptativa es un término flexible que nos permite hablar de toda la biosfera como una red integrada e interconectada de sistemas adaptativos complejos.

La complejidad adaptativa a menudo se ha descrito como existente en el límite entre el orden y el caos, el “borde del caos” que se le ha llamado, y es en esta coyuntura donde la estructura y la aleatoriedad conspiran para crear sistemas que sean óptimamente resistentes, flexibles e innovadores. Debido a la naturaleza intrincada enrevesada de los sistemas adaptativos complejos, desde las células hasta las comunidades su dinámica no pudo ser comprendida adecuadamente hasta que el modelado computacional alcanzó un cierto nivel de sofisticación. Reconociendo este hecho, el físico Stephen Hawking declaró que el siglo XXI sería “el siglo de la complejidad”.

A partir de una comprensión más profunda de cómo surge la complejidad en la naturaleza, se está revelando una nueva narrativa cósmica que cambiará la compresión de nuestros orígenes y nuestro futuro. Lo llamamos nueva, pero los paradigmas no surgen de la noche a la mañana. A menudo se propagan gradualmente al principio, impregnando lentamente hasta que se alcanza un punto de inflexión, lo que desencadena un repentino aumento de la prominencia. Bueno, ese punto de inflexión está a la vuelta de la esquina. Si bien este nuevo “paradigma general” probablemente sorprendería a la mayoría de las personas, puede parecer no lógico, sino obvio, para aquellas mentes curiosas que han tratado de imaginar el futuro implícito por la tasa exponencial de progreso tecnológico. Ya sea que el paradigma del que hablamos confirme intuiciones, nos sorprenda o desencadene una reacción escéptica, es probable que nos emocione, porque en un sentido fuerte, se trata de lo que somos nosotros mismos.

La suposición de que nuestro mundo está derivado gradualmente hacia un estado más desordenado, aleatorio y sin vida es completamente errónea y el resultado de un malentendido fundamental de la segunda ley de la termodinámica. Si es correcto pensar en el cosmos como una máquina computacional masiva, no es una que se esté acabando. En términos de complejidad adaptativa, parece estar apenas comenzando. A través de una serie de emergencias jerárquicas, una secuencia anidada de partes que se unen para formar un todo cada vez con más partes, el universo está experimentando un gran y majestuoso proceso de autoorganización de procesos, y en este momento en el tiempo, en este rincón del universo, somos las estrellas del espectáculo.

A medida que avanza la evolución cósmica, el mundo se está volviendo cada vez más organizado, cada vez más funcional y, debido a que la vida y la conciencia emergen de suficiente complejidad e integración de la información, cada vez más sensible. A través de la evolución y eventual expansión externa de seres conscientes de sí mismos como nosotros, y sus esfuerzos por organizar la materia en arreglos que apoyen el procesamiento de la información y la computación, el universo está, en un sentido muy real y literal, despertando. No es despertar independientemente de nosotros, como en un sentido psíquico, sino a través de nosotros, ya que toda la materia que compone la vida fue una vez inanimada. Como dijo el cosmólogo y educador Carl Sagan: “somos una forma para que el cosmos se conozca a sí mismo”. En lugar de descartarlo como una mera metáfora poética, lo tomamos en serio y dentro de la evolución cósmicas. Al hacerlo, vemos que la complejidad adaptativa ha iniciado un proceso de despertar cósmico que apenas comienza. Dónde termina está por determinarse. Exactamente cómo va la historia curiosamente parece depender crucialmente de las acciones de la vida inteligente. De hecho, podría depender de alguna manera significativa de usted y de nosotros colectivamente.

Si bien las leyes y constantes de la física parecen haber forjado esta trayectoria evolutiva para la vida en el universo, descrita como un destino cósmico, determinado no en detalle en un esquema aproximado, la dura verdad es que el éxito existencial no está garantizado de ninguna manera para el Homo sapiens. No hay ninguna ley particular o fuerza de la naturaleza que impida que nuestra civilización falle. El progreso ocurre no porque esté siendo impulsado por alguna fuerza mística, sino porque la vida aprende del fracaso continuo. La selección natural es el algoritmo de la naturaleza para la corrección de errores. Si somos sabios, podríamos ser los errores que se corrijan. En ese caso, la próxima civilización o especie tendrá su oportunidad, y si no repiten nuestros errores, avanzarán más allá de donde estábamos en el apogeo de nuestra gloria. La hipótesis es que el conocimiento en la biosfera se acumulará en cualquiera de los dos escenarios.

Pero no tenemos que fallar. El hecho de que los humanos sean realmente, como argumentará este libro, agentes autónomos con libre albedrío, formalizado como poder causal, significa que depende de nosotros decidir entre la extinción y la trascendencia. Tenemos todos los incentivos para trabajar hacia lo segundo y alejarnos de lo primero. A través de los esfuerzos colectivos de la humanidad, a través de nuestro progreso intelectual, cultural y tecnológico, podemos continuar ayudando al cosmos en su gran proceso de despertar. Promover una conciencia de nuestro propósito cósmico emergente podría facilitar el progreso social, económico y tecnológico exponencial, permitiéndonos trascender nuestras limitaciones intrínsecas y que la biosfera se extienda hacia afuera, hacia los cielos en las estrellas.

Poe supuesto, la nueva narrativa cósmica no debe ser tomada por fe. Cualquier afirmación tan magnifica debe, por regla general, ser recibida con profundo escepticismo. Un cambio de paradigma de esta magnitud requiere una explicación física satisfactoria de la evidencia que apoya una desviación tan radical del consenso científico general. Pero ese relato existe, y las páginas venideras en la ciencia, la ingeniería y al filosofía describirán las nuevas y emocionantes teorías de la información biológica, hallazgos experimentales y procesos físicos que corroboran estas notables afirmaciones.

Las principales emergencias en la autoorganización del universo se explican mecánicamente, para que podamos ver precisamente cómo y por qué la complejidad adaptativa y el conocimiento que encarna crece inevitablemente y sin límites, como consecuencia de las leyes de la física y las dinámicas evolutivas que emergen de las restricciones que imponen a la materia en movimiento. En nuestra búsqueda para comprender la evolución cósmica, llegaremos a un “teoría del todo” que podamos llamar teoría unificadora de la realidad. Esta ambiciosa teoría intenta resolver los mayores misterios de la ciencia. El infame “duro problema de la conciencia”, el rompecabezas del libre albedrío y el misterio de la creciente complejidad cósmica en un universo cada vez más entrepiso comienza a desmoronarse a medida que la teoría unificadora disuelva las paradojas creadas por las suposiciones injustificadas de la cosmovisión reduccionista y exponer las trampas del lenguaje que nos han impedido hacer progreso intelectual durante tanto tiempo. Al introducir una nueva síntesis evolutiva, la síntesis evolutiva integrada, la teoría unificadora de la realidad cierra la brecha entre lo cuántico y lo cosmológico con principios de la biología evolutiva.

2.1.3 La última frontera teórica de la biología

El origen de la vida es un asunto altamente probable. Tan pronto como las condiciones lo permitan, ¡aparece! Carl Sagan

A pesar que “información” es un concepto aceptado en muchas áreas de la investigación, en la ingeniería, la química, la física y hasta la biología y las ciencias sociales. Y sin embargo, su estatus como entidad física sigue oscuro. Tradicionalmente es considerado el concepto de información como un derivativo secundario. Debido a que los bits de información siempre se modelan en instancias de grados de libertad, las propiedades podrían, al parecer, reducirse siempre a las del sustrato material. Sin embargo, durante décadas ha habido intentos de invertir esta interdependencia y arraigarla en la información en lugar de la materia. Esta perspectiva contraria se asocia con el nombre de John Archibald Wheeler, quien encapsuló su propuesta en el escueto dictum: ¿bit[7]?

En un sentido práctico y cotidiano, la información a menudo se trata como una “cosa por derecho propio” con una medida de autonomía; de hecho, se compra y se vende como una mercancía junto con la gasolina y el hierro. En la ciencias biológicas, los discursos informativos son indispensables: los biólogos hablan sobre códigos genéticos, sobre traducción y transcripción, sobre señales químicas y procesamiento de datos sensoriales, todos los cuales tratan la información como moneda de actividad, el “aceite” que hace girar las “ruedas biológicas”. Los florecientes campos de la secuenciación genómica y metagenómica y la bioinformática se basan en la noción de que los bits informativos son literalmente vitales. Pero debajo de esta precariedad familiar se esconde una cruda paradoja. Si la información hace una diferencia en el mundo físico, lo que seguramente hace en organizar la energía en estructuras, entonces ¿no deberíamos atribuirle poderes causales?

Sin embargo, en la física la causalidad se entiende invariablemente a nivel de las interacciones de partículas y campos, no en el ámbito de los bits abstractos o qubits, sus contrapartes cuánticos. ¿Podemos tener ambos? ¿Pueden coexistir dos cadenas causales de manera compatible? ¿Son las narrativas gemelas de causalidad material y causalidad informativa compañeras de cama cómodas? Si es así, ¿cuáles son las leyes y principios que rigen la dinámica de la información para colocarse junto con las leyes de la dinámica material? Si no es así, y la información es simplemente un epifenómeno que navega sobre los grados físicos subyacentes de libertad, ¿podemos determinar bajo qué circunstancia imitará a la agencia autónoma?

¿Qué es información?

¿Es un mero epifenómeno o tiene sentido causal?

¿Cómo se relaciona con la causalidad arriba-abajo?

¿De dónde viene?

¿Se conserva y, de ser así, cuándo?

¿Cómo y cuándo asume una vida propia y se convierte en una cosa por derecho propio?

¿Existen leyes de la dinámica de la información análogas a las leyes de la dinámica material?

¿Son las mismas leyes? ¿O puede la información trascender las leyes de la mecánica? ¿Cómo se relaciona la información sobre la mesoescala y macroescala(si lo hace)?

¿La perdida de información es siempre lo mismo que la entropía?

2.1.4 Filosofía científica de la biología

Es común que se nos presenten como combinación de azar y necesidad, combinando accidentes estáticos y convergentes evolutivos similares a una ley. Como resultado del punto de vista antropocéntrico, tanto la astrobiología como comprensión de posibilidades de vida; con solo una muestra de vida a nuestra disposición, es difícil separar que características son meramente accidentales o incidentales, de las “similares a leyes” que esperamos que sean comunes a la toda la vida en el universo.

Las discusiones sobre las características universales de la vida generalmente se centran en la química. Ahora mismo se va más allá de este énfasis. Se reconoce en la vida, no solo nivel subyacente (químico), sino que se caracteriza por una organización jerárquica, que va desde el nivel de las células hasta los organismos multicelulares y la sociedades y lingüística[8]. Esto podría aplicarse a múltiples niveles de la biosfera, desde células hasta sociedades y sus formas de aprendizaje, o describir la vida sintética con químicas radicalmente diferentes. Aunque muchos trabajos han tenido como propósito unificar los niveles en jerarquías biológicas, el concepto de información, es una idea prometedora para descubrir principios universales de la biología actualmente ocultos a cualquier escala de complejidad[9], identificando principios que podrían extrapolarse a la vida en todas sus posibilidades. Definir “información biológica”, es un tema abierto de intenso debate por derecho propio[10], queremos enfatizar que para la computación biológica no es un atributo pasivo la información en los sistemas biológicos, sino que desempeña un papel activo en la ejecución de la función biologica[11]. El problema duro de la vida, es la identificación del mecanismo físico real que permite que la información obtenga un efecto causal sobre la materia. Este punto no es cómodo para los actuales enfoques de la física, pero es un camino prometedor para contestar de mejor forma ¿qué es la vida?

El surgimiento de la vida y la mente a partir de sistemas químicos no vivos sigue siendo uno de los grandes problemas pendientes de la ciencia. Cualesquiera que sean los detalles específicos de este camino, podemos estar de acuerdo que representar una transición de lo simple a lo extraordinariamente complejo, el problema, es que el grado “de ajuste fino” necesario para especificar el estado inicial es insatisfactorio y lo es cada vez más cuanto más complejo se vuelve el universo. Pero, hay intentos serios, como la teoría constructora, que tiene como objetivo eliminar las condiciones iniciales de nuestras explicaciones del mundo[12]. Resolver el problema de ajuste fino es esencial para explicar la vida, ya que las estructuras más complejas que conocemos, son las menos explicables a partir de un estado inicial arbitrario, son precisamente las de interés en la discusión contemporánea de los sistemas físicos vivos, tecnológicos artificiales y conscientes.

La inferencia científica generalmente se basa en establecer la causalidad. Este es también el caso de la biología, una disciplina encargada de proporcionar relatos históricos de las propiedades de los seres vivos, así como un modelado de procesos productivos que involucran mecanismos como origen de esas propiedades. Como es de esperar esto apunta una diversidad de temáticas, sin embargo, existe un amplio acuerdo de una explicación de por qué los organismos tienen características particulares, comúnmente implicará un tipo particular de proceso evolutivo, a saber, la evolución por selección natural.

Como toda ciencia líder de su tiempo, el progreso de la biología depende de la interrelación entre la investigación empírica, la construcción de teoría, el modelado y el contexto social. Si bien la biología molecular y experimental han evolucionado dentro de una avalancha de datos altamente detallados dentro del contexto de los sistemas biológicos, la integración de estos resultados en marcos teóricos útiles se ha quedado rezagado. Se impulsa en gran medida por consideraciones técnicas que involucran herramientas estadísticas, y la biología sigue estando menos guiada por la teoría de lo que parece. Es necesaria la formulación de nuevos enfoques de formación de científicos que hagan suyos conceptos teóricos en las biociencias, para intentar responder preguntas de fondo que están abiertas en la biología: cómo el origen y la organización de la forma del organismo, la relación entre el desarrollo y la evolución, y las bases biológicas de la cognición y la mente; las teorías de información como factor de causalidad…