Pensamiento Filosófico y Humanidades I: El ejercicio de filosofar y la perspectiva humanista

Unidad Cuatro: Teoría del conocimiento: percepción, verdad, razón y posverdad. Interpretación

4.0 Crisis: una pérdida de confianza en el valor de la verdad

Hay un creciente escepticismo sobre si creer en proposiciones verdaderas —aquellas que concuerdan con la realidad, y no simplemente halagan nuestras preferencias partidistas— sigue teniendo importancia en la política. Los signos de esta crisis de la creencia son cada vez más evidentes.

Incluye, por un lado, la disposición de los políticos a repetir falsedades evidentes sin temor a corrección; y por otro, una disposición equivalente del público no solo a tolerarlas, sino a creerlas —o al menos a respaldarlas— a pesar de su falsedad manifiesta. Muchos repiten estas mentiras en línea y fuera de línea, marchando en solidaridad verbal con sus compañeros de partido, en abierta contradicción con los hechos.

Sin embargo, al igual que con el asalto a la democracia —cuyos enemigos continúan ondeando triunfalmente su bandera—, aquellos que más vehementemente denigran el valor de la verdad son los mismos que buscan apropiarse de la palabra. La reempaquetan con estilo orwelliano y la venden de nuevo a las masas.

Esta crisis de nuestro tiempo no se limita a ningún país, universidad, empresa, político ni ciclo electoral. Se extiende a lo largo de todas las líneas partidistas. Es una crisis interrelacionada, porque las ideas de verdad y democracia están profundamente conectadas: sin verdad, todas las formas de autoritarismo encuentran terreno fértil.

Para muchos, la política y la verdad ya no se mezclan: son agua y aceite. Nadie ha dudado nunca —señaló una vez Hannah Arendt con su característico filo— “de que la verdad y la política están en bastante malos términos entre sí”. Incluso cabe pensar, como ella misma advirtió, que “la naturaleza de la esfera política está en guerra con la verdad en todas sus formas”. Dondequiera que la política entra en escena, la razón se repliega, o se convierte —como escribió David Hume— en esclava de las pasiones. No deliberamos: racionalizamos. Escuchamos solo lo que queremos oír. Nuestros prejuicios anteceden a nuestros argumentos, y muchas veces pensamos con el instinto antes que con el juicio. Nos decimos a nosotros mismos “yo sé, ellos no”, incluso cuando lo que creemos saber es abiertamente falso.

El cerebro político rara vez es el cerebro racional. Es un cerebro sometido, movido por la necesidad de pertenencia, identidad, reacción. Como resultado, la política ha estado desde siempre en una relación tensa, incluso antagónica, con la verdad. No porque la verdad no importe, sino porque la verdad —cuando es incómoda— exige una valentía que la política raramente recompensa.

Este conflicto es particularmente agudo en el contexto de la política democrática, ya que esta exige deliberación entre ciudadanos libres e iguales. Para algunos, el antagonismo entre verdad y política democrática tiene sus raíces en una forma de injusticia epistemológica incubada desde la educación: una que empobrece la capacidad de los ciudadanos para distinguir entre conocimiento, creencia y propaganda. Esta deformación convierte el concepto mismo de “verdad” en algo ambiguo, casi metafísico, demasiado abstracto —dicen— como para ser útil en los intercambios reales de la deliberación pública.

Además, en muchos casos, la verdad es percibida con connotaciones autoritarias: como si estuviera depositada en una élite —política, técnica o intelectual— que la administra desde una posición de privilegio. Así, afirmar que cierto juicio político es “verdadero” se interpreta, no como una apelación a la razón común, sino como un intento de imponer un punto de vista, de consagrar una forma particular de poder. La verdad, en este marco, deja de ser una orientación compartida para convertirse en un instrumento de dominación simbólica.

Para otros, la política democrática —en su mar de pluralidad de puntos de vista considerados “razonables”— tiende a marginar la verdad referencial, verificada y sustentada en evidencia sólida, tal como la conciben las comunidades epistémicas rigurosas. En nombre de la tolerancia o del respeto a la diversidad de opiniones, se diluye la distinción entre argumentos bien fundamentados y simples afirmaciones sin sustento. Esto ha llevado a algunos a cuestionar si el pluralismo democrático, tal como se practica hoy, no debería incluir también un deber de exclusión epistémica: es decir, la responsabilidad de rechazar afirmaciones manifiestamente falsas, no como un acto de censura, sino como parte de una deliberación crítica, exigente y responsable.

Defender la verdad en la esfera pública no implica imponer una ortodoxia única, sino resistir la pereza intelectual que consiste en tratar todas las opiniones como igualmente válidas, sin evaluación crítica. El pluralismo auténtico exige una conversación abierta, sí, pero también nutrida por un compromiso con el conocimiento, la evidencia y la honestidad intelectual.

Esta situación, aunque preocupante, es comprensible. El concepto de verdad —como todo concepto filosófico fundamental— posee una complejidad que ha sido discutida durante siglos. Y es cierto que, especialmente en el terreno político, saber qué es verdad no siempre es fácil. Las evidencias pueden ser ambiguas, los contextos complejos, y las interpretaciones múltiples. Sin embargo, la idea básica de la verdad —como aquello que concuerda con los hechos, que puede ser justificado racionalmente, que resiste la mera opinión— no es ni incomprensible ni, mucho menos, antidemocrática.

Al contrario: sin algún compromiso compartido con la posibilidad de conocer y defender lo verdadero, la deliberación democrática pierde sentido. Si todas las afirmaciones son tratadas como igualmente válidas, incluso aquellas que carecen por completo de sustento, la política se convierte en un concurso de voluntades, no de razones. En este sentido, el rechazo a la verdad como criterio compartido no es una expresión de pluralismo, sino una forma sutil de nihilismo político.

Crisol de pensadores: perseguir objetivos de creencias verdaderas sobre el mundo. Son los cimientos de la justicia epistémica que la democracia necesita para florecer. Y es por eso que las mayores amenazas al valor de la verdad para las democracias surgen cuando ignoramos la ciencia, denigramos las prácticas de discusión libre de ideas, o cuando los medios de comunicación censuran los espacios destinados a la razón.

En el sentido más básico, las afirmaciones verdaderas son aquellas proposiciones que buscamos cuando hacemos preguntas sinceramente; son proposiciones que concuerdan con la forma en que las cosas son, no como esperamos o creemos que son. Comprender esa idea es aceptar que puede haber proposiciones verdaderas en las que nunca creeremos, y que el hecho de creer no las convierte en verdaderas, sin importar cuán poderoso pueda ser el creyente.

Sin embargo, este es precisamente el concepto amenazado en este momento en muchas sociedades, donde los movimientos autoritarios están alentando a las personas no solo a repetir mentiras escandalosas, sino a valorar menos la creencia verdadera que la lealtad a una ideología, o incluso a una persona o partido político. Desde esta perspectiva autoritaria, si la gente cree sus mentiras, mejor; pero también están de acuerdo con el compromiso más siniestro: que la gente actúe como si las mentiras fueran ciertas.

Esta es una de las razones por las que la popularidad de la política autoritaria —incluso cuando sus practicantes no están en el poder— es una amenaza directa a la democracia. Las democracias requieren que sus ciudadanos le digan la verdad al poder. Decirle la verdad al poder significa decir lo que es verdad, incluso si es incómodo o peligroso. Pero también significa estar comprometido con lo que es verdad, incluidas las verdades que los autoritarios quieren borrar de la historia.

Cuando la verdad deja de valorarse en la política —de derecha o de izquierda—, cuando nos permitimos encogernos de hombros o ignorarla, ambas tareas cruciales se vuelven más difíciles, incluso imposibles. Dejamos de decirle la verdad al poder y, en cambio, le decimos al poder lo que quiere escuchar, solo para asegurarnos de que estamos sometidos a su fuerza autoritaria.

Valorar la verdad en la democracia no significa que todos deban creer las mismas cosas. Eso ni siquiera es posible, y mucho menos democrático. Valorar la verdad significa invertir en aquellas instituciones y prácticas colectivas que nos ayudan a buscar la verdad, adquirir conocimiento en lugar de mentiras, hechos en lugar de propaganda, derechos laborales en lugar de deseos volátiles. El problema de fomentar una organización social más racional es el problema real de la política. Esto se debe a que participar en democracia significa tratarnos unos a otros como personas capaces de basar nuestras opiniones en evidencia histórica. Pero no podemos hacerlo si la comunidad no protege y practica una relación con la información que sea coherente con lo real.

Es por eso que las universidades de todo el mundo deben redoblar urgentemente su compromiso con la epistemología en sus currículos, ya que esta sustenta la búsqueda de la verdad. Eso significa proteger la ciencia y la historia de la intrusión política que las corrompe. Significa una educación temprana dirigida no solo a la alfabetización en la disertación, el diseño experimental, el modelado matemático y la narrativa literaria de vanguardia, sino también a enseñar a los estudiantes los conceptos erróneos comunes y las técnicas apropiadas para detectar información sesgada en la era de la inteligencia artificial. En este país, significa tener el coraje de apostar por el progreso ético y por una autonomía intelectual de la comunidad académica que sea verdaderamente asequible.

Incluso los alados de la democracia a menudo no aprecian plenamente el valor central que representa la verdad para ella, habiéndose convencido de que la verdad es un concepto demasiado difuso para tomarse en serio en política.

Una tarea central de las universidades es corregir esas suposiciones: convencer no solo de que el concepto de verdad puede ser rehabilitado como justicia epistémica, sino de que la democracia lo exige.

En mi opinión, la tradición filosófica que representa Dewey —el pragmatismo estadounidense— nos ofrece la mejor esperanza para una rehabilitación filosófica de la verdad en la política.

Para el filósofo y lingüista Noam Chomsky, lo que ha debilitado a la democracia es “una mera transferencia de conocimiento, consumido a través de la memorización y luego regurgitado en exámenes estandarizados[1]”. Lejos de tener una universidad comprometida e involucrada con el desarrollo del pensamiento independiente y crítico, las mentes de los estudiantes están anestesiadas, como el poeta John Ashbery capta con precisión en “¿Qué es la poesía?: En la escuela todos los pensamientos se peinaron, lo que quedaba era como un campo[2]”.

Charles Sanders Peirce etiquetó como concordancia aquello que perseguimos durante la investigación académica. Para Peirce, las respuestas concordantes son aquellas que sobreviven a los fuegos de la experiencia, resisten el escrutinio racional a largo plazo y no entran en conflicto con los hechos empíricos. Esta es la idea que puede ayudarnos a comprender la verdad en la política. Las proposiciones políticas son verdaderas cuando forman parte de una visión concordante de las prácticas políticas y sociales humanas: una visión que se mantiene unida internamente, pero que también concuerda con los hechos que existen fuera del ámbito político.

Por desgracia, en nuestra política polarizada, tendemos a dar sentido a casi todo desde la ideología. Pero el mundo es más grande que la política humana. Los hechos —o las verdades— sobre este mundo más amplio son independientes de los seres humanos, de una manera que la verdad política nunca puede serlo.

Ese es el punto clave que incluso algunos pragmatistas a veces no aprecian completamente: para explicar la verdad en política, debemos evitar suponer que la verdad viene en un solo tipo. La verdad política —y la realidad política— puede hacer que te persigan, censuren, lastimen o incluso maten. Nada es más real que eso. Pero es un error pensar que nuestros juicios políticos son verdaderos exactamente de la misma manera que nuestros juicios sobre las rocas, los enlaces químicos o los árboles. Las verdades de este último tipo representan un mundo independiente del humano. Decir la verdad en política, en cambio, implica ofrecer explicaciones concordantes: explicaciones que sean coherentes tanto con el mundo humano como con el mundo que va más allá de lo humano.

4.1 Deflacionismo: discurso de explicación de la verdad

Las especies tradicionales de inflacionismo incluyen teorías de la verdad por correspondencia, verdad por coherencia, pragmáticas de la verdad, primitivas de la verdad, verdad por predicción. En filosofía analítica de la verdad se suele hablar de teorías inflacionarias (o robustas) frente a teorías deflacionarias (o minimalistas).

Las inflacionarias consideran que la verdad es una propiedad sustantiva que añade algo importante más allá de la mera aserción. Dentro de ellas se suelen distinguir varias especies clásicas:

Teoría de la correspondencia: la verdad consiste en la relación entre las proposiciones y los hechos (un enunciado es verdadero si corresponde con la realidad).

Teoría de la coherencia: la verdad depende de la coherencia de una proposición dentro de un sistema o red de creencias.

Teorías pragmatistas: la verdad se identifica con lo que resulta útil, satisfactorio o con lo que “funciona” en la práctica (Peirce, James, Dewey, etc.).

Teoría de la redundancia/primordialidad (primitivas de la verdad): sostienen que “verdadero” es una noción básica que no puede definirse en términos más fundamentales, pero sí se usa para explicar fenómenos lógicos o semánticos.

Teorías predictivistas o verificacionistas (como las del positivismo lógico): identifican la verdad con la verificabilidad empírica o con el éxito predictivo de los enunciados.

Las especies en el género del deflacionismo se entienden mejor no como teorías de la verdad, sino, más bien, como diversas teorías del discurso sobre la verdad; es decir, como distintas explicaciones acerca de la mejor manera de comprender y explicar el funcionamiento de una teoría particular (fragmento). El fragmento de discurso en cuestión (el discurso de la verdad) puede circunscribirse como aquel que emplea lo que podemos llamar locuciones aléticas (por ejemplo: es verdadero, es falso, es verdadero que, es necesario que, es posible que, es imposible que). Después de todo, muchos defensores del deflacionismo niegan que exista alguna propiedad robusta de la verdad; y aquellos deflacionistas que conceden que “es verdadero” atribuye una propiedad, toman esta propiedad como “delgada” o insustancial. Como señala Leon Horsten: “el deflacionismo es una etiqueta para una conexión suelta de puntos de vista más precisos que comparten un parecido familiar entre sí[3]”.

¿La verdad es una propiedad con peso ontológico o solo una función en el discurso? Al destacar el papel de las locuciones aléticas, es un punto clave: no se trata tanto de lo que “es” la verdad, sino de cómo hablamos de ella y cómo esas expresiones cumplen funciones en la práctica discursiva.

El deflacionismo es un nuevo enfoque del tema de la verdad desarrollado en el siglo XX como una alternativa al inflacionismo. El enfoque inflacionario abarca todas las teorías tradicionales de la verdad. Lo que estas teorías tienen en común es una serie jerárquica de suposiciones sobre las locuciones aléticas más centrales, así como sobre los conceptos aléticos y las propiedades aléticas que supuestamente expresan y atribuyen. Todas las teorías tradicionales de la verdad presuponen o asumen:

1. Las locuciones aléticas (centralmente, “verdadero/a”) funcionan lógicamente como predicados.

2. Los predicados expresan conceptos o “atributos”, constructos y, por lo tanto, sirven para describir o caracterizar a los supuestos portadores de la verdad.

3. Estos conceptos atributivos determinan propiedades aléticas, cuya posesión (o falta de ella) se atribuye en las descripciones que proporcionan los usos de las locuciones aléticas.

4. Las propiedades aléticas atribuidas a través de las locuciones aléticas tienen una naturaleza robusta (o sustantiva).

Locuciones aléticas son aquellas expresiones o enunciados que atribuyen, niegan o se refieren al valor de verdad de una proposición. es una expresión lingüística cuyo contenido o función está relacionado con la verdad o falsedad de una proposición.

Ejemplo:

“Es verdadero que la Tierra gira alrededor del Sol.”

“Es falso que el fuego sea frío.”

“Debe ser verdad que llovió ayer.”

En estos casos, las palabras “es verdadero”, “es falso”, “debe ser verdad” son locuciones aléticas porque se refieren explícitamente a la condición de verdad de lo dicho.

Las modalidades aléticas o también llamado tipos principales de propiedades aléticas más comunes son:

Necesario que p → (□p)

Posible que p → (◇p)

Imposible que p → (¬◇p o ¬p es posible)

Contingente que p → (p y ¬p son posibles)

propiedad alética de la verdad que proporcionan las diferentes teorías. Todas ellas también presuponen que las locuciones aléticas desempeñan el papel semántico de atribuir la posesión (o la falta) de la propiedad de la verdad (o de la falsedad) a los portadores de la verdad, que generalmente se consideran como elementos tales como oraciones, símbolos oracionales, enunciados, cláusulas, proposiciones, afirmaciones, creencias o juicios. Una consecuencia de la suposición de que “es verdadero” es un predicado descriptivo consiste en que no hay “equivalencia de significado” entre una oración o proposición y una descripción de verdad de esa oración o proposición.

Como consecuencia, para los inflacionistas sobre la verdad, una atribución de verdad como “la nieve es blanca” no agota el análisis de la relación entre lenguaje y mundo. Un inflacionista, por supuesto, reconocerá algún tipo de equivalencia entre cada portador de la verdad y una atribución de verdad a él, una equivalencia expresada en los ejemplos de la versión preferida del teórico mediante el esquema de verdad neutral:

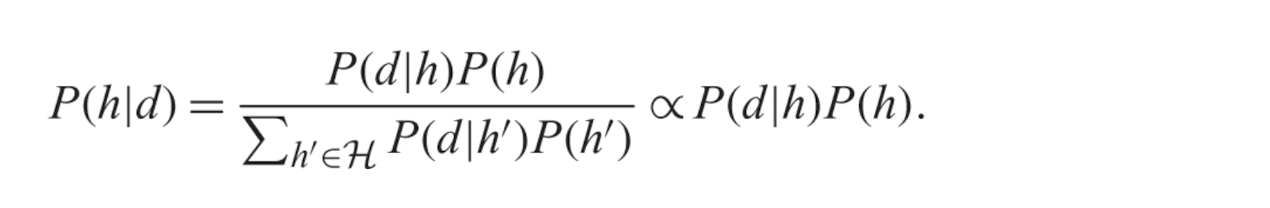

(TS) [p] es verdadera sí y solo si p.

Identificar (TS) como un esquema es reconocer que consiste en una especie de plantilla compuesta de palabras y símbolos, junto con ciertas reglas o condiciones que indican cuáles son los “rellenos” o “instancias” de dicha plantilla. Para (TS), esas condiciones especifican que p es una variable que se completa con oraciones (declarativas) en lenguaje natural, que los corchetes representan algún dispositivo de nominalización o denominación no especificado, y que “iff” (es decir, sí y solo si) indica una equivalencia no específica, una combinación de implicación e implicación inversa que no es necesariamente material.

Entendido de esta manera, un esquema es realmente una especie de sistema que tiene la capacidad de generar un número infinito de instancias del mismo. En el caso de (TS), genera las equivalencias de verdad, a veces llamadas sentencias T o bicondicionales T. Para los inflacionistas, estas equivalencias de verdad son atribuidas mediante el uso del predicado de verdad. La mayoría de los inflacionistas sostiene que tales equivalencias requieren una explicación sustantiva que involucre un análisis de esa propiedad en términos de conceptos más básicos y de ciertas propiedades y relaciones fundamentales que dichos conceptos determinan. En el fondo, es la tensión entre la descripción del predicado “verdadero” y su capacidad de fundamentación filosófica: el inflacionismo no se conforma con la mera equivalencia formal, sino que busca dotar a la verdad de un lugar ontológico o conceptual. Has logrado expresar eso sin perder rigor.

Por el contrario, un deflacionista tomará los ejemplos de su versión preferida del esquema (TS) como conceptualmente básicos y explicativamente fundamentales, o simplemente como productos triviales e inmediatos del modo en que opera el predicado de verdad desde una perspectiva lógico-lingüística. Como resultado, los deflacionistas sostienen que el “es” en los casos del esquema (TS) indica una equivalencia muy fuerte entre los lados izquierdo y derecho de estos bicondicionales. Por lo tanto, los deflacionistas reconocen y rechazan al menos algunos de los supuestos y presuposiciones estándar que generan las teorías inflacionarias de la verdad, resistiéndose a postular una propiedad de verdad sustantiva. En cambio, ofrecen una nueva comprensión tanto del concepto de verdad como del funcionamiento de las locuciones aléticas. Por esta razón, en lugar de una propiedad de la verdad, las diversas variantes del deflacionismo —como las teorías del discurso de la verdad o las teorías del concepto de verdad— reformulan el problema. En este contexto, las nociones de una “propiedad de verdad” o de “probadores de verdad” suelen ser reemplazadas por la noción de atribuir el predicado de verdad a ciertos enunciados u objetivos de aplicación. Es decir, deflacionismo: no negar la utilidad del término “verdad”, sino restringir su alcance ontológico. En lugar de buscar una entidad o propiedad metafísica que fundamente la verdad, el deflacionismo desplaza la cuestión hacia el uso lingüístico del predicado, mostrando que decir “es verdad que p” no añade contenido a la afirmación “p”.

Dos corrientes son predominantes en el pensamiento y la cultura moderna. Por un lado, hay un intenso compromiso con la veracidad —o, en todo caso, una suspicacia generalizada, una disposición a no ser engañados, un afán de ver a través de las apariencias las verdaderas estructuras y motivos que subyacen detrás de ellas. Sin embargo, junto con esta exigencia de veracidad —o, para decirlo de manera menos positiva, este reflejo contra el engaño—, hay una sospecha igualmente generalizada sobre la verdad misma: si existe tal cosa; si no la hay; si puede ser más que relativa o subjetiva, o algo por el estilo; y, en conjunto, si debemos preocuparnos por ella en el desarrollo de nuestras actividades o al dar cuenta de ellas. Estas dos cosas —la devoción a la veracidad y la sospecha dirigida a la idea de verdad— están conectadas entre sí. El deseo de veracidad impulsa un proceso de crítica que debilita la seguridad de que existe una verdad firme o incondicionalmente afirmable.

La sospecha se apodera porque los relatos que se han ofrecido como portadores de la verdad sobre el pasado a menudo resultan ser sesgados, ideológicos o interesados. Pero los intentos de reemplazar estas distorsiones con “la verdad” pueden tropezar, una vez más, con el mismo tipo de objeción. Entonces surge la cuestión de si cualquier relato puede aspirar a ser, simplemente, verdadero: si la verdad objetiva —o la verdad en absoluto— puede considerarse honestamente como el objetivo del estudio. Pero si la verdad no es el objeto de nuestro estudio en la universidad, entonces debe aceptarse que nuestra situación implica prescindir de la verdad para el progreso ético.

Podemos ver cómo la exigencia de veracidad y el rechazo de la verdad pueden ir de la mano. Sin embargo, esto no significa que puedan coexistir felizmente, ni que la situación sea estable. Si realmente no crees en la existencia de la verdad, ¿por qué la pasión por la veracidad? O, como también podríamos decir: en la búsqueda de la veracidad, ¿a qué se supone que estás siendo fiel? No se trata de una dificultad abstracta ni de una paradoja. Tiene consecuencias para la política real, y señala el peligro de que nuestras actividades intelectuales —particularmente en las humanidades— puedan hacerse pedazos. La tensión entre la búsqueda de la veracidad y la duda de que haya realmente alguna verdad que se pueda encontrar se manifiesta en una dificultad significativa: el ataque a alguna forma específica de verdad —como, en el caso que he mencionado, la verdad llamada historia— depende en sí mismo de algunas afirmaciones u otras que, a su vez, tienen que ser tomadas como verdaderas. De hecho, en el caso de la historia, esas otras reclamaciones serán reclamaciones del mismo tipo. Incluso la crítica más radical se apoya, en última instancia, en alguna confianza —por mínima que sea— en la posibilidad de decir algo verdadero. La honestidad intelectual no exige certezas absolutas, pero sí el coraje de sostener algunas verdades como provisionales, frágiles, pero necesarias para que el pensamiento no se disuelva en pura sospecha.

Aquellos que dicen que todos los relatos históricos son construcciones ideológicas se basan, sin embargo, en una historia que debe reclamar la verdad histórica. Muestran que historiadores supuestamente “objetivos” han contado tendenciosamente sus relatos desde alguna perspectiva particular política; describen, por ejemplo, los sesgos que se han entretejido en la construcción de diversas historias de México. Tal relato, como una pieza particular de la historia, puede muy bien ser cierto. Pero la verdad es una virtud vergonzosamente inútil para un crítico que no solo quiere desenmascarar a los historiadores del pasado de México, sino también afirmar que, al final del camino, no hay verdad histórica. Es notable lo complacientes que pueden ser algunas historias “deconstructivas” respecto al estatus de la historia que despliegan.

4.2 El pálido tinte del pensamiento

El matiz nativo de la razón, en el principio, fue un motivo. El motivo debió haber sido urgente: no parece que muchas deliberaciones hayan precedido a la acción que provocó. Cualquier acción precipitada es arriesgada, pero para una empresa particularmente trascendental —como la creación de un universo— el riesgo se ve agravado por la dificultad de saber de antemano cómo resultarán las cosas.

En un proyecto de esta magnitud, al menos tendría sentido tomárselo con calma, dejar que el polvo se asiente y mirar a su alrededor antes de pasar a la siguiente etapa: Y dijo Dios: hágase la luz. Y fue la luz. Y vio Dios la luz, que era buena.

Sin embargo, la autosupervisión rara vez es un enfoque eficaz para el control de calidad. Como podrían argumentar los gnósticos, el acto bíblico de la creación podría haberse beneficiado de una revisión previa al lanzamiento a gran escala, dado que su producto es tan radicalmente defectuoso (atestigua el sufrimiento generalizado e inevitable en el mundo).

Suponiendo que las intenciones por parte del responsable hayan sido buenas, este resultado —aunque imperfecto— debería hacer reflexionar a cualquier aspirante a creador de mundos: entre la idea y la realidad, entre el movimiento y el acto, cae la sombra.

Es posible que los meros seres finitos como nosotros no estemos en el negocio de crear universos enteros (todavía), pero rutinariamente tratamos de rehacer lo que podemos de nuestro pequeño mundo para nuestro beneficio, a través de nuestras acciones. En ese intento, nos encontramos con fracasos ocasionales, y las consecuencias de estos pueden no ser menos trascendentales para nosotros —y para los demás— de lo que un universo defectuoso habría sido para su creador (si este no se hubiera escudado de la responsabilidad hacia sus habitantes permaneciendo fuera de él). Una mala racha de intentos abortados puede conmocionar a una persona y llevarla a la pasividad por el resto de su vida. En resumen, traslada el problema de la creación fallida —antes atribuido a una divinidad— al terreno humano, personal y cotidiano. La analogía es sutil pero eficaz: así como un universo defectuoso puede ser catastrófico para sus criaturas, también lo puede ser un fracaso existencial para quien intenta modificar su mundo sin éxito. La crítica al creador que “permanece fuera de su mundo” se puede leer como una acusación al abandono, a la irresponsabilidad ante el dolor humano, pero también como un espejo de nuestras propias evasiones.

La inacción no es inherentemente más segura que la acción, ni moralmente preferible a ella. No lo es en la guerra —precisamente porque uno nunca puede estar seguro de que todos los demás se abstendrán de una acción hostil—. Y para quienes están presenciando el ejercicio de un poder que causa sufrimiento a otros, no hacer nada es también tomar una postura moral. Aun así, parece aconsejable aprender a desconfiar de los propios motivos, deseos y creencias, y, para aquellos que se consideran dignos, tratar de anticipar las consecuencias de la acción y de la inacción antes de comprometerse con una decisión. Y ahí, como dice Hamlet, está el problema. La famosa duda de Hamlet es profundamente humana y, sin embargo, está arraigada en rasgos mentales que compartimos con muchas otras especies. Si observamos a un gato envejecido considerar un salto dudoso entre dos muros, sospecharemos que lo que dijo William James es cierto: donde la indecisión es grande —como antes de un salto peligroso—, la conciencia es angustiante e intensa.

Las razones detrás de la agonía de la vacilación y la indecisión tienen tanto que ver con la naturaleza del mundo que habitamos como con la naturaleza humana —o felina—. La razón principal es la complejidad desmesurada de la red de causa y efecto: las posibles repercusiones de cualquier acto —o de una inacción impotente— se ramifican exponencialmente, especialmente en los asuntos humanos, a medida que uno trata de anticipar el futuro. Incluso si se conocieran todos los parámetros relevantes de la situación, e incluso si nuestro razonamiento a partir de esas premisas fuera impecable, ninguna cantidad de reflexión puede igualar tal complejidad. Es necesario cortar esquinas, hacer aproximaciones; e incluso entonces, en algún momento se debe lanzar la suerte antes de que todas las percepciones deseadas estén listas.

La complejidad del pensamiento prospectivo se ve agravada por la dificultad de la previsión emocional. En cada etapa de la avalancha creciente de posibles acontecimientos desencadenados por el acto en cuestión, es probable que experimentemos emociones diversas. Lo que podrían ser esas emociones depende, de forma compleja, tanto de la historia personal como de la situación futura que solo podemos imaginar imperfectamente. A medida que el implacable “tiempo” nos arrastra hacia ese futuro, la acción nos prepara para un posible “arrepentimiento”.

4.3 La persona de acción considera que lo que sabes que no sabes puede lastimarte

Desde el principio hasta el fin, la acción está acosada —y a veces empañada— por problemas: desde deseos irresponsables, pasando por información incompleta y razonamientos imperfectos, hasta consecuencias irreparables y arrepentimientos. Sin embargo, detenerse hasta el cansancio en las trampas potenciales no hará que desaparezcan ni que uno sea más feliz. Así que, como dijo Hamlet, la conciencia nos hace cobardes a todos, y así el matiz nativo de la resolución se enferma con el pálido tono del pensamiento, y las empresas de gran médula y momento desvían sus corrientes y pierden el nombre de acción.

Después de tanta deliberación, más vale actuar. Al diablo con las consecuencias. Al final, esa fue la elección de Hamlet, y no se arrepintió. La mayoría de nuestras empresas cotidianas no son tan trascendentales como la suya, y la mayoría de ellas no significan la muerte. La vida es aquello a lo que nos aferramos, y es lo inesperado lo que hace que la vida sea posible.

Es justo decir que la ambición es para el cuerpo político lo que la sal de mesa es para el cuerpo humano: imposible vivir sin ella, pero acorta seriamente la vida si se usa en exceso. Esto sugiere que la ambición debería estar sujeta al principio de los datos: ninguna sociedad moderna tiene la ambición de todos en el punto óptimo entre demasiado y demasiado poco.

Mi conjetura es que la dinámica social de la ambición es la culpable. Muchas personas tienen lo que contaríamos como la cantidad justa de ambición, pero algunas son ambiciosas más allá de los límites de la prudencia y la justicia —para usar la frase de Adam Smith—. El mero hecho de observar a esos luchadores y escaladores en acción es probablemente suficiente para sacar a los miembros de la modesta mayoría de su punto de equilibrio. Algunos contraen indefensión aprendida (como cuando se encuentran bajo el poder de un advenedizo) y terminan deprimidos. Muchos otros ven avivada su propia ambición y se ven arrastrados a la carrera de ratas, solo para experimentar una continua decepción con sus logros, ya que estos no logran mantenerse al día con sus aspiraciones.

Siendo la ambición un fenómeno fundamentalmente interpersonal, la comparación social que implica es una fuerza con la que todas las sociedades deben lidiar. Con muy pocas excepciones, nuestras economías y nuestra política están impulsadas por la ambición de “piel y lugar”. Adam Smith, una figura decorativa del Siglo de las Luces a quien a menudo se hace referencia como el padre fundador del capitalismo, señaló que la piel y el lugar —economía y política— son inseparables.

“Los objetos de la avaricia y de la ambición difieren solo en su grandeza. Un avaro está tan furioso por media moneda como un hombre ambicioso por la conquista de un reino.”

La famosa idea detrás del otro libro de Smith, La riqueza de las naciones, es que la ambición económica de cada persona tendría, como efecto secundario, el beneficio de la sociedad en su conjunto. Esta noción ha sido presentada como una explicación del enorme crecimiento económico que el mundo ha experimentado en los dos últimos siglos. Sin embargo, existe una explicación alternativa: que dicho crecimiento ha sido impulsado por la explotación de la mayoría a manos de unos pocos excesivamente ambiciosos.

Sea como fuere, el crecimiento es un fenómeno problemático. Por un lado, hace posible la mejora económica personal, y es difícil culpar a la gente por querer estar tan bien como sus vecinos. Por otro lado, una incesante carrera armamentista global por los niveles de vida, que estimulada por la búsqueda de ganancias por parte de aquellos que se benefician del consumo de otros, existe un crecimiento constante. Esto, cuando se compone, se vuelve exponencial, lo que, como nos dicen las matemáticas, es insostenible cuando los recursos de los que depende son finitos.

Con un solo planeta por explotar, la inminente escasez de recursos obliga cada vez más a que el luego económico se adelante suma cero: la ganancia de una persona debe ser la pérdida de otra persona, o de muchas otras personas. Así, la naturaleza del crecimiento hace que la ambición, ya sea meramente de autopromosión o de dominación de los demás, sea problemática también, en un sentido puramente empírico-económico. También es un problema de ansiedad y estrés innecesarios. Y ni siquiera está garantizado que conduzca al éxito profesional. ¿Por qué no podemos todos relajarnos un poco?

Una razón por la cual un estado de moderación general en asuntos de ambición —que es lo que Adam Smith defendía— resulta inestable en el tiempo puede encontrarse en la dinámica misma del poder. Como observó Hannah Arendt, el poder, al igual que la acción, no tiene límites físicos: no está restringido por la naturaleza corporal del ser humano, como ocurre con la fuerza. Su única limitación real es la existencia de otras personas. Pero esta no es una limitación accidental, sino estructural, ya que el poder humano nace precisamente de la condición de pluralidad. Por lo tanto, la naturaleza del poder parecería garantizar que, mientras exista una sociedad, la ambición estará siempre en riesgo de desbordarse.

Adam Smith ilustró con sabiduría: nunca entres en esa obra de la que tan pocos han podido regresar; no te adentres en el círculo de la ambición; no te compares con esos amos de la tierra que ya han absorbido la atención de la mitad de la humanidad antes que tú.

Muchas creencias supersticiosas surgen porque se interpreta como causalidad lo que en realidad es solo coincidencia. Sin controles adecuados, no se obtiene evidencia confiable. Determinar relaciones de causa y efecto es una de las principales formas de dar sentido al mundo, y en el ámbito científico, los experimentos controlados aleatorios son el estándar de oro para lograrlo.

Para probar si una causa C genera un efecto E, no basta con observar los casos en los que C ocurre; es necesario compararlos con aquellos en los que C no se presenta. Este grupo sin la causa se denomina grupo de control. Si el efecto E ocurre tanto con como sin C, entonces no se puede concluir que C sea la causa de E. Un ejemplo común es el de los ensayos clínicos. Si el grupo que recibe un nuevo compuesto no muestra mejores resultados que el grupo de control que recibe un placebo (una pastilla sin principio activo, como una pastilla de azúcar), entonces no hay evidencia suficiente para afirmar que el compuesto funciona. Aunque esta lógica parece simple, los experimentos pueden volverse rápidamente complejos, ya que es fundamental asegurarse de que no existan otros factores que puedan distorsionar o confundir los resultados.

Tal vez al grupo que recibió el compuesto le fue mejor, pero no gracias a la causa C, sino debido a algún otro factor correlacionado con C que en realidad produjo el efecto. Sin embargo, es común que controlar todos los factores posibles resulte difícil o incluso inviable. Por esta razón, la asignación aleatoria de los participantes al grupo experimental o al grupo de control es una herramienta fundamental: se presume que esta distribución aleatoria equilibra, en promedio, los demás factores relevantes entre ambos grupos.

Pero, ¿qué sucede si la mejora observada no se debe al efecto real de C, sino a la creencia del sujeto en la eficacia de C? Este es el llamado efecto placebo. Para evitarlo, es crucial que los participantes estén ciegos respecto al grupo al que pertenecen: ni deben saber si están recibiendo el tratamiento o el placebo. Sin embargo, incluso esto puede no ser suficiente.

Los investigadores mismos pueden influir inadvertidamente en los resultados si saben qué participantes reciben el tratamiento. Por ello, se utilizan ensayos doble ciego, en los que ni los participantes ni los experimentadores saben quién pertenece a qué grupo, al menos hasta después de que se hayan recogido todos los datos. Aun así, es posible que se observen diferencias entre los grupos por simple azar. Para determinar si los resultados tienen peso real, se debe realizar un análisis estadístico riguroso que permita establecer si las diferencias encontradas son estadísticamente significativas, es decir, si es poco probable que hayan ocurrido por mera casualidad.

Y aún hay más consideraciones: ¿los instrumentos están correctamente calibrados? ¿Se garantiza la integridad, pureza y conservación de las sustancias? ¿Las muestras están libres de contaminación? ¿Se ha verificado que no existan errores en el algoritmo computacional o en los modelos matemáticos utilizados? ¿La interpretación de los datos es consistente con el marco teórico? Como recordaría Richard Feynman, se necesita no solo aplicar la metodología científica, sino también el más alto estándar de honestidad intelectual. Un estudiante de ciencias pronto descubrirá que la ciencia exige mucho más que aplicar procedimientos: exige escrutinio, humildad, vigilancia constante y apertura al error, si de verdad se busca realizar y confirmar un descubrimiento auténticamente científico.

Una vez más, es importante tener en cuenta lo que está en juego cuando se habla de la asistencia que brindan los métodos apropiados en la práctica científica. Como bien señalaba Richard Feynman, hacer ciencia no es solo aplicar procedimientos, sino prestar una atención rigurosa a las condiciones que permiten emitir un juicio válido sobre el valor del trabajo realizado. Esto implica preguntarse, entre otras cosas: ¿qué tan sólida es la evidencia que respalda una conclusión? ¿Qué grado de confianza es razonable tener en un supuesto descubrimiento?

Estas preguntas no son meramente técnicas: son cuestiones normativas, pues implican valorar la calidad del razonamiento, la fiabilidad de los datos, la transparencia del método y la honestidad en la interpretación. En efecto, la ciencia, lejos de ser un conjunto mecánico de reglas, es una práctica profundamente ética y epistémicamente comprometida con el juicio crítico, la claridad en los límites del conocimiento y la apertura a la revisión.

Podemos pensar los métodos científicos no solo como formas de llegar a mejor a las verdades de la naturaleza, sino también como formas de mantenernos honestos y objetivos en esa búsqueda. Como explica Feynman, el cuidado que ponemos con respecto a proporcionar información completa sobre la hipótesis alternativa y posibles fuentes de error, está destinado a ayudarnos a evitar engañarnos inadvertidamente a nosotros mismos, tanto individualmente como en comunidad.

También es fundamental la comunicación honesta. Los científicos suelen añadir calificativos de diversa índole —puede ser, parece ser el caso, la evidencia sugiere— que expresan el grado de apoyo probatorio asociado a sus afirmaciones. El discurso científico está impregnado de estos marcadores de incertidumbre, que indican con precisión el nivel de confianza que puede depositarse en una determinada conclusión. Para quienes no están familiarizados con el lenguaje de la ciencia, esta forma de hablar puede parecer ambigua o indecisa. Un oyente ajeno al campo tal vez se pregunte por qué los científicos no pueden ofrecer respuestas más directas, sin ese “exceso de precaución” epistemológica. Pero tales expresiones no son un defecto del lenguaje científico: son, de hecho, una de sus virtudes fundamentales. Tienen un propósito específico en el contexto: señalar el grado apropiado de creencia que se debe atribuir a una afirmación en función de la evidencia disponible. Y tienen también un propósito más general: recordar que la ciencia no se funda en la autoridad de quien habla, sino en la solidez de la evidencia que respalda lo dicho. En este sentido, la honestidad intelectual —expresada mediante la precisión lingüística— es un componente esencial de la práctica científica.

4.4 La honestidad científica, el gran vacío en la educación moderna

Una conversación previsible, llena de palabras que irán chocando contra un muro sin encontrar salida. Como esos insectos que repiquetean contra los fluorescentes hasta que son abatidos por una de esas luces letales que los recibe y los convierte en un disparo. A su alrededor, todo se deshace. Las certezas se licúan como un mar incierto. Como un eco que, dentro del cerebro, va horadando un hueco hasta ocupar todo el espacio, impidiendo pensar en cualquier otra cosa.

Uno podría objetar, razonablemente, que la honestidad absoluta y la información completa no siempre pueden coexistir en la ciencia, al menos no en todas las formas detalladas que Feynman recomienda. Si bien sería útil, para el progreso del conocimiento, poder acceder a todos los datos de estudios fallidos, esto no siempre resulta factible ni deseable en la práctica. ¿Quién publicaría esos datos o los pondría a disposición, y cómo, si no es a través de publicaciones?

Todo científico activo sabe que detrás de cualquier investigación exitosa que culmina en un descubrimiento y en un artículo publicado, se esconden numerosos experimentos fallidos e hipótesis descartadas. Sin embargo, parecería poco práctico publicar sistemáticamente artículos científicos que detallen exclusivamente estos resultados negativos. A veces se dice que el secreto de la ciencia es "equivocarse rápidamente", pero eso no implica que un científico con más fracasos sea más productivo. ¿Sería económicamente viable que las revistas científicas publicaran una vasta literatura de intentos fallidos y callejones sin salida? ¿A alguien realmente le interesaría suscribirse a semejante archivo? La idea, en principio, puede parecer absurda. De hecho, es lo suficientemente provocadora como para que exista una auténtica “Revista de Resultados Irreproducibles”, dedicada a la sátira científica y al humor, que parodia precisamente esta tensión entre ideal y práctica.

Dicho esto, Feynman seguramente tiene razón en que, en muchos casos, dicha información sería útil para otros científicos e importante incluirla por las razones mencionadas: ayudar a juzgar el valor de cualquier resultado positivo que se presente. De hecho, la mayoría de los ejemplos específicos que dio Feynman involucran evidencia de hipótesis alternativas o posibles factores de confusión que un buen experimentador debería verificar como parte del proceso de prueba de hipótesis. Sería deshonesto no informar los resultados de tales pruebas. Pero es importante notar que Feynman no se limitaba a decir que sería incorrecto actuar con deshonestidad. Más bien, abogaba por un estándar positivo de honestidad, un compromiso activo con un criterio más exigente como base de la integridad científica. Integridad es la palabra clave aquí, porque la clase de honestidad radical que defendía Feynman implica precisamente la integración entre valores y métodos, tal como se requiere en la práctica ejemplar de la ciencia. Dado que el objetivo de la ciencia es responder a preguntas empíricas que satisfagan nuestra curiosidad sobre el mundo, solo mediante el esfuerzo riguroso y el máximo cuidado en los métodos y las prácticas, es posible que un científico —y la comunidad científica en su conjunto— tengan la certeza de que una pregunta ha sido respondida satisfactoriamente, y que realmente hemos alcanzado un descubrimiento genuino.

Sin embargo, esto no equivale a afirmar que deban publicarse todos los experimentos fallidos. Existen muchas hipótesis que, aunque razonables o incluso probables dado el estado actual del conocimiento, no resisten la prueba empírica; tales fracasos pueden ser valiosos e interesantes para la comunidad científica, y merecen ser publicados. Si alguien fundara una revista dedicada a ellos, seguramente encontraría una audiencia científica receptiva.

Pero otros fracasos no ofrecen valor alguno, ni por sus resultados ni por su contexto experimental. No publicarlos no es más deshonesto que no publicar estudios exitosos sin interés. Por supuesto, existen muchos casos límite, en los que el grado de interés es una cuestión de valoración editorial. Podríamos incluso coincidir en que los editores deberían adoptar una perspectiva más generosa, especialmente ahora que la publicación electrónica ha reducido considerablemente las limitaciones económicas del formato impreso.

Hay preguntas importantes que considerar, así como compromisos que evaluar en torno a la política editorial y profesional implicada. Sin embargo, en general, esta situación no constituye un verdadero contraejemplo moral a la virtud de la honestidad científica.

Hay varios puntos importantes que debemos considerar como respuesta a esta crítica de la virtud de la honestidad. El primero es distinguir entre dos cuestiones: (1) si una investigación peligrosa debe o no llevarse a cabo, y (2) si, una vez realizada, debe publicarse abierta y honestamente. La primera es una cuestión sobre los límites éticos de la curiosidad científica —por ejemplo, si el Proyecto Manhattan fue moralmente justificable—, pero no es una cuestión de honestidad en sí misma.

En el caso que nos ocupa, partimos de la base de que, por la razón que sea, la investigación ya se ha realizado. Entonces, la pregunta relevante es si no publicar los resultados (o incluso publicarlos de forma engañosa para desviar a otros) constituye una violación de la honestidad científica.

La virtud de la honestidad es central en la ciencia porque es indispensable para satisfacer la curiosidad humana a través del descubrimiento riguroso de verdades empíricas. Es una disposición práctica que hace posible la comprensión del mundo natural. Por ello, debemos asumir la honestidad como una virtud fundamental, aunque también reconozcamos que puede haber casos extraordinarios en los que su ejercicio deba sopesarse frente a otros valores éticos, como la prevención de daños públicos graves.

Lo que ocurre en tales situaciones no es que se niegue el valor de la honestidad, sino que esta se da por sentada como estándar científico, y se contrasta con otros intereses sociales de mayor alcance. El descubrimiento de la verdad es un fin importante, pero no es el único. Afirmar que la veracidad es un valor esencial en la ciencia no implica que los hallazgos científicos deban divulgarse siempre y sin excepción. A veces, hacer lo correcto puede significar retener información en un contexto social más amplio, con el fin de evitar consecuencias catastróficas.

El científico que reconoce esta posibilidad no está socavando la virtud de la honestidad, sino entendiendo que, en contextos extremos, los valores científicos pueden entrar en conflicto con valores más amplios relacionados con la seguridad o la supervivencia, y que esos conflictos requieren deliberación ética madura, no negación de principios.

A principios de la década de los 2000, Jan Hendrik Schön era una estrella en ascenso en la física. Su investigación se situaba en la intersección de la física de la materia condensada, la nanotecnología y la ciencia de semiconductores. Mientras trabajaba en los Laboratorios Bell, publicó una serie de artículos —la increíble cantidad de dieciséis como primer autor en Science y Nature, las revistas científicas más importantes del mundo— durante un periodo de dos años, presentando resultados sobre el uso de moléculas orgánicas como transistores. Uno de sus artículos fue reconocido por Science en 2001 como un “avance del año”. Recibió varios premios prestigiosos, incluido el Premio al Investigador Joven Sobresaliente de la Sociedad de Materiales. Su investigación parecía destinada a revolucionar la industria de los semiconductores, permitiendo que los chips de computadora continuaran reduciendo su tamaño más allá de los límites de los materiales tradicionales. El único problema de todo esto es que nada de eso era cierto[4].

4.5 La lógica del método filosófico

A menudo se piensa que la lógica juega un papel importante en la investigación científica y filosófica. Nos basamos en ella para demostrar teoremas, probar hipótesis y construir sistemas lógicos para resolver una serie de problemas. Sin embargo, a pesar de la prominencia de la lógica dentro de la investigación, tenemos una comprensión relativamente pobre de su epistemología. Por el contrario, dentro de la filosofía contemporánea de la ciencia, uno se sorprende por la amplia gama de estudios detallados sobre los mecanismos por los cuales las teorías se construyen y evalúan en las ciencias. Uno encuentra investigaciones sobre los desafíos específicos que enfrentan los modelos climáticos debido a la complejidad de su objeto de estudio[5], y cómo los biólogos usan simultáneamente múltiples modelos para cumplir distintos objetivos predictivos y explicativos[6]. Combinados, estos estudios pintan un panorama de la investigación mucho más complejo y multidimensional de lo que admiten las teorías confirmacionistas o falsacionistas tradicionales. Sin embargo, si bien la lógica es una actividad humana tan rica e interesante como la de las ciencias, no se pueden extraer las mismas conclusiones positivas sobre nuestra comprensión actual de su epistemología. De hecho, hasta hace poco, se habían hecho pocos intentos por elaborar descripciones detalladas de los múltiples objetivos de la lógica, los mecanismos mediante los cuales se evalúa y las fuentes de evidencia que fundamentan nuestras teorías lógicas.

Todavía es frecuente encontrar apelaciones genéricas a las intuiciones racionales para subsanar nuestra ignorancia sobre la epistemología de la lógica. Sin embargo, no basta con reconocer nuestras deficiencias actuales. También debemos valorar cómo podemos mejorar. Primero, destacando tres supuestos que han obstaculizado el progreso de la epistemología de la lógica, y segundo, señalando (aunque sea demasiado brevemente) lo que se puede lograr una vez que evitamos estos obstáculos. Comenzamos, con el error que a veces se comete al confundir la epistemología de la lógica con la epistemología del (buen) razonamiento.

A menudo se afirma que la lógica es el estudio del buen razonamiento, y es cierto que esta comprensión de la lógica ha desempeñado un papel importante en su desarrollo. Sin embargo, incluso si la lógica es el estudio del buen razonamiento, esto no implica que la epistemología de la lógica sea equivalente a la epistemología del buen razonamiento. Concebir la epistemología de la lógica simplemente como la epistemología del buen razonamiento ha llevado a un enfoque, a menudo singular, en especificar las condiciones bajo las cuales alguien es justificado en hacer un cierto tipo de inferencia.

Sin embargo, una cosa es que la lógica tenga implicaciones para el buen razonamiento (deductivo), y otra es pensar que la epistemología de cómo descubrimos y justificamos estas leyes lógicas es equivalente a las condiciones bajo las cuales alguien está justificado en hacer una inferencia. Esto sería similar a reducir la epistemología de los axiomas de la aritmética a la del conteo o la suma.

Nuestro segundo error, que es presumir que el método filosófico más adecuado para construir una epistemología de la lógica es deducirla de nuestras propias suposiciones sobre la naturaleza de la lógica, el conocimiento y la racionalidad en general. Esto se conoce como un enfoque de arriba hacia abajo para la epistemología de un campo; se parte de ciertas suposiciones (razonables) sobre el campo y otras afirmaciones que consideramos conocer, y a partir de ellas se infiere cómo debería ser la epistemología del campo dados estos hechos.

Este enfoque ha dado lugar a muchas de las epistemologías tradicionales de la ciencia y las matemáticas, como el falsacionismo de Popper. Desafortunadamente, este enfoque suele generar imágenes simplistas de la epistemología del campo. Lo mismo ocurre con la lógica. Para corregir este error, es necesario abandonar los enfoques descendentes y adoptar un enfoque ascendente, en el que las epistemologías de la lógica se construyen a partir de estudios de caso sobre cómo los lógicos desarrollan y justifican sus teorías. En otras palabras, consideramos la práctica de los lógicos como una guía fiable de lo que constituye la epistemología de la lógica, del mismo modo que consideramos las actividades de los científicos como la guía más fiable de cómo funciona el método científico. Esta metodología, conocida como el enfoque basado en la práctica, es la base de gran parte del progreso reciente en la filosofía.

El tercer y último error que debe evitarse, que consiste en presumir que la epistemología de la lógica debe ser completamente diferente a la de otras áreas de investigación, en particular las ciencias reconocidas. Por supuesto, dado que cada área de investigación tiene su propia temática y objetivos de investigación, esperaríamos que las normas metodológicas de cada campo reflejaran estos objetivos y las características de su temática. Sin embargo, en el caso de la lógica, la expectativa tradicional es que su epistemología sea completamente diferente a la de otras áreas, basándose en su estatus fundamental en la investigación. El resultado es una forma de fundacionalismo epistémico, en el que al menos un subconjunto de las leyes lógicas debe ser accesible de forma no inferencial para nosotros, ya sea mediante la comprensión racional o la analiticidad. Aquí mostramos que, una vez que consideramos cómo los lógicos justifican realmente su lógica, es evidente que no tenemos acceso directo a las leyes lógicas (ni siquiera de forma falible). Si bien es perfectamente aceptable proponer diferencias entre la epistemología de la lógica y las ciencias reconocidas, dichas propuestas no deberían ser axiomas basados en presunciones filosóficas, sino justificarse por las realidades de la investigación en el campo. Para mostrar los beneficios de evitar estos obstáculos, es necesario una epistemología de la lógica, el predictivismo lógico, que no comete ninguno de estos errores. Según el predictivismo, las lógicas se justifican por su éxito predictivo, su poder explicativo y su compatibilidad con otros compromisos bien fundamentados. No presupone que una epistemología de la lógica sea equivalente a una epistemología del razonamiento (aunque la lógica sea, en cierto sentido, el estudio del buen razonamiento), ni que su epistemología deba ser completamente diferente a la de otras áreas de investigación (aunque seguirá teniendo sus propias características particulares), y se justifica no sobre la base de presunciones sobre cómo creemos que debería ser la epistemología de la lógica, sino más bien sobre cómo se justifican realmente las lógicas en el campo. Comprender la epistemología de la lógica es importante no solo por la vergüenza profesional que los filósofos de la lógica puedan sentir al observar los éxitos comparativos de los filósofos de la ciencia. Comprender qué hace que la lógica sea exitosa tiene claras motivaciones prácticas. A pesar del éxito de la lógica clásica, en los últimos sesenta años hemos presenciado una proliferación de lógicas no clásicas, como la paraconsistente, la subestructural y la constructivista. Cada una con sus propias motivaciones, ya sea para abordar una paradoja lógico-semántica, preocupaciones sobre la vaguedad o la naturaleza de la investigación matemática. Por supuesto, a pesar del aumento de competidores no clásicos, la lógica clásica puede ser correcta; después de todo, ha sido una teoría notablemente exitosa. Sin embargo, su éxito (y su veracidad) continuos no están asegurados. Si bien nuestro período no es precisamente uno de crisis científica, sí es uno de plenitud lógica. Con la abundancia de lógicas disponibles, tenemos la necesidad de evaluar cuál se adapta mejor a nuestros objetivos teóricos. Dado esto, al igual que durante los períodos de revolución en las ciencias, cuando la atención se centraba en cuestiones epistemológicas fundamentales sobre el campo, ahora es apropiado hacerlo con la lógica. Solo entonces podremos entender por qué algunas lógicas son mejores que otras. Sin embargo, para siquiera involucrarnos en la comprensión de estos procesos y por qué valoramos ciertas lógicas, es fundamental que prestemos a la epistemología de la lógica su propia atención, además de la del (buen) razonamiento. Por esta razón, comenzamos con una discusión de esta distinción.

4.5.1 La epistemología de la lógica y el razonamiento

Hablar de “lógica” es ambiguo, por lo que hablar de la epistemología de la lógica está destinado a contener ambigüedades derivadas. En diferentes contextos, usamos con gusto el término “lógica” se refiere a:

(i) el área de investigación en sí, practicada en los departamentos de filosofía, matemáticas e informática;

(ii) los objetos, en este caso los sistemas y herramientas matemáticos, que producen los lógicos; y (iii) el/los objeto(s) de investigación del área.

Sin embargo, inevitablemente, el uso que se haga del término influirá en la respuesta a lo que constituye la epistemología de la lógica. En particular, limitar la comprensión de la “lógica” a un tema específico dentro del área de investigación restringirá el enfoque a la epistemología de este supuesto tema. Esto ocurre a veces en los debates contemporáneos sobre la epistemología de la lógica, donde se ha prestado atención principalmente a la epistemología del buen razonamiento. Si bien este enfoque es comprensible, ya que se presupone desde hace mucho tiempo que el propósito principal de la lógica es determinar las reglas para el buen razonamiento, en última instancia limita nuestra comprensión de la epistemología de la lógica.

Nuestro objetivo es doble. En primer lugar, advertimos contra la equiparación de la epistemología de la lógica con la epistemología de lo que a menudo se considera su objeto principal: el buen razonamiento. Si bien la lógica, correctamente entendida, es el estudio de las leyes del buen razonamiento, esto no significa que la epistemología de la lógica sea equivalente a la epistemología del buen razonamiento. Para demostrarlo, distinguimos cinco niveles de justificación “lógica”, cada uno de los cuales requiere un mayor grado de comprensión que el anterior, desde la capacidad de realizar inferencias lógicas fiables en un extremo del espectro hasta estar justificado al respaldar una lógica en el otro. Además, demostramos que las condiciones para poseer justificación en cada nivel no son suficientes para el siguiente. Por lo tanto, comprender la epistemología de cada nivel es una tarea discreta. Esto resalta la importancia de separar dos proyectos distintos:

(i) proporcionar una epistemología para el buen razonamiento (supuestamente lógico), y

(ii) una epistemología para la teorización lógica.

En segundo lugar, señalamos que, para responder a preguntas importantes sobre la naturaleza de la lógica, existen razones convincentes para no restringirnos a la epistemología del buen razonamiento, sino más bien para prestar atención a formas más teóricas de justificación lógica. Esto constituye la base de nuestra decisión en centrarnos en la epistemología de la lógica entendida en este sentido más teórico: lo que llamaremos lógica artificialis.

4.5.2 La lógica como ciencia e instrumento para el buen razonamiento

La propuesta de que la lógica es el estudio del buen razonamiento tiene su base en el nacimiento del estudio sistemático de las reglas lógicas en la Antigua Grecia. Durante este período, la lógica abarcó una gama más amplia de temas que la lógica formal en la actualidad, incluyendo la dialéctica, la retórica y la evaluación de definiciones. Sin embargo, como es el caso ahora, la lógica se le dio la doble tarea de actuar como un instrumento para un buen razonamiento y como un área independiente de la filosofía que estudia estos principios: La lógica se originó como una ciencia para discriminar entre lo que es verdadero y lo que es falso, y para mostrar qué razonamiento realmente se adhiere al camino de la prueba argumentativa válida. Entre las diversas ramas de la filosofía, la lógica tiene dos prerrogativas: tiene tanto el honor de ser la primera como la distinción de servir como un instrumento eficaz en todo el cuerpo de conocimiento.

Para aclarar estos roles, los filósofos en la Edad Media introdujeron una distinción entre (i) lógica naturalis, las normas de razonamiento que los humanos realmente siguen, y (ii) lógica artificialis, las reglas establecidas por el campo de la lógica[7]. Aunque la lógica artificialis constituía una ciencia por derecho propio, con su propio objeto de estudio distintivo, se esperaba que las leyes que producía informaran nuestros procesos de razonamiento reales (lógica naturalis). En otras palabras, la lógica era tanto una ciencia como un instrumento. La pregunta, entonces, era hasta qué punto la lógica artificialis de la época, la silogística, cumplía con éxito esta función instrumental.

Tanto Descartes como Bacon criticaron famosamente la lógica silogística por no ser un organon eficaz. Mientras que para Descartes, las formas eran, en el mejor de los casos, herramientas pedagógicas para quienes aún perfeccionaban sus habilidades intelectuales, no útiles para quienes ya tenían la mente clara desde el punto de vista lógico, para Bacon, las formas eran inútiles para proporcionar a los filósofos naturales los medios para hacer nuevos descubrimientos; de ahí la necesidad de un nuevo Organon[8].

De manera similar, Locke criticó las formas por aportar poco a nuestra comprensión de si un argumento en particular es (in)válido. Más bien, son meras codificaciones de aquellos argumentos que ya consideramos razonables al apreciar las relaciones entre las ideas que contienen. Por lo tanto, si no se consideran razonables las instancias de las formas silogísticas desde el principio, las formas en sí mismas tendrán poca fuerza elucidatoria. Por lo tanto, si bien son correctas como codificaciones de estas inferencias aceptables existentes (el rol de la lógica como ciencia), las formas no cumplen su función instrumental. La doble función de la lógica también se evidencia en la obra de los defensores de la lógica artificialis, quienes defendían la ciencia basándose en que podía guiar eficazmente el razonamiento. Que las lógicas artificiales son necesarias para regular nuestros estándares inferenciales existentes y evitar errores innecesarios. Pues cuando el buen sentido natural emprende el análisis de un razonamiento sin la ayuda de la lógica, a veces se encuentra con cierta dificultad en cuanto a la validez de las inferencias, al descubrir, por ejemplo, que el razonamiento implica algún modo silogístico que, sin duda, es sólido, pero que no es de uso común. Así, incluso para el más ferviente defensor de la lógica formal durante este período, la lógica artificialis se reconocía como importante no solo porque constituía el estudio de argumentos correctos, sino porque servía como un instrumento eficaz para la lógica naturalis.

Este contexto histórico es instructivo en dos aspectos. En primer lugar, nos ayuda a apreciar por qué la filosofía contemporánea concede tanta importancia al valor instrumental de la lógica para informar el razonamiento, incluso utilizando este propósito instrumental para definir el objeto de la lógica. Por ejemplo, los autores contemporáneos a menudo proponen el estudio de (una subclase de) buen razonamiento como la aplicación canónica de la lógica[9]. Si bien los términos lógica artificialis y naturalis han salido de nuestro léxico, reemplazados por lógica formal y lógica del razonamiento, respectivamente, todavía existe la expectativa de que los frutos de la primera informen al segundo. Por lo tanto, incluso si las lógicas entendidas como cálculos matemáticos ahora se utilizan para muchos propósitos, incluido el modelado de la composición de significado[10] y los ingresos nacionales, es común escuchar que la aplicación filosóficamente primaria de nuestras lógicas (los productos de la lógica artificialis) es el razonamiento, lo que nos permite identificar el razonamiento que es lógicamente bueno o, para abreviar, "lógico".

En segundo lugar, reconocer este doble papel de la lógica artificialis como ciencia propia y como instrumento de razonamiento explica en cierta medida cómo se han producido equívocos de la “epistemología de la lógica”, aplicándose el adjetivo “lógico” por igual a aquellos razonamientos en lenguaje natural que las lógicas formales supuestamente sancionan. Por ejemplo, la inferencia de «Iré a Morelia este fin de semana» sobre la base de «Iré a Zamora o a Morelia este fin de semana» y «No volveré a ir a Zamora» se considera lógica porque está sancionada por la regla (supuestamente válida) del silogismo disyuntivo expresada por las lógicas formales. Este equívoco se hace patente cuando se habla de “inferencias lógicas”, que pueden utilizarse para referirse por igual a las reglas de implicación dentro de una lógica y a inferencias particulares realizadas dentro del lenguaje natural sancionadas por estas reglas. Así, el adjetivo (y honorífico) “lógico” ha llegado a representar ambiguamente los principios de la lógica y las instancias de razonamiento a las que estos principios se aplican. Esta ambigüedad puede tener consecuencias desafortunadas para la epistemología de la lógica.

4.5.3 Equiparar la epistemología de la lógica con la del razonamiento lógico

La epistemología de la lógica se pregunta:

- ¿Cómo justificamos nuestras creencias lógicas (por ejemplo, la ley de no-contradicción es verdadera)?

- ¿Qué tipo de conocimiento es el conocimiento lógico: a priori, empírico, conceptual, convencional o práctico?

- ¿Cómo explicamos el desacuerdo lógico entre sistemas (clásico, intuicionista, paraconsistente)?

La intuición racional es la facultad mediante la cual la mente capta de manera directa y evidente una verdad racional, sin necesidad de razonamiento discursivo. Axiomas lógicos o matemáticos: se consideran conocidos de forma inmediata por intuición racional. Epistemología del a priori: cómo es posible el conocimiento independiente de la experiencia. Filosofía analítica y ética: cuando se apela a intuiciones morales o conceptuales para fundamentar juicios racionales.

Una consecuencia de equiparar la lógica con el estudio del buen razonamiento es que las discusiones sobre la epistemología de la lógica se deslizan fácilmente hacia la epistemología del buen razonamiento. Especificar la epistemología de la lógica se convierte simplemente en especificar la del buen razonamiento: bajo qué condiciones un individuo razona de manera confiable, lógicamente hablando, o bajo qué condiciones un individuo está justificado para hacer inferencias (supuestamente lógicas). Esto ha llevado a una diferenciación insuficiente entre los requisitos necesarios para estar justificado al hacer una inferencia particular (supuestamente lógica) y los necesarios para estar justificado al proponer una lógica. La epistemología de la lógica artificialis se ha equiparado con la de la lógica naturalis o se ha ignorado como el costo de enfocarse en esta última. Un ejemplo del primer problema se ilustra en el caso de BonJour sobre la indispensabilidad de la intuición racional para la justificación epistémica. En lo que respecta a la justificación lógica, BonJour aborda la necesidad de la intuición racional para justificar de golpe las inferencias (lógicas) y nuestras creencias sobre las leyes lógicas[11]. La intuición racional es necesaria para explicar nuestro éxito al hacer inferencias a partir de conjuntos de premisas hasta una conclusión, ya que ni la justificación empírica ni la analiticidad pueden explicar la justificación inferencial. Sin embargo, BonJour plantea exactamente el mismo punto sobre la justificación de ciertas leyes lógicas, como la ley de no contradicción. Nuestra justificación para estas leyes no puede provenir plausiblemente de fuentes empíricas ni de la analiticidad; solo la intuición racional será suficiente. Por lo tanto, no se hace ninguna diferenciación entre los requisitos epistémicos para razonar (lógicamente) y estar justificado al creer en las leyes lógicas. Ambos se adquieren directamente a través de la intuición. De hecho, BonJour se mueve libremente entre hablar sobre la necesidad de la intuición racional para justificar inferencias y leyes lógicas: “Cuando considero cuidadosa y reflexivamente la proposición (o inferencia) en cuestión, puedo simplemente ver, captar o aprehender que la proposición es necesaria, que debe ser verdadera en cualquier mundo o situación posible (o alternativamente, que la conclusión de la inferencia debe ser verdadera si las premisas son verdaderas)”. Sin embargo, no hay razón para asumir que las condiciones bajo las cuales estamos justificados para hacer inferencias de cierto tipo deben ser las mismas que determinan cuándo estamos justificados para creer en los principios que las sancionan. Por supuesto, pueden resultar ser las mismas, pero no separar ambos asuntos nos impide abordar adecuadamente la cuestión. En otras ocasiones, interpretar la epistemología de la lógica como la epistemología del razonamiento (exitoso) se ejemplifica como una omisión total de cómo justificamos nuestras mejores teorías lógicas, como en el intento de Schechter de proporcionar una explicación naturalista de la justificación del “pensador ordinario” de la lógica en términos de selección natural[12]. Para Schechter, la epistemología de la lógica “tiene dos tareas explicativas principales: explicar cómo nuestras creencias lógicas son fiables y cómo somos epistémicamente responsables de creer como lo hacemos”. Sin embargo, aunque Schechter habla explícitamente de creencias lógicas en lugar de inferencias, no le preocupa cómo llegamos a determinar las leyes lógicas correctas (es decir, cuestiones de lógica artificialis). Más bien, le preocupa cómo los individuos llegan a deducir de forma fiable y, en consecuencia, a creer en afirmaciones cotidianas del lenguaje natural, como ”Toda mosca es una mosca”, que la lógica correcta (sea cual sea esta última) considera lógicamente verdaderas. En otras palabras, Schechter se ocupa exclusivamente de la fiabilidad de la lógica naturalis. Aquí, la epistemología de las principales tareas de la lógica se concibe de forma que se centre exclusivamente en la fiabilidad de la lógica naturalis, omitiendo cualquier consideración de cómo llegamos a estar justificados al creer en la lógica correcta que sanciona estas prácticas inferenciales.

Un ejemplo más complejo e instructivo es la explicación naturalista alternativa de la lógica de Maddy, que es simultáneamente un proyecto metafísico que proporciona una explicación de lo que fundamenta los hechos lógicos y una teoría de cómo llegamos a creer de forma fiable en las verdades lógicas resultantes[13]. En ambos casos, en consonancia con los principios naturalistas, Maddy pretende trabajar desde "dentro de la ciencia", utilizando sus métodos y las mejores teorías actuales. La respuesta de Maddy a la pregunta metafísica es que los hechos lógicos se fundamentan en las características estructurales del mundo. Específicamente, nuestro mundo exhibe una estructura KF (abreviatura de estructura Kant-Frege), lo que significa que "consiste en un dominio de objetos que tienen propiedades y se encuentran en relaciones, quizás algunas propiedades universales, más compuestos de estas que involucran conjunciones, disyunciones y negaciones, y [que] algunas interconexiones entre estas situaciones son dependencias robustas consecuentes del terreno". Lo que resulta de estas estructuras KF es la verdad de una "lógica rudimentaria", con similitudes con la lógica fuerte de Kleene con lagunas de valores de verdad. La pregunta epistemológica se responde entonces proponiendo que los individuos son adecuadamente sensibles a estos hechos lógicos en virtud de su aparato cognitivo que les permite "detectar y representar" estas características estructurales del mundo. El panorama general es audaz y atractivo. Proporciona una explicación de la lógica que mantiene su objetividad sin apelar a un tercer reino platónico. Sin embargo, existe una ambigüedad en la obra de Maddy sobre el tema de esta justificación “lógica”, que impacta la epistemología resultante. ¿Esta sensibilidad a los hechos lógicos nos proporciona las leyes de la lógica que constituyen nuestras mejores teorías lógicas, o simplemente permite a los individuos adoptar prácticas inferenciales confiables que les brindan creencias que resultan ser (lógicamente) verdaderas? En otras palabras, ¿le preocupa a Maddy proporcionar una epistemología de la lógica artificialis o una explicación de la confiabilidad de la lógica naturalis? A veces, Maddy tiene claro que se trata de esto último: “las verdades lógicas que tengo en mente son los ejemplos más simples e incontrovertibles”, como «Si todos los robles son árboles y este es un roble, entonces este debe ser un árbol». Por lo tanto, más que leyes lógicas, a Maddy le preocupa cómo los individuos llegan a formar creencias confiables (lógicamente correctas), como Schechter. Sin embargo, al mismo tiempo, Maddy también parece interesada en explicar cómo, dado que la lógica rudimentaria es cierta en nuestro mundo, llegamos a respaldar la lógica clásica. Una pregunta que no tiene nada que ver con la fiabilidad de la lógica naturalis, sino más bien con lo que justifica nuestra aprobación de nuestra mejor teoría lógica (que se presume es la lógica clásica). La propuesta de Maddy es que la lógica clásica es una idealización de la lógica rudimentaria, a la que se llega al suponer que cada predicado tiene un límite definido, que todos los nombres se refieren a ella y que el condicional se comporta de manera veritativo-funcional en lugar de representar causalidad. Claramente, ahora hemos pasado a la cuestión epistemológica distinta de qué justifica nuestra aprobación de una lógica particular; una epistemología de la lógica artificialis. Sin embargo, como epistemología de la lógica artificialis, es insuficiente. No se nos proporcionan detalles de cómo descubrimos y finalmente llegamos a estar justificados en creer en esta teoría (idealizada) de los hechos lógicos. ¿Qué es lo que justifica nuestra aprobación de la lógica clásica, en lugar de, digamos, una lógica constructivista?

La lógica constructivista parte de la idea de que solo existen las entidades matemáticas que pueden construirse efectivamente. En lugar de aceptar que una proposición es verdadera o falsa independientemente de que lo sepamos, sostiene que: “Una proposición es verdadera solo si podemos demostrarla constructivamente.” La verdad equivale a demostrabilidad y la negación de una proposición significa que “suponerla conduce a una contradicción”. El sistema formal más conocido de lógica constructivista es la lógica intuicionista desarrollada por Heyting, quien formalizó las ideas de Brouwer. Su cálculo proposicional y de predicados se parece al clásico, pero con reglas modificadas para evitar el uso del tercero excluido. Es la base lógica de la teoría de tipos y de la correspondencia de Curry–Howard, que vincula demostraciones con programas computacionales: “Demostrar es construir un programa; la verdad es su ejecución exitosa.”